Herramientas

Entidades

Ver todas las entidadesEstadísticas de incidentes

Risk Subdomain

3.1. False or misleading information

Risk Domain

- Misinformation

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Informes del Incidente

Cronología de Informes

Several big businesses have published source code that incorporates a software package previously hallucinated by generative AI.

Not only that but someone, having spotted this reoccurring hallucination, had turned that made-up dependency in…

Los modelos de IA parecen incapaces de dejar de inventar cosas. Como señalan dos estudios recientes, esta tendencia subraya las advertencias previas de no confiar en los consejos de la IA para nada realmente importante.

Algo que la IA inven…

El auge de las herramientas de generación de código basadas en LLM está transformando la forma en que los desarrolladores escriben software y, en el proceso, presenta nuevos riesgos para la cadena de suministro.

Estos asistentes de codifica…

Una nueva clase de ataques a la cadena de suministro, denominada "slopsquatting", ha surgido debido al creciente uso de herramientas de IA generativa para la programación y a la tendencia del modelo a "alucinar" nombres de paquetes inexiste…

Variantes

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Hackers Break Apple Face ID

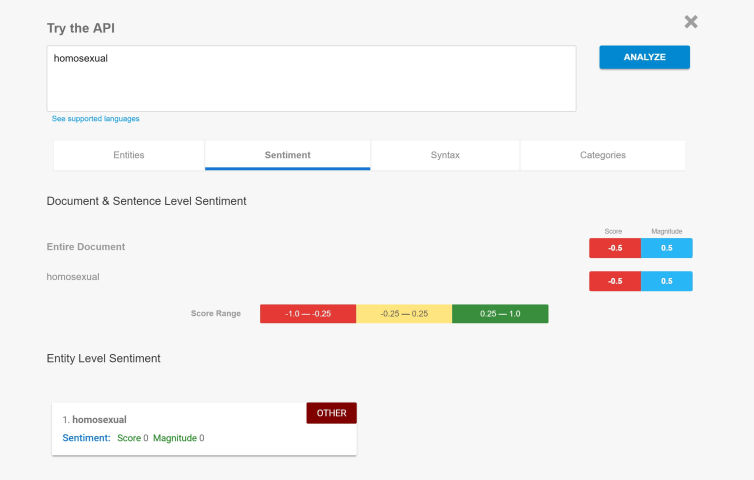

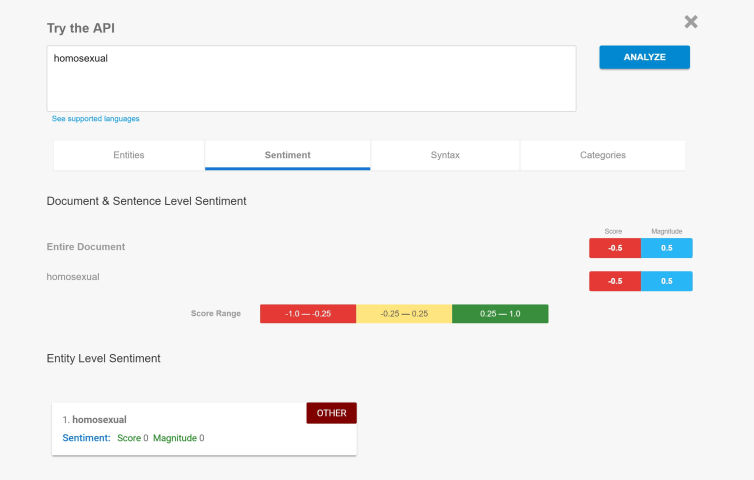

Biased Sentiment Analysis

All Image Captions Produced are Violent

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Hackers Break Apple Face ID

Biased Sentiment Analysis