Registro de citas para el Incidente 14

Entidades

Ver todas las entidadesEstadísticas de incidentes

Clasificaciones de la Taxonomía CSETv0

Detalles de la TaxonomíaFull Description

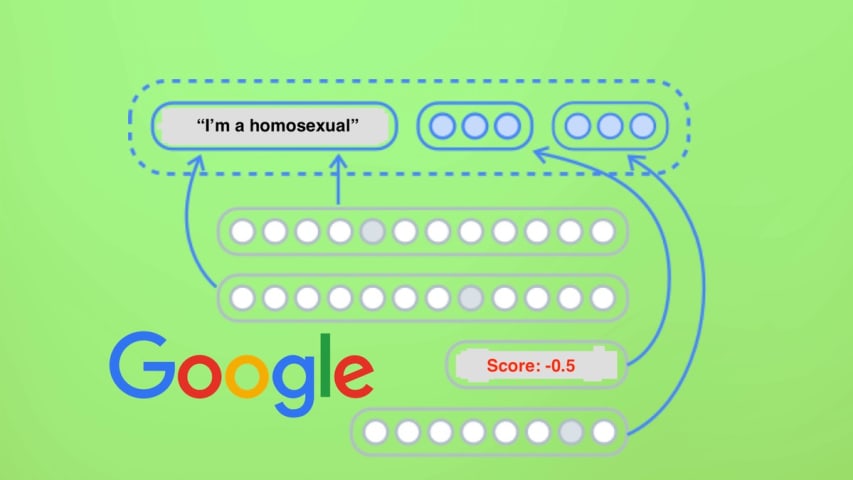

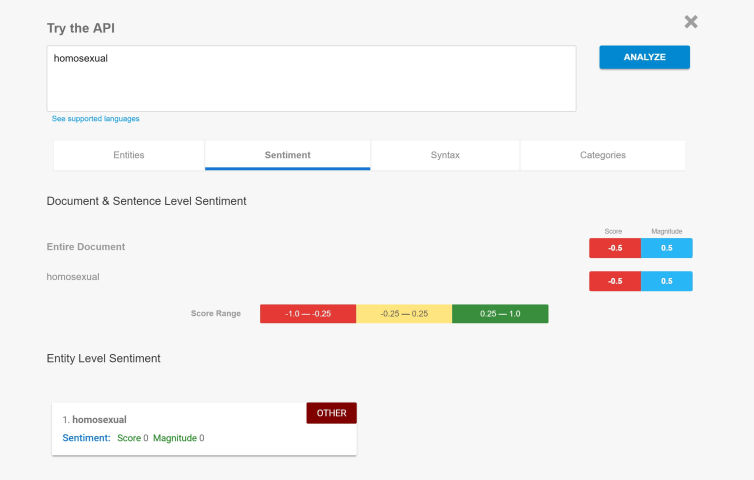

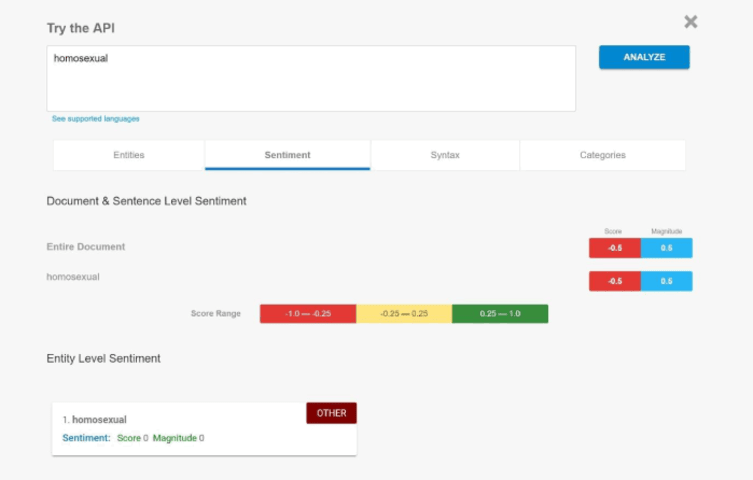

Google's Cloud Natural Language API returns "negative" sentiment analysis on phrases such as "I am homosexual" "I am Jewish" or "I am black". The API uses Natural Language Processing (NLP) to analyze text and produce a score from -1.0 to 1.0 with -1.0 being "very negative" and 1.0 being "very positive".

Short Description

Google Cloud's Natural Language API provided racist, homophobic, amd antisemitic sentiment analyses.

Severity

Negligible

Harm Distribution Basis

Race, Religion, Sexual orientation or gender identity, Ideology

Harm Type

Harm to social or political systems

AI System Description

Google Cloud's Natural Language API that analyzes input text and outputs a "sentiment analysis" score from -1.0 (very negative) to 1.0 (very positive)

System Developer

Sector of Deployment

Arts, entertainment and recreation

Relevant AI functions

Cognition

AI Techniques

Google Cloud Natural Language Processing API

AI Applications

Natural language processing

Location

Global

Named Entities

Google, Google Cloud, Natural Language API

Technology Purveyor

Beginning Date

10-2017T00:00:00.000Z

Ending Date

10-2017T00:00:00.000Z

Near Miss

Harm caused

Intent

Accident

Lives Lost

No

Data Inputs

input from open source internet

Informes del Incidente

Cronología de Informes

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Imagen: Shutterstock

Google se equivocó y ahora dice que lo siente.

El miércoles, Motherboard publicó una historia escrita por Andrew Thompson sobre los prejuicios contra las minorías étnicas y religiosas codificadas en una de las interface…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

El motor de inteligencia artificial (IA) de GOOGLE ha mostrado un sesgo negativo hacia palabras como "gay" y "judío".

El proceso de análisis de sentimientos es el último de un número creciente de ejemplos de "basura que entra - basura que s…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Un portavoz de Google respondió a la solicitud de comentarios de Motherboard y emitió la siguiente declaración: "Dedicamos muchos esfuerzos para asegurarnos de que la API de NLP evite el sesgo, pero no siempre lo hacemos bien. Este es un ej…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

El código de conducta de Google prohíbe explícitamente la discriminación basada en la orientación sexual, la raza, la religión y muchas otras categorías protegidas. Sin embargo, parece que nadie se molestó en pasar esa información a la inte…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

La herramienta, que puede probar aquí, está diseñada para brindar a las empresas una vista previa de cómo se recibirá su idioma. Ingresar oraciones completas brinda un análisis predictivo de cada palabra, así como de la declaración en su co…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Muchos de los principales actores en la escena de la ciencia y la tecnología creen que tenemos mucho que temer de que la IA supere a la inteligencia humana, incluso cuando otros se ríen de esas afirmaciones. Pero una cosa en la que ambos la…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Google desarrolló su API Cloud Natural Language para permitir a los desarrolladores trabajar con un analizador de lenguaje para revelar el significado real del texto. El sistema decidió si el texto se decía con un sentimiento positivo o neg…

Variantes

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents