Incident 59: Les préjugés sexistes dans Google Traduction

Entités

Voir toutes les entitésClassifications de taxonomie CSETv0

Détails de la taxonomieProblem Nature

Specification

Physical System

Software only

Level of Autonomy

Medium

Nature of End User

Amateur

Public Sector Deployment

No

Data Inputs

User entered translation requests

Classifications de taxonomie CSETv1

Détails de la taxonomieIncident Number

59

AI Tangible Harm Level Notes

Although AI was implicated in the adverse outcome, this incident has no tangible harm.

Notes (special interest intangible harm)

The study found biases related to gender and age in Google Translate. Additional biases have been found in Natural Language Processing in general.

Special Interest Intangible Harm

yes

Risk Subdomain

1.1. Unfair discrimination and misrepresentation

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Rapports d'incidents

Chronologie du rapport

L'intelligence artificielle et l'apprentissage automatique connaissent une croissance fulgurante. Cependant, on craint que ces technologies ne soient utilisées, intentionnellement ou non, pour perpétuer les préjugés et l'injustice qui carac…

Même l'intelligence artificielle peut acquérir des préjugés contre la race et le sexe

L'une des grandes promesses de l'intelligence artificielle (IA) est un monde exempt de petits préjugés humains. L'embauche par algorithme donnerait aux ho…

Les algorithmes d'apprentissage automatique détectent des préjugés raciaux et sexistes profondément enracinés cachés dans les modèles d'utilisation de la langue, selon les scientifiques

Il a été démontré qu'un outil d'intelligence artificie…

Dans les débats sur l'avenir de l'intelligence artificielle, de nombreux experts pensent que ces systèmes basés sur des machines sont froidement logiques et objectivement rationnels. Mais dans une nouvelle étude, des chercheurs de l'Univers…

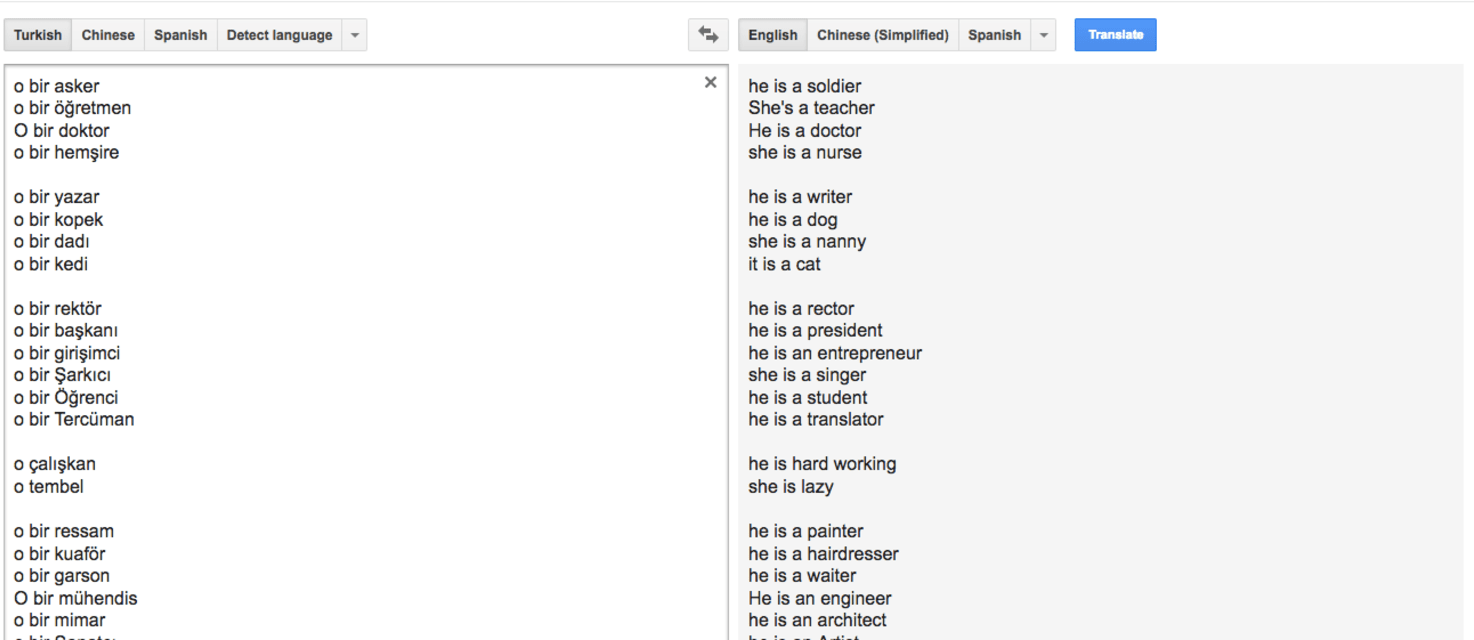

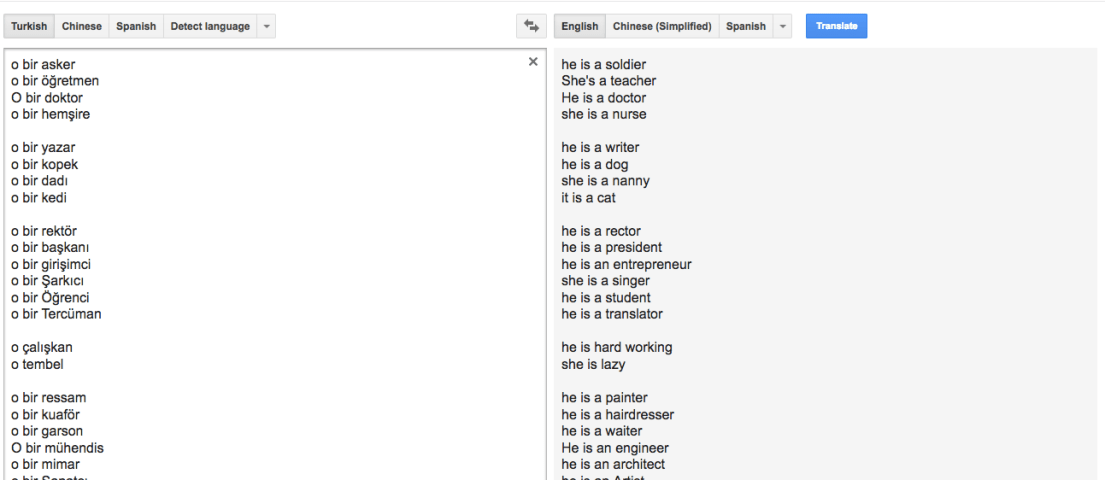

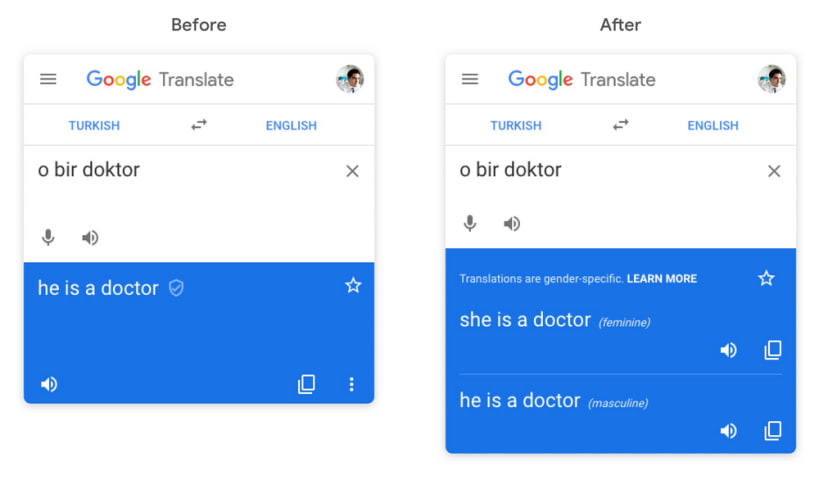

Dans la langue turque, il existe un pronom, "o", qui couvre tous les types de troisième personne du singulier. Que ce soit un il, une elle ou un ça, c'est un "o". Ce n'est pas le cas en anglais. Ainsi, lorsque Google Translate passe du turc…

Une grande partie de notre vie est déterminée par des algorithmes. De ce que vous voyez sur votre fil d'actualité Facebook, aux livres et bibelots recommandés par Amazon, aux vidéos dérangeantes que YouTube montre à vos enfants, notre atten…

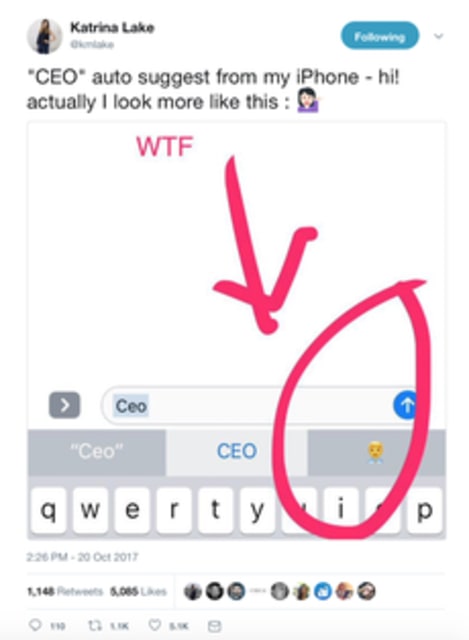

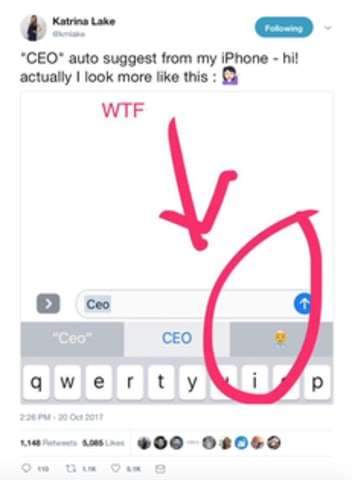

Image via Twitter

Les parents ne connaissent que trop bien le défi particulier d'élever des enfants : leur apprendre à faire ce que nous disons, pas ce que nous faisons.

Un défi similaire a frappé l'intelligence artificielle.

Alors que de p…

Récemment, il y a eu une préoccupation croissante concernant les biais de la machine, où les modèles statistiques entraînés se développent pour refléter des asymétries sociétales controversées, telles que les préjugés sexistes ou raciaux. I…

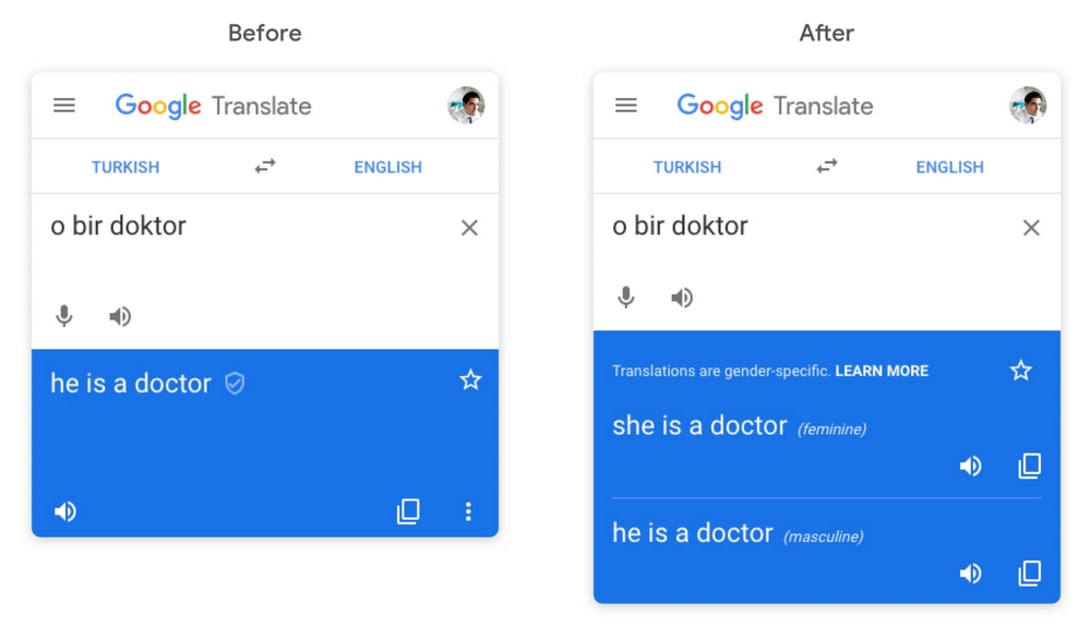

Google s'efforce de réduire les préjugés sexistes perçus dans Google Translate, a-t-il annoncé aujourd'hui. À partir de cette semaine, les utilisateurs qui traduisent des mots et des phrases dans les langues prises en charge obtiendront des…

Une expérience montre que Google Traduction modifie systématiquement le genre des traductions lorsqu'elles ne correspondent pas aux stéréotypes. C'est à cause de l'anglais, dit Google.

Si vous deviez lire une histoire sur des historiens mas…

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

AI Beauty Judge Did Not Like Dark Skin

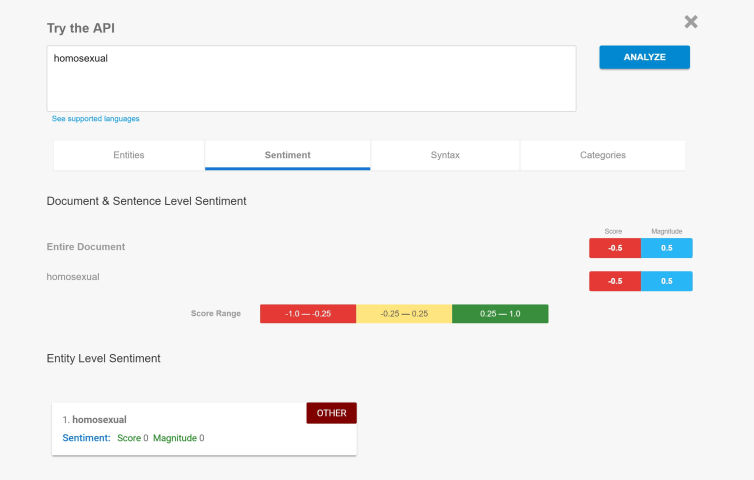

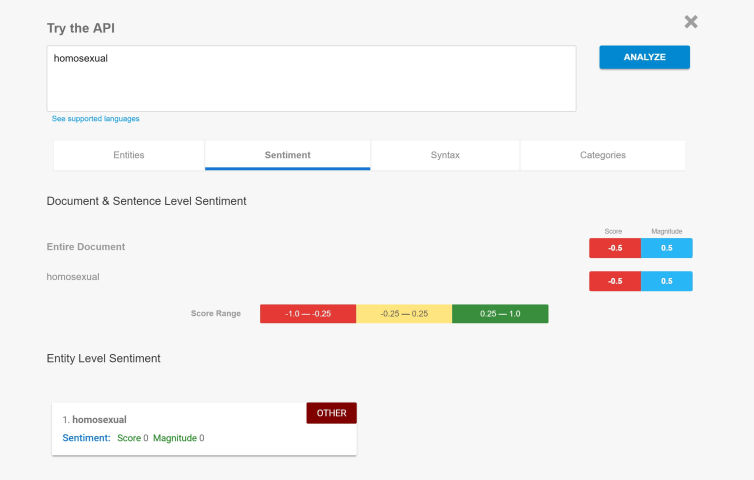

Biased Sentiment Analysis

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

AI Beauty Judge Did Not Like Dark Skin