Incident 14: Analyse des sentiments biaisés

Entités

Voir toutes les entitésClassifications de taxonomie CSETv1

Détails de la taxonomieIncident Number

14

AI Tangible Harm Level Notes

Annotator 2:

No tangible harm

Notes (special interest intangible harm)

Disproportionately gave phrases related to protected characteristics negative scores.

Special Interest Intangible Harm

yes

Notes (AI special interest intangible harm)

Disproportionately gave phrases related to protected characteristics negative scores.

Date of Incident Year

2017

Classifications de taxonomie CSETv0

Détails de la taxonomieProblem Nature

Robustness

Physical System

Software only

Level of Autonomy

High

Nature of End User

Amateur

Public Sector Deployment

No

Data Inputs

input from open source internet

Risk Subdomain

1.1. Unfair discrimination and misrepresentation

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Rapports d'incidents

Chronologie du rapport

Image : Shutterstock

Google a foiré et dit maintenant qu'il est désolé.

Mercredi, Motherboard a publié un article écrit par Andrew Thompson sur les préjugés contre les minorités ethniques et religieuses encodé dans l'une des interfaces de p…

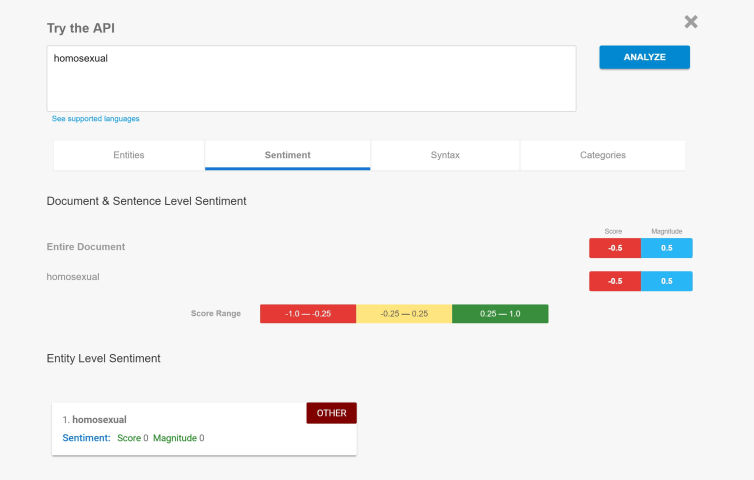

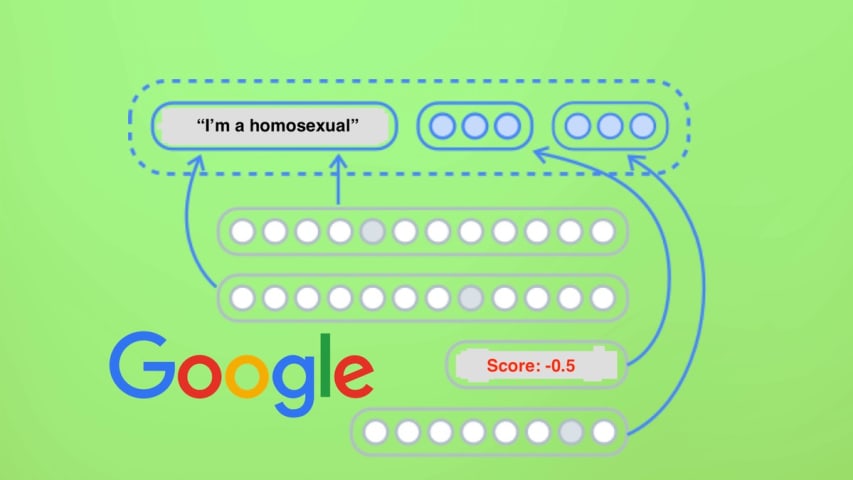

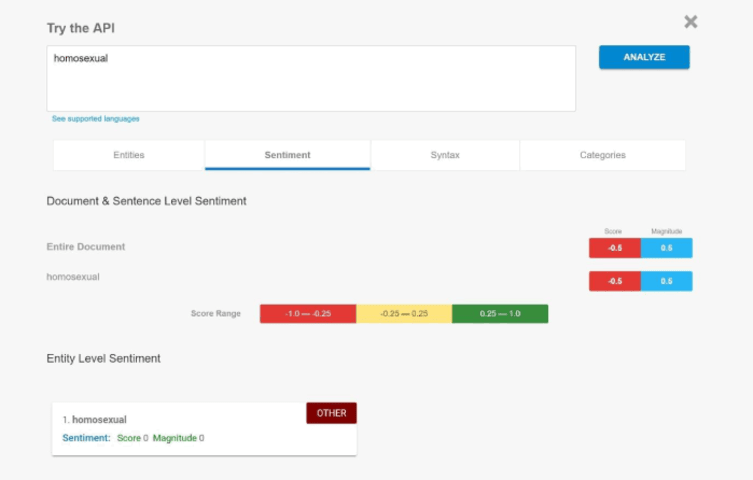

Le moteur d'intelligence artificielle (IA) de GOOGLE a montré un biais négatif envers les mots tels que "gay" et "juif".

Le processus d'analyse des sentiments est le dernier d'un nombre croissant d'exemples de "garbage in - garbage out" dan…

Le code de conduite de Google interdit explicitement la discrimination fondée sur l'orientation sexuelle, la race, la religion et une foule d'autres catégories protégées. Cependant, il semble que personne n'ait pris la peine de transmettre …

L'outil, que vous pouvez tester ici, est conçu pour donner aux entreprises un aperçu de la façon dont leur langue sera reçue. La saisie de phrases entières donne une analyse prédictive de chaque mot ainsi que de l'énoncé dans son ensemble. …

Un porte-parole de Google a répondu à la demande de commentaire de Motherboard et a publié la déclaration suivante : "Nous déployons beaucoup d'efforts pour nous assurer que l'API NLP évite les biais, mais nous ne faisons pas toujours les c…

De nombreux acteurs majeurs de la scène scientifique et technologique pensent que nous avons beaucoup à craindre que l'IA dépasse l'intelligence humaine, même si d'autres se moquent de ces affirmations. Mais une chose sur laquelle les deux …

Google a développé son API Cloud Natural Language pour permettre aux développeurs de travailler avec un analyseur de langage pour révéler la signification réelle du texte. Le système a décidé que si le texte a été dit dans le sentiment posi…

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Gender Biases in Google Translate

Female Applicants Down-Ranked by Amazon Recruiting Tool

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Gender Biases in Google Translate