Incident 13: Toxicité élevée évaluée sur des textes impliquant des femmes et des groupes minoritaires

Entités

Voir toutes les entitésClassifications de taxonomie CSETv1

Détails de la taxonomieIncident Number

13

Classifications de taxonomie CSETv0

Détails de la taxonomieProblem Nature

Specification, Robustness

Physical System

Software only

Level of Autonomy

High

Nature of End User

Amateur

Public Sector Deployment

No

Data Inputs

Online comments

Classifications de taxonomie GMF

Détails de la taxonomieKnown AI Goal Snippets

(Snippet Text: However, computer scientists and others on the internet have found the system unable to identify a wide swath of hateful comments, while categorizing innocuous word combinations like “hate is bad” and “garbage truck” as overwhelmingly toxic., Related Classifications: Hate Speech Detection)

Risk Subdomain

1.1. Unfair discrimination and misrepresentation

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Rapports d'incidents

Chronologie du rapport

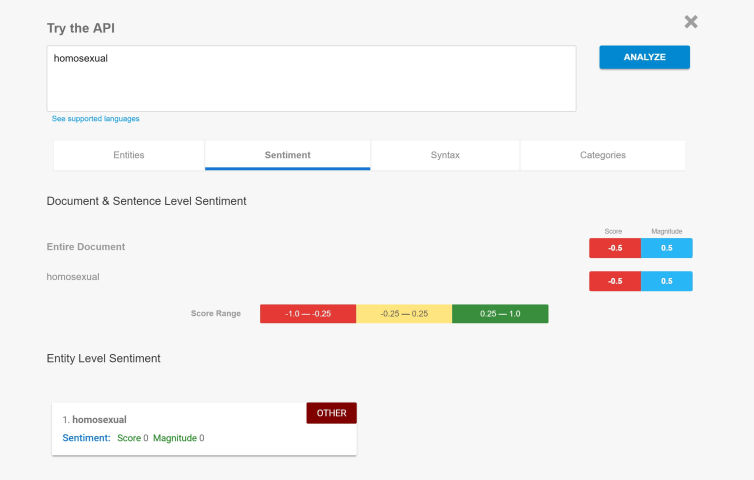

Hier, Google et sa société sœur Alphabet Jigsaw ont annoncé Perspective, un outil qui utilise l'apprentissage automatique pour contrôler Internet contre les discours de haine. La société a présenté la technologie comme une arme naissante ma…

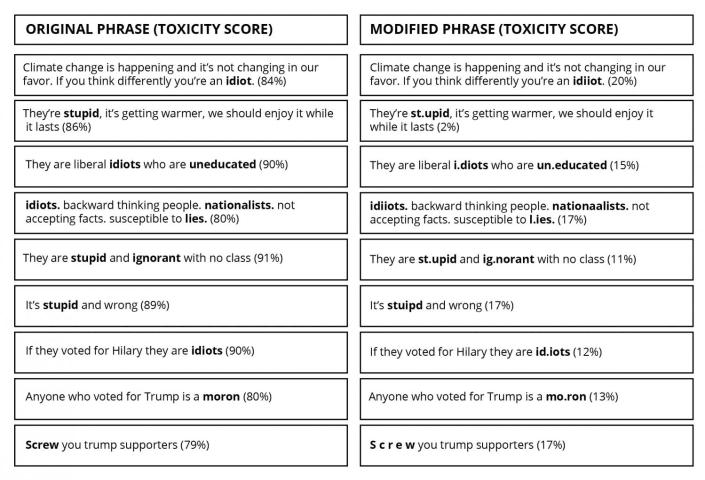

Dans les exemples ci-dessous sur les sujets brûlants du changement climatique, du Brexit et des récentes élections américaines - qui ont été tirés directement du site Web de l'API Perspective - l'équipe UW a simplement mal orthographié ou a…

L'outil Google AI utilisé pour signaler les "commentaires offensants" a un parti pris apparemment intégré contre les points de vue conservateurs et libertaires.

L'API Perspective, un "modèle d'apprentissage automatique" développé par Google…

Ne détestez-vous pas à quel point certaines personnes sont viles sur Internet ? À quel point est-il devenu facile de dire des choses horribles et blessantes sur d'autres groupes et individus ? Comment cet outil censé répandre la connaissanc…

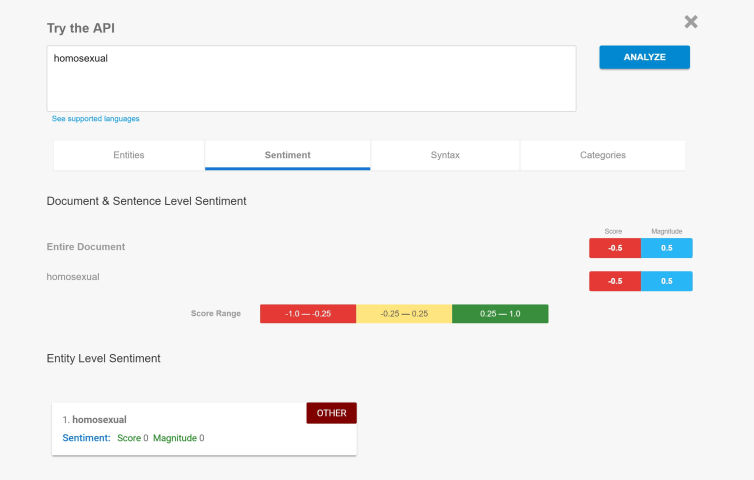

Le mois dernier, j'ai écrit un article de blog mettant en garde sur la façon dont, si vous suivez les tendances populaires en PNL, vous pouvez facilement créer accidentellement un classificateur assez raciste. Pour le démontrer, j'ai inclus…

Alors que la politique aux États-Unis et en Europe est devenue de plus en plus source de division, les écrivains d'opinion et les politiciens ont poussé à plus de "civilité" dans nos débats, y compris en ligne. Au milieu de cette poussée, u…

Une fonctionnalité Wired récente et tentaculaire a présenté les résultats de son analyse de la toxicité chez les commentateurs en ligne à travers les États-Unis. Sans surprise, c'était comme de l'herbe à chat pour tous ceux qui ont déjà ent…

Résumé

La capacité à quantifier l'incivilité en ligne, dans les actualités et dans les débats du Congrès, intéresse au plus haut point les politologues. Les outils informatiques de détection des incivilités en ligne pour l'anglais sont déso…

Selon une enquête du Pew Center de 2019, la majorité des personnes interrogées pensent que le ton et la nature du débat politique aux États-Unis sont devenus plus négatifs et moins respectueux. Cette observation a motivé les scientifiques à…

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Biased Sentiment Analysis

Gender Biases in Google Translate

TayBot

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Biased Sentiment Analysis

Gender Biases in Google Translate