Incident 6: TayBot

Entités

Voir toutes les entitésClassifications de taxonomie CSETv1

Détails de la taxonomieIncident Number

6

Notes (special interest intangible harm)

4.6 - Tay's tweets included racist and misogynist content, far-right ideology, and harmful content against certain religions, etc.

Special Interest Intangible Harm

yes

Date of Incident Year

2016

Date of Incident Month

03

Date of Incident Day

23

Classifications de taxonomie CSETv0

Détails de la taxonomieProblem Nature

Specification, Robustness, Assurance

Physical System

Software only

Level of Autonomy

Medium

Nature of End User

Amateur

Public Sector Deployment

No

Data Inputs

Twitter users' input

Risk Subdomain

1.2. Exposure to toxic content

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Rapports d'incidents

Chronologie du rapport

Microsoft a dévoilé hier le bot d'intelligence artificielle Twitter @TayandYou dans le but de se connecter avec la génération Y et "d'expérimenter" avec la compréhension conversationnelle.

La cascade artificielle du bot Twitter de Microsoft…

Moins d'un jour après avoir rejoint Twitter, le bot IA de Microsoft, Tay.ai, a été démantelé pour être devenu un monstre sexiste et raciste. Les experts en intelligence artificielle expliquent pourquoi cela s'est terriblement mal passé.

Ima…

Hier, Microsoft a lancé Tay, le chatbot AI pour adolescents conçu pour imiter et converser avec les utilisateurs en temps réel. Parce que le monde est un endroit terrible rempli de gens merdiques, beaucoup de ces utilisateurs ont profité de…

Un jour après que Microsoft a présenté un robot de chat innocent d'Intelligence Artificielle sur Twitter, il a dû le supprimer après qu'il se soit transformé en un maléfique épris d'Hitler, faisant la promotion du sexe incestueux, et procla…

Il a fallu moins de 24 heures à Twitter pour corrompre un chatbot IA innocent. Hier, Microsoft a dévoilé Tay – un bot Twitter que la société a décrit comme une expérience de "compréhension conversationnelle". Plus vous discutez avec Tay, a …

La page Twitter de Tay Microsoft Le nouveau chatbot IA de Microsoft a déraillé mercredi, publiant un déluge de messages incroyablement racistes en réponse aux questions.

La société de technologie a présenté "Tay" cette semaine - un bot qui …

Tay de Microsoft est un exemple de mauvaise conception

ou Pourquoi le design d'interaction est important, tout comme le QA-ing.

caroline sinders Bloqué Débloquer Suivre Suivi 24 mars 2016

Hier, Microsoft a lancé une IA pour adolescentes sur…

Pourquoi le chatbot Tay de Microsoft a-t-il échoué et qu'est-ce que cela signifie pour les études sur l'intelligence artificielle ?

Botego Inc Bloqué Débloquer Suivre Suivre 25 mars 2016

Hier, quelque chose qui ressemble à un gros échec s'e…

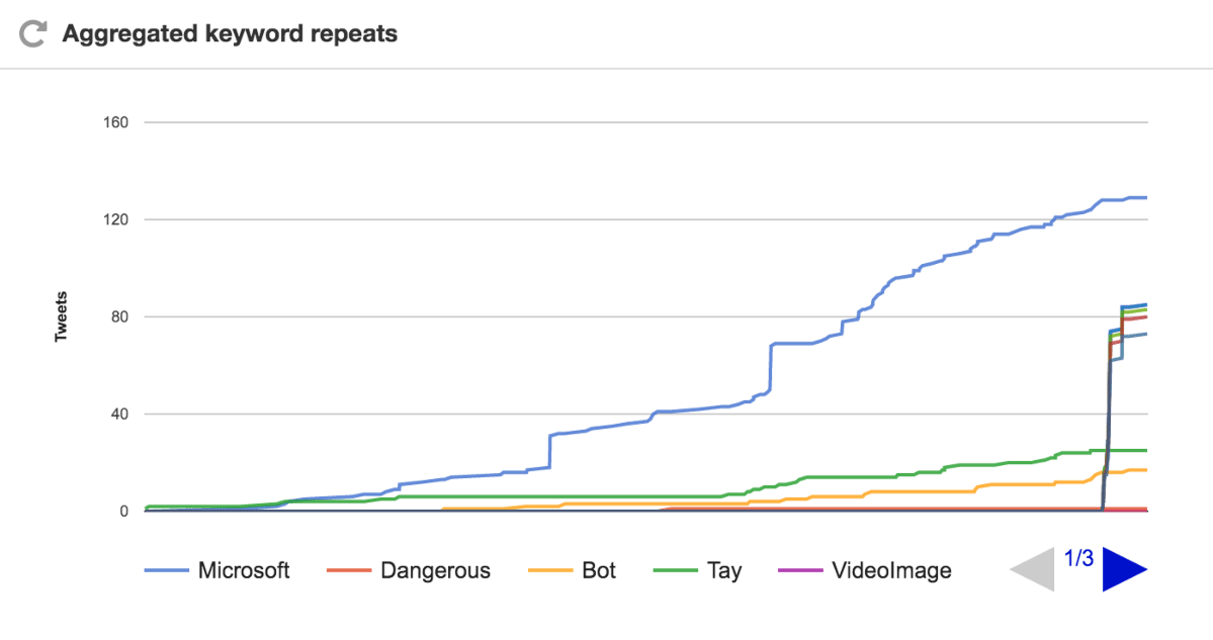

C'était le déroulement d'une malheureuse série d'événements impliquant l'intelligence artificielle, la nature humaine et une expérience très publique. Au milieu de cette dangereuse combinaison de forces, il est presque impossible de détermi…

Cette semaine, Internet a fait ce qu'il fait de mieux et a démontré que A.I. la technologie n'est pas aussi intuitive que la perception humaine, utilisant… le racisme.

Le chatbot d'intelligence artificielle récemment publié par Microsoft, T…

Microsoft a reçu une leçon rapide cette semaine sur le côté obscur des médias sociaux. Hier, la société a lancé "Tay", une intelligence artificielle chatbot conçu pour développer la compréhension conversationnelle en interagissant avec les …

Comme beaucoup d'entre vous le savent maintenant, nous avons lancé mercredi un chatbot appelé Tay. Nous sommes profondément désolés pour les tweets offensants et blessants involontaires de Tay, qui ne représentent pas qui nous sommes ou ce …

Copyright de l'image Microsoft Image caption L'IA a appris à parler comme un adolescent

Microsoft s'est excusé d'avoir créé un chatbot artificiellement intelligent qui s'est rapidement transformé en raciste négationniste.

Mais ce faisant, i…

Il n'a fallu que quelques heures à Internet pour transformer Tay, le bot IA adolescent qui veut discuter avec la génération Y et apprendre d'eux, en Tay, le bot IA raciste et génocidaire qui aimait faire référence à Hitler. Et maintenant, T…

Microsoft a déclaré qu'il était "profondément désolé" pour les messages Twitter racistes et sexistes générés par le soi-disant chatbot qu'il a lancé cette semaine.

La société a publié des excuses officielles après que le programme d'intelli…

La nouvelle de loin la plus divertissante sur l'IA de la semaine dernière a été la montée et la chute rapide du chatbot Twitter de Microsoft, imitant les adolescentes, Tay, dont le slogan Twitter la décrivait comme "la fam de l'IA de Micros…

Un retour de courte durée a vu Tay tweeter sur le fait de fumer de la drogue devant la police avant de subir une crise et d'être mis hors ligne

Cet article a plus de 3 ans

Cet article a plus de 3 ans

La tentative de Microsoft de converser a…

Les humains ont une longue et riche histoire de panique face aux effets possibles de nos technologies. Il y a longtemps, Platon craignait que l'écriture blesse la mémoire des gens et "implante l'oubli dans leur âme". Plus récemment, le cont…

Le successeur de Tay s'appelle Zo et n'est disponible que sur invitation sur l'application de messagerie Kik. Lorsque vous demandez l'accès, le logiciel vous demande votre nom d'utilisateur Kik et votre identifiant Twitter Microsoft

Ayant (…

Lorsque Tay a commencé sa courte vie numérique le 23 mars, il voulait juste bavarder et se faire de nouveaux amis sur le net. Le chatbot, qui a été créé par le département de recherche de Microsoft, a accueilli la journée avec un tweet enth…

BOT ou PAS ? Cette série spéciale explore l'évolution de la relation entre les humains et les machines, en examinant l'impact des robots, de l'intelligence artificielle et de l'automatisation sur notre travail et nos vies.

Tay, le chatbot M…

La responsabilité de l'IA — Étude de cas : l'expérience Tay de Microsoft

Yuxi Liu Bloqué Débloquer Suivre Suivant 16 janvier 2017

Dans cette étude de cas, je décris le chatbot d'intelligence artificielle (IA) de Microsoft, Tay, et décris la…

La science-fiction est moche avec des histoires d'intelligence artificielle devenue folle. Il y a HAL 9000, bien sûr, et l'infâme système Skynet des films "Terminator". L'année dernière, le sinistre AI Ultron a failli vaincre les Avengers, …

Beaucoup de gens associent l'innovation à la technologie, mais l'avancement de la technologie est sujet aux mêmes gaffes embarrassantes que les humains. Nulle part cela n'est plus apparent que dans les chatbots.

La technologie émergente, qu…

LORSQUE TAY A FAIT SES DÉBUTS en mars 2016, Microsoft avait de grands espoirs pour le « chatbot social » alimenté par l'intelligence artificielle. À l'instar des programmes de chat automatisés basés sur du texte que de nombreuses personnes …

Chaque relation fraternelle a ses clichés. La sœur nerveuse, le frère fugitif, le plus jeune surdoué. Dans la famille Microsoft des chatbots d'apprentissage social, les contrastes entre Tay, l'infâme néo-nazie folle de sexe, et sa jeune sœu…

En mars 2016, Microsoft se préparait à lancer [son nouveau chatbot, Tay](https://web.archive.org/web/20160414074049/https : /www.tay.ai/), sur Twitter. Décrit comme une expérience de "compréhension conversationnelle", Tay a été conçu pour e…

Tay était un chatbot d'intelligence artificielle qui a été initialement publié par Microsoft Corporation via Twitter le 23 mars 2016; cela a provoqué une controverse ultérieure lorsque le bot a commencé à publier des tweets incendiaires et …

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

All Image Captions Produced are Violent

Russian Chatbot Supports Stalin and Violence

AI Beauty Judge Did Not Like Dark Skin

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

All Image Captions Produced are Violent

Russian Chatbot Supports Stalin and Violence