Incident 11: Modèles de risque de Northpointe

Entités

Voir toutes les entitésClassifications de taxonomie CSETv1

Détails de la taxonomieIncident Number

11

Classifications de taxonomie CSETv0

Détails de la taxonomieProblem Nature

Unknown/unclear

Physical System

Software only

Level of Autonomy

Medium

Nature of End User

Expert

Public Sector Deployment

Yes

Data Inputs

137-question survey

Risk Subdomain

1.1. Unfair discrimination and misrepresentation

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Rapports d'incidents

Chronologie du rapport

Les programmes informatiques qui effectuent des évaluations des risques des suspects de crime sont de plus en plus courants dans les salles d'audience américaines et sont utilisés à chaque étape des systèmes de justice pénale pour détermine…

Partout au pays, les juges, les agents de probation et de libération conditionnelle utilisent de plus en plus des algorithmes pour évaluer la probabilité qu'un accusé devienne un récidiviste - un terme utilisé pour décrire les criminels qui…

Depuis des années, la communauté de la justice pénale est inquiète. Les tribunaux de tout le pays attribuent des montants de caution condamnant les accusés sur la base d'algorithmes, et les avocats et les scientifiques des données avertisse…

Un après-midi de printemps 2014, Brisha Borden était en retard pour aller chercher sa marraine à l'école lorsqu'elle a repéré un vélo bleu Huffy pour enfant non verrouillé et un scooter argenté Razor. Borden et un ami ont attrapé le vélo et…

La discrimination cachée dans les scores d'évaluation des risques criminels

Les salles d'audience à travers le pays utilisent de plus en plus le «score d'évaluation des risques» d'un accusé pour aider à prendre des décisions concernant la c…

L'un de mes biens les plus précieux est The Art of Computer Programming de Donald Knuth, un informaticien pour qui le mot "légendaire" aurait pu être inventé. D'une certaine manière, on pourrait considérer son magnum opus comme une tentativ…

Imaginez que vous avez été reconnu coupable d'un crime et que vous attendiez de connaître votre peine. Préférez-vous que votre peine soit déterminée par un algorithme informatique, qui pondère sans passion les facteurs qui prédisent votre r…

Comme une version plus tordue du test Voight-Kampff de Blade Runner, un nouvel article d'apprentissage automatique d'une paire de chercheurs chinois s'est penché sur la tâche controversée de laisser un ordinateur décider de votre innocence.…

Prédire l'avenir n'est pas seulement l'affaire des diseurs de bonne aventure ou des experts des médias. Les algorithmes prédictifs, basés sur de vastes ensembles de données et de statistiques, ont dépassé les opérations de vente en gros et …

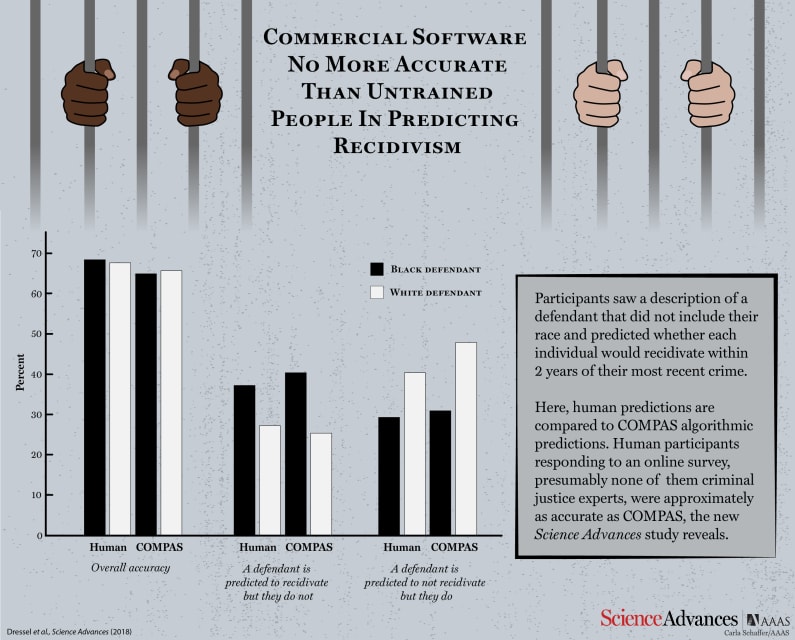

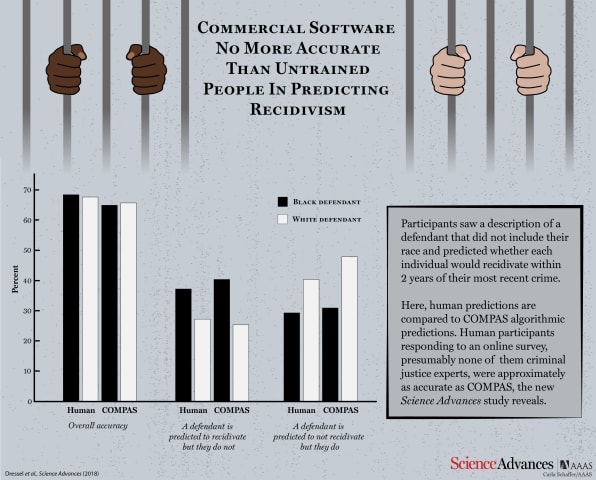

La prudence est en effet de mise, selon Julia Dressel et Hany Farid du Dartmouth College. Dans une nouvelle étude, ils ont montré que COMPAS n'est pas meilleur pour prédire le risque de récidive d'un individu que des volontaires aléatoires …

Ne blâmez pas l'algorithme - tant qu'il existe des disparités raciales dans le système judiciaire, les logiciels de détermination de la peine ne peuvent jamais être entièrement équitables.

Depuis des générations, les Massaïs d'Afrique de l'…

Bien que les taux de criminalité aient diminué régulièrement depuis les années 1990, les taux de récidive demeurent un facteur dans les domaines de la sécurité publique et de la gestion des détenus. L'Institut national de la justice définit…

Les algorithmes invisibles façonnent de plus en plus le monde dans lequel nous vivons, et pas toujours pour le mieux. Malheureusement, peu de mécanismes sont en place pour s'assurer qu'ils ne causent pas plus de mal que de bien.

Cela pourra…

Ouvrez l'application photo sur votre téléphone et recherchez "chien", et toutes les photos que vous avez de chiens apparaîtront. Ce n'était pas une mince affaire. Votre téléphone sait à quoi ressemble un chien.

Cette merveille des temps mod…

En tant qu'enfant, vous développez un sens de ce que signifie « équité ». C'est un concept que vous apprenez très tôt lorsque vous vous adaptez au monde qui vous entoure. Quelque chose semble juste ou non.

Mais de plus en plus, les algorith…

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Predictive Policing Biases of PredPol

AI Beauty Judge Did Not Like Dark Skin

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Predictive Policing Biases of PredPol