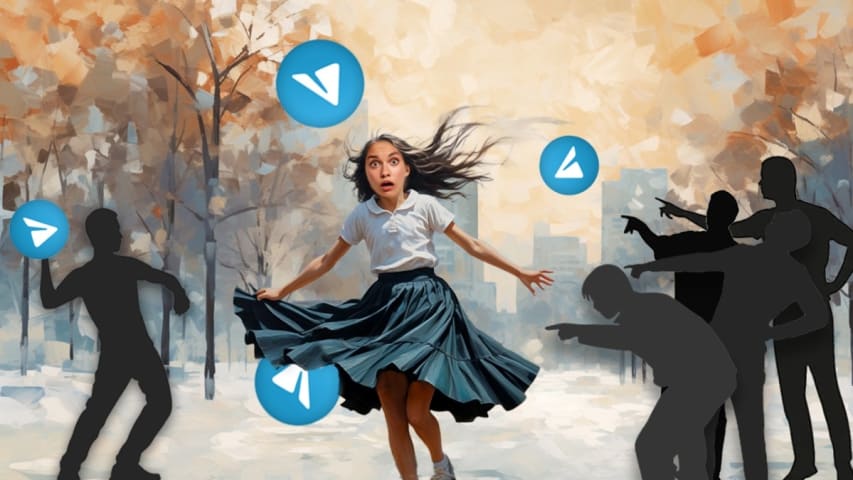

Incident 782: Les applications d'IA « Nudify » utilisées comme outils de chantage et d'extorsion

Description: Des applications d'IA « nudify » sont utilisées pour générer des photos de nus hyperréalistes et non consensuelles, exploitées à des fins d'extorsion et de harcèlement. Ces applications utilisent l'IA générative pour retirer les vêtements des images et créer des contrefaçons convaincantes, souvent diffusées sur des plateformes comme Telegram. Les victimes sont menacées ou humiliées par ces images générées par l'IA, avec peu de recours pour les faire supprimer ou intenter des poursuites judiciaires.

Entités

Voir toutes les entitésAlleged: Unknown deepfake creators developed an AI system deployed by Unknown deepfake creators et Extortionists, which harmed Women in India , Women et General public.

Statistiques d'incidents

Risk Subdomain

A further 23 subdomains create an accessible and understandable classification of hazards and harms associated with AI

4.3. Fraud, scams, and targeted manipulation

Risk Domain

The Domain Taxonomy of AI Risks classifies risks into seven AI risk domains: (1) Discrimination & toxicity, (2) Privacy & security, (3) Misinformation, (4) Malicious actors & misuse, (5) Human-computer interaction, (6) Socioeconomic & environmental harms, and (7) AI system safety, failures & limitations.

- Malicious Actors & Misuse

Entity

Which, if any, entity is presented as the main cause of the risk

Human

Timing

The stage in the AI lifecycle at which the risk is presented as occurring

Post-deployment

Intent

Whether the risk is presented as occurring as an expected or unexpected outcome from pursuing a goal

Intentional

Rapports d'incidents

Chronologie du rapport

Loading...

Plus que tout, le désespoir a poussé Rishabh à se tourner vers des applications qui promettaient des prêts rapides : de l’argent facile en quelques clics. Il était complètement fauché. Il était également sous le fardeau des prêts à taux d’i…

Variantes

Une "Variante" est un incident de l'IA similaire à un cas connu—il a les mêmes causes, les mêmes dommages et le même système intelligent. Plutôt que de l'énumérer séparément, nous l'incluons sous le premier incident signalé. Contrairement aux autres incidents, les variantes n'ont pas besoin d'avoir été signalées en dehors de la base de données des incidents. En savoir plus sur le document de recherche.

Vous avez vu quelque chose de similaire ?