Incident 40: L'algorithme COMPAS serait peu performant en matière de prédiction de la récidive criminelle.

Entités

Voir toutes les entitésClassifications de taxonomie CSETv0

Détails de la taxonomieProblem Nature

Unknown/unclear

Physical System

Software only

Level of Autonomy

Medium

Nature of End User

Amateur

Public Sector Deployment

Yes

Data Inputs

Questionnaire consisting of 137 factors like age, prior convictions, criminal records

Classifications de taxonomie CSETv1

Détails de la taxonomieIncident Number

40

AI Tangible Harm Level Notes

CSET considers wrongful detention, wrongful imprisonment, and wrongful differential/disproportionate imprisonment amounts to be tangible harm, because of the loss of physical freedom and autonomy.

Risk Subdomain

1.1. Unfair discrimination and misrepresentation

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Rapports d'incidents

Chronologie du rapport

← Lire l'histoire

Partout au pays, les juges, les agents de probation et de libération conditionnelle utilisent de plus en plus des algorithmes pour évaluer la probabilité qu'un accusé devienne un récidiviste - un terme utilisé pour décrire…

C'était une histoire saisissante. «Machine Bias», disait le titre, et le teaser proclamait: «Il existe des logiciels utilisés dans tout le pays pour prédire les futurs criminels. Et il est biaisé contre les Noirs.

ProPublica, une organisati…

Le système de justice pénale s'automatise. À chaque étape - du maintien de l'ordre et des enquêtes à la mise en liberté sous caution, en passant par les preuves, la condamnation et la libération conditionnelle - les systèmes informatiques j…

Prédire l'avenir n'est pas seulement l'affaire des diseurs de bonne aventure ou des experts des médias. Les algorithmes prédictifs, basés sur de vastes ensembles de données et de statistiques, ont dépassé les opérations de vente en gros et …

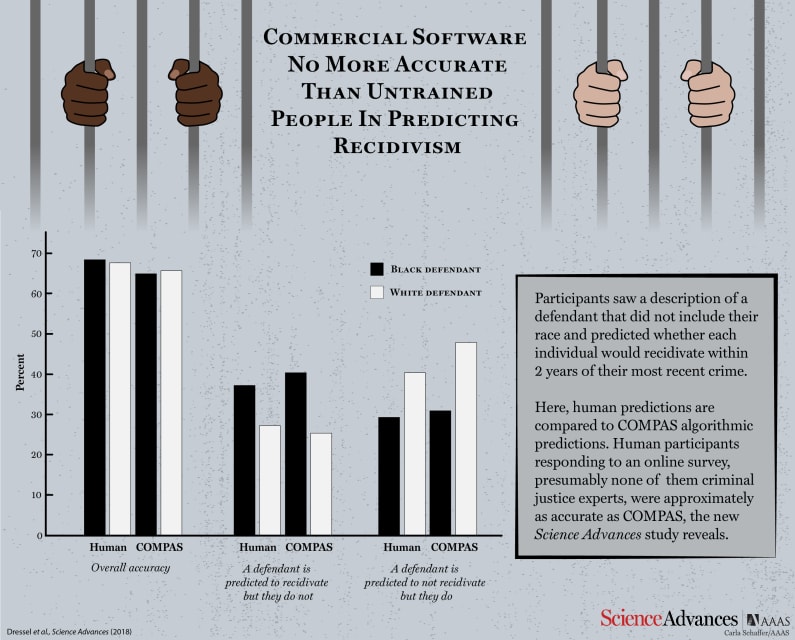

Nos algorithmes de prédiction de la criminalité les plus sophistiqués ne sont peut-être pas aussi bons que nous le pensions. Une étude publiée aujourd'hui dans Science Advances examine l'algorithme COMPAS populaire - utilisé pour évaluer la…

La prudence est en effet de mise, selon Julia Dressel et Hany Farid du Dartmouth College. Dans une nouvelle étude, ils ont montré que COMPAS n'est pas meilleur pour prédire le risque de récidive d'un individu que des volontaires aléatoires …

EN AMÉRIQUE, les ordinateurs sont utilisés depuis de nombreuses années pour faciliter les décisions de mise en liberté sous caution et de condamnation. Leurs partisans soutiennent que la logique rigoureuse d'un algorithme, formé avec une gr…

Les algorithmes de prédiction de la récidive sont couramment utilisés pour évaluer la probabilité qu'un accusé criminel commette un crime. Ces prédictions sont utilisées dans les décisions de mise en état, de libération conditionnelle et de…

Selon des experts, le programme utilisé pour évaluer plus d'un million d'accusés aux États-Unis n'est peut-être pas suffisamment précis pour prendre des décisions susceptibles de changer leur vie

La crédibilité d'un programme informatique u…

Les algorithmes qui évaluent la probabilité de récidive dans le cadre du processus de mise en liberté sous caution dans les affaires pénales sont, pour être franc, vraiment effrayants.

Nous ne savons pas grand-chose sur leur fonctionnement …

Selon une étude du Dartmouth College, un outil logiciel informatique largement utilisé n'est peut-être pas plus précis ou juste pour prédire le comportement criminel à répétition que les personnes sans expérience de la justice pénale.

L'ana…

Tout comme un chef professionnel ou un chirurgien cardiaque, un algorithme d'apprentissage automatique est aussi bon que la formation qu'il reçoit. Et comme les algorithmes prennent de plus en plus les rênes et prennent des décisions pour l…

Prédire la récidive

La récidive est la probabilité qu'une personne reconnue coupable d'un crime récidive. Actuellement, ce taux est déterminé par des algorithmes prédictifs. Le résultat peut affecter tout, des décisions de détermination de …

Dans une étude publiée mercredi, deux chercheurs de Dartmouth ont découvert qu'un algorithme populaire d'évaluation des risques n'était pas meilleur pour prédire la probabilité de récidive d'un délinquant criminel qu'une enquête sur Interne…

Recevez des e-mails sur les programmes NOVA à venir et le contenu connexe, ainsi que des reportages sur les événements actuels à travers une lentille scientifique. Adresse e-mail Code postal S'inscrire

Selon une étude récente, un algorithme…

Bien que les taux de criminalité aient diminué régulièrement depuis les années 1990, les taux de récidive demeurent un facteur dans les domaines de la sécurité publique et de la gestion des détenus. L'Institut national de la justice définit…

(Photo : Joe Raedle/Getty Images)

Des dizaines de personnes se sont rassemblées dans une salle d'audience de Philadelphie le 6 juin pour exprimer leurs objections à un algorithme de justice pénale proposé. L'algorithme, développé par la Pen…

Lorsque Netflix se trompe sur une recommandation de film, vous pensez probablement que ce n'est pas grave. De même, lorsque vos baskets préférées ne figurent pas dans la liste des produits recommandés d'Amazon, ce n'est probablement pas la …

Dans une étude de COMPAS, un outil algorithmique utilisé dans le système de justice pénale américain, les chercheurs du Dartmouth College, Julia Dressel et Hany Farid, ont découvert que l'algorithme ne faisait pas mieux que les volontaires …

DÉCLARATION PRÉLIMINAIRE ET DÉCLARATION D'INTÉRÊT Un examen indépendant et contradictoire des logiciels utilisés dans le système de justice pénale est nécessaire pour protéger les tribunaux contre les preuves non fiables et pour s'assurer q…

L'évaluation du risque de récidive est le processus de détermination de la probabilité qu'une personne accusée, condamnée ou incarcérée récidive. Le processus vise à aider à déterminer la limitation appropriée de la liberté du sujet. Grâce …

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Northpointe Risk Models

Predictive Policing Biases of PredPol

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Northpointe Risk Models