Incident 163: Les algorithmes de détection des discours haineux de Facebook auraient échoué de manière disproportionnée à supprimer les contenus racistes envers les groupes minoritaires

Description: Les chercheurs de l’entreprise ont découvert que les algorithmes de détection des discours haineux de Facebook sous-estimaient les contenus moins courants mais plus nuisibles, plus souvent rencontrés par les groupes minoritaires tels que les utilisateurs noirs, musulmans, LGBTQ et juifs.

Entités

Voir toutes les entitésPrésumé : Un système d'IA développé et mis en œuvre par Facebook, a endommagé Facebook users of minority groups et Facebook users.

Risk Subdomain

A further 23 subdomains create an accessible and understandable classification of hazards and harms associated with AI

1.2. Exposure to toxic content

Risk Domain

The Domain Taxonomy of AI Risks classifies risks into seven AI risk domains: (1) Discrimination & toxicity, (2) Privacy & security, (3) Misinformation, (4) Malicious actors & misuse, (5) Human-computer interaction, (6) Socioeconomic & environmental harms, and (7) AI system safety, failures & limitations.

- Discrimination and Toxicity

Entity

Which, if any, entity is presented as the main cause of the risk

Human

Timing

The stage in the AI lifecycle at which the risk is presented as occurring

Post-deployment

Intent

Whether the risk is presented as occurring as an expected or unexpected outcome from pursuing a goal

Intentional

Rapports d'incidents

Chronologie du rapport

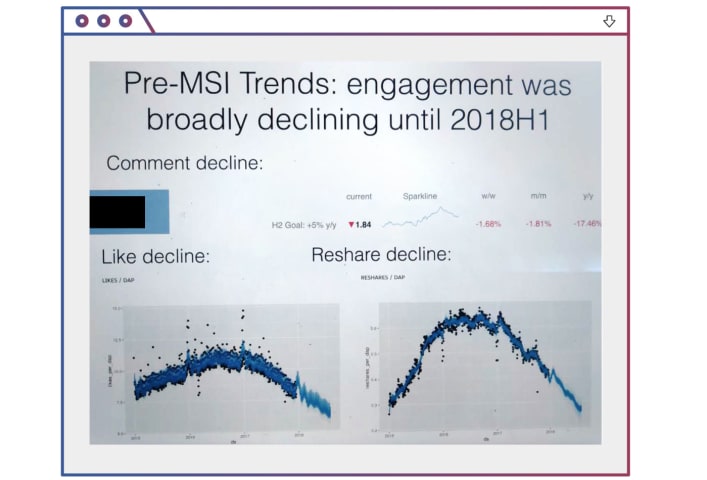

En public, Facebook semble affirmer qu'il supprime plus de 90% des discours de haine sur sa plate-forme, mais dans les communications internes privées, l'entreprise affirme que le chiffre n'est que de 3 à 5%. Facebook veut nous faire croire…

L'année dernière, des chercheurs de Facebook ont montré aux dirigeants un exemple du type de discours de haine circulant sur le réseau social : un message réel présentant une image de quatre législatrices démocrates connues collectivement s…

Variantes

Une "Variante" est un incident de l'IA similaire à un cas connu—il a les mêmes causes, les mêmes dommages et le même système intelligent. Plutôt que de l'énumérer séparément, nous l'incluons sous le premier incident signalé. Contrairement aux autres incidents, les variantes n'ont pas besoin d'avoir été signalées en dehors de la base de données des incidents. En savoir plus sur le document de recherche.

Vous avez vu quelque chose de similaire ?

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Incidents similaires

Did our AI mess up? Flag the unrelated incidents