Incident 1281: Des effets néfastes présumés sur la santé ont été signalés suite à l'utilisation de conseils médicaux prétendument générés par ChatGPT à Hyderabad.

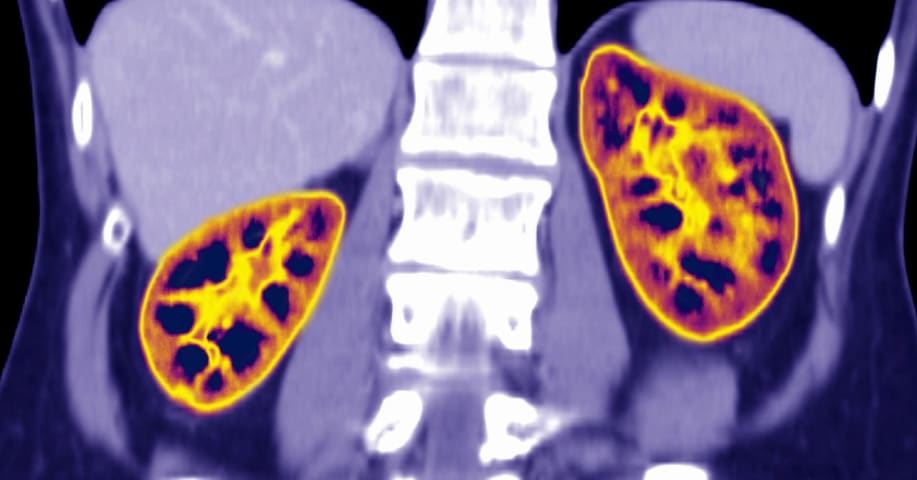

Description: Des rapports en provenance d'Hyderabad font état de deux cas présumés de préjudices subis par des patients après avoir suivi des conseils médicaux prétendument générés par ChatGPT au lieu de l'avis d'un médecin. Un patient ayant bénéficié d'une transplantation rénale aurait interrompu son traitement post-transplantation suite à une suggestion d'un chatbot et aurait subi un rejet de greffe. Dans un autre cas, un homme diabétique aurait développé une hyponatrémie sévère après avoir suivi un régime sans sel conseillé par un chatbot.

Editor Notes: The reporting on this incident seems to draw on three discrete harm events to point to a wider concern in Hyderabad. The case involving an unnamed kidney transplant patient and an elderly man with diabetes are Hyderabad-specific, whereas the third case that seems to appear in the reporting is a reference to a New York case, Incident 1166: ChatGPT Reportedly Suggests Sodium Bromide as Chloride Substitute, Leading to Bromism and Hospitalization.

Entités

Voir toutes les entitésPrésumé : Un système d'IA développé et mis en œuvre par OpenAI et ChatGPT, a endommagé Unnamed patient with diabetes in Hyderabad , Unnamed kidney transplant patient in Hyderabad , OpenAI users , General public of India , General public of Hyderabad , General public et ChatGPT users.

Système d'IA présumé impliqué: ChatGPT

Statistiques d'incidents

ID

1281

Nombre de rapports

2

Date de l'incident

2025-11-10

Editeurs

Daniel Atherton

Rapports d'incidents

Chronologie du rapport

Loading...

Les médecins exhortent les patients à ne plus utiliser les chatbots d'IA comme substitut aux soins médicaux.

À Hyderabad, les cliniciens constatent une forte augmentation du nombre de patients qui suivent les conseils génériques de chatbot…

Loading...

Hyderabad : À Hyderabad, des médecins mettent en garde la population contre le recours exclusif aux outils d'intelligence artificielle (IA) tels que ChatGPT pour obtenir des conseils médicaux. Ils insistent sur le fait que les patients, en …

Variantes

Une "Variante" est un incident de l'IA similaire à un cas connu—il a les mêmes causes, les mêmes dommages et le même système intelligent. Plutôt que de l'énumérer séparément, nous l'incluons sous le premier incident signalé. Contrairement aux autres incidents, les variantes n'ont pas besoin d'avoir été signalées en dehors de la base de données des incidents. En savoir plus sur le document de recherche.

Vous avez vu quelque chose de similaire ?