Incident 1174: Microsoft Copilot serait capable d'accéder aux données mises en cache à partir de référentiels GitHub privés.

Outils

Entités

Voir toutes les entitésStatistiques d'incidents

Risk Subdomain

2.1. Compromise of privacy by obtaining, leaking or correctly inferring sensitive information

Risk Domain

- Privacy & Security

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Rapports d'incidents

Chronologie du rapport

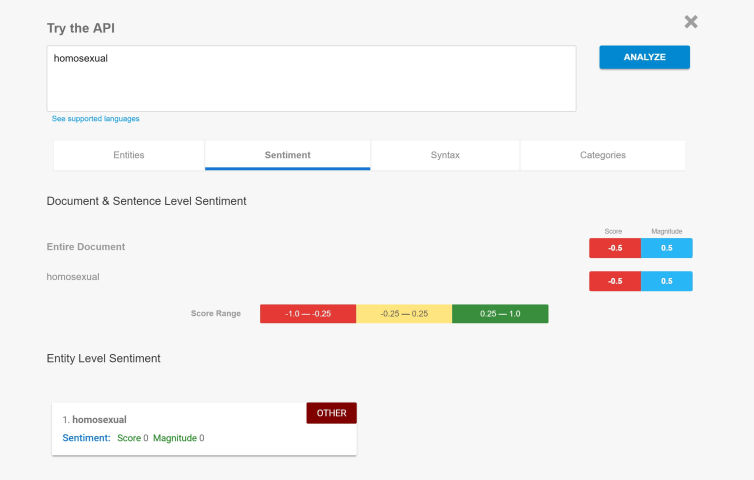

Des chercheurs en sécurité avertissent que les données exposées sur Internet, même brièvement, peuvent persister dans des chatbots d'IA générative en ligne comme Microsoft Copilot longtemps après leur privatisation.

Des milliers de dépôts G…

En août 2024, nous avons découvert une publication LinkedIn [https://www.linkedin.com/posts/zak-horton_github-ai-privacy-activity-7225764812117487616-YcGP] affirmant qu'OpenAI s'entraînait sur des données provenant de dépôts GitHub privés e…

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Incidents similaires

Did our AI mess up? Flag the unrelated incidents