Incidente 103: La herramienta de recorte de imágenes de Twitter supuestamente mostraba sesgo de género y racial

Entidades

Ver todas las entidadesClasificaciones de la Taxonomía CSETv1

Detalles de la TaxonomíaIncident Number

103

Special Interest Intangible Harm

yes

Notes (AI special interest intangible harm)

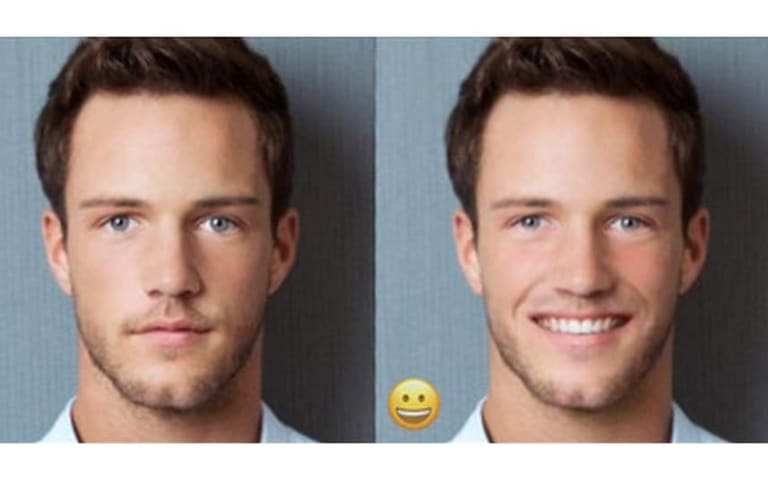

The cropping neutral network would crop the preview image in way that focused more on individuals with lighter completions, younger, female, or without disabilities.

Date of Incident Year

2020

Clasificaciones de la Taxonomía GMF

Detalles de la TaxonomíaKnown AI Goal Snippets

(Snippet Text: Twitter‘s algorithm for automatically cropping images attached to tweets often doesn’t focus on the important content in them. , Related Classifications: Image Cropping)

Risk Subdomain

1.1. Unfair discrimination and misrepresentation

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Informes del Incidente

Cronología de Informes

El algoritmo de Twitter para recortar automáticamente las imágenes adjuntas a los tweets a menudo no se enfoca en el contenido importante de ellos. Una molestia, seguro, pero parece menor en la superficie. Sin embargo, durante el fin de sem…

Un estudio de 10,000 imágenes encontró sesgo en lo que el sistema elige resaltar. Twitter ha dejado de usarlo en dispositivos móviles y considerará deshacerse de él en la web.

EL OTOÑO PASADO, el estudiante canadiense Colin Madland notó que…

En octubre de 2020, escuchamos comentarios de personas en Twitter sobre nuestro [algoritmo de recorte de imágenes](https: //blog.twitter.com/engineering/en_us/topics/infrastructure/2018/Smart-Auto-Cropping-of-Images.html) no sirvió a todas …

Twitter ha presentado planes para una competencia de recompensas por errores con una diferencia. Esta vez, en lugar de pagar a los investigadores que descubren problemas de seguridad, Twitter recompensará a aquellos que encuentren ejemplos …

El primer [programa de recompensas por sesgo de IA] de Twitter (https://www.engadget.com/twitter-bug-bounty-contest-algorithm-bias-image-cropping-185634779.html) ha concluido, y ya hay algunos problemas que la empresa quiere abordar. CNET i…

Variantes

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents