インシデント 880: オーストラリアで、健康専門家や著名人のディープフェイクを使って健康サプリメントを販売したり、有害なアドバイスをしたりしている詐欺師がいると報じられている。

概要: オーストラリアでは、AIが生成した健康専門家や著名人のディープフェイク動画を詐欺師が利用し、健康サプリメントの販売や有害な健康アドバイスを行っているとの報告があります。報告されている事例の中には、ジョナサン・ショーとカール・ステファノヴィッチが糖尿病管理薬「グリコバランス」を推奨しているように見せかけたディープフェイク動画や、カール・クルシェルニツキが血圧降下剤を宣伝しているように見せかけた動画などが挙げられています。

Editor Notes: See also Incident 1076 for a variant of this incident ID, along with more information. Incidents 880 and Incident 1076 are closely related. Reconstructing the timeline of events for this ID: (1) November 2023: A fabricated interview transcript, allegedly attributed to Prof. Jonathan Shaw, is published online. The transcript reportedly claims he endorsed "Glyco Balance" as a breakthrough treatment for type 2 diabetes, and (2) AI-generated videos allegedly featuring Shaw and television host Karl Stefanovic appear on Facebook, promoting "Glyco Balance" with claims that reportedly misrepresent the effectiveness of the supplement and criticize established medications like metformin. (3) Earlier in 2024: Similar AI technology is reportedly used to create deepfake videos of Dr. Karl Kruszelnicki endorsing unproven blood pressure medications. These ads are widely circulated on Facebook and Instagram. (4) November 29, 2024: Meta removes the deepfake video of Shaw following a complaint from the Baker Institute. The removal reportedly required the filing of an intellectual property infringement claim. (5) December 9, 2024: The Australian Broadcasting Corporation publishes a report detailing these incidents.

Alleged: Unknown deepfake technology developers developed an AI system deployed by Unknown scammers, which harmed Karl Stefanovic , Karl Kruszelnicki , Jonathan Shaw , General public と Diabetes patients.

関与が疑われるAIシステム: Unknown deepfake app

インシデントのステータス

Risk Subdomain

A further 23 subdomains create an accessible and understandable classification of hazards and harms associated with AI

4.3. Fraud, scams, and targeted manipulation

Risk Domain

The Domain Taxonomy of AI Risks classifies risks into seven AI risk domains: (1) Discrimination & toxicity, (2) Privacy & security, (3) Misinformation, (4) Malicious actors & misuse, (5) Human-computer interaction, (6) Socioeconomic & environmental harms, and (7) AI system safety, failures & limitations.

- Malicious Actors & Misuse

Entity

Which, if any, entity is presented as the main cause of the risk

Human

Timing

The stage in the AI lifecycle at which the risk is presented as occurring

Post-deployment

Intent

Whether the risk is presented as occurring as an expected or unexpected outcome from pursuing a goal

Intentional

インシデントレポート

レポートタイムライン

Loading...

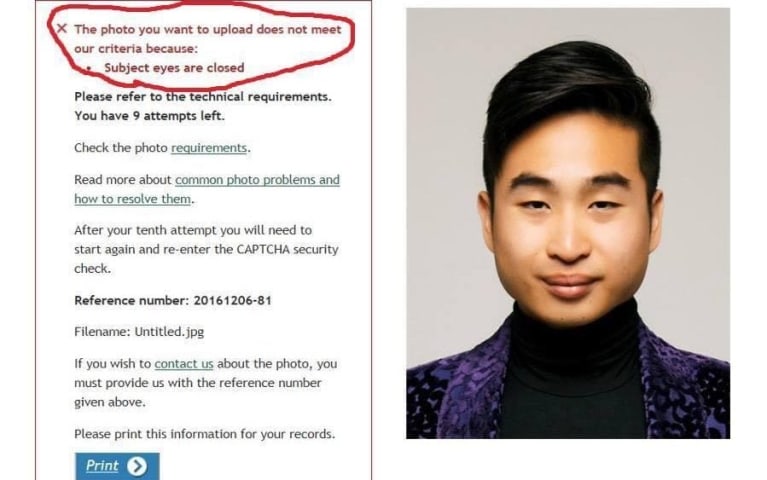

糖尿病の著名な専門家は、薬を処方する人々を「バカ」と評するAI生成の動画を患者が見た後、患者に正しい薬を飲んでいると安心させざるを得なくなった。

メルボルンのベイカー心臓・糖尿病研究所の副所長ジョナサン・ショー氏は、フェイスブックで宣伝している新しい治療法について患者がクリニックに電話をかけてきて情報を求め始めたときに、この動画の存在を知った。

「リンクをクリックすると、もちろん私そっくりだったが、言葉がすべて変えられていた」とショー教授は語った。

「私が言うことを信じてしま…

バリアント

「バリアント」は既存のAIインシデントと同じ原因要��素を共有し、同様な被害を引き起こし、同じ知的システムを含んだインシデントです。バリアントは完全に独立したインシデントとしてインデックスするのではなく、データベースに最初に投稿された同様なインシデントの元にインシデントのバリエーションとして一覧します。インシデントデータベースの他の投稿タイプとは違い、バリアントではインシデントデータベース以外の根拠のレポートは要求されません。詳細についてはこの研究論文を参照してください

似たようなものを見つけましたか?