インシデントのステータス

Risk Subdomain

7.3. Lack of capability or robustness

Risk Domain

- AI system safety, failures, and limitations

Entity

AI

Timing

Post-deployment

Intent

Intentional

インシデントレポート

レポートタイムライン

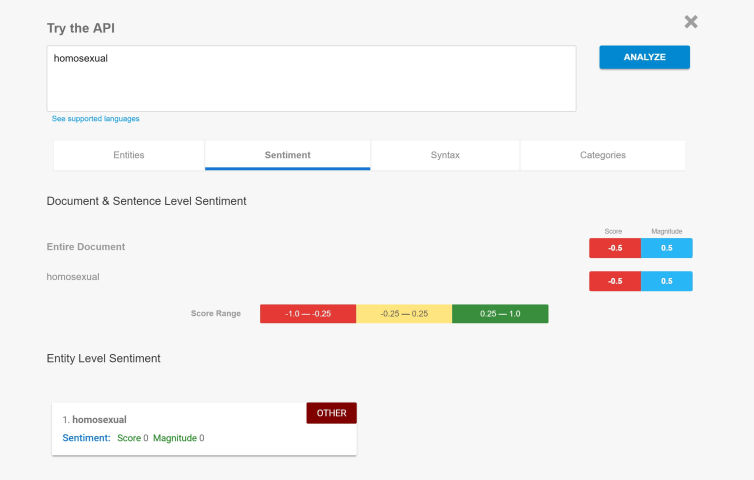

OpenAI の ChatGPT は、単なる派手なインターフェースを備えた AI 言語モデルではありません。これは、AI モデルとコンテンツ フィルターのスタックで構成されたシステムであり、その出力によって OpenAI が恥ずかしい思いをしたり、ボットが人に関する 潜在的に有害な事実をでっち上げ 場合に同社が法的トラブルに巻き込まれたりしないようにします。

最近、この事実がニュースになりました。人々が発見した「David Mayer」という名前がChatGPTを破綻させると…

イギリスのマンチェスターに住む演劇教授のデイビッド・メイヤー氏は、人生の最後の�数年間、不幸な偶然の連鎖的な結果に直面した。テロ監視リストに載っていたチェチェンの反乱軍の死者が、かつてメイヤー氏の名前を偽名として使っていたのだ。

家族によると、本物のメイヤー氏は旅行計画を妨害され、金融取引は凍結され、重要な学術通信はブロックされた。そのフラストレーションは、2023年に94歳で亡くなるまで彼を悩ませた。

しかし今月、彼のアイデンティティーを守る闘いが再び注目を集めた。鋭い目を持…

デビッド・メイヤーは先週まで特に有名な名前ではなかったが、インターネットで注目を浴びるようになった。その理由はデビッド・メイヤーという人物の発言や行動ではなく、生成AIチャットボットChatGPTがその名前の言及を扱った方法にあった。

ChatGPTに「デビッド・メイヤーって誰?」と尋ねたユーザーは、チャットボットが質問に答えている途中で応答を放棄し、それまでに入力されたテキストをすべて削除して「応答できません」というエラーメッセージを表示したことに驚いた。

この謎のニュース…

/cloudfront-us-east-2.images.arcpublishing.com/reuters/56IRXWYJKRIUXF4PYIBCBMSIUY.jpg)