概要: アマゾンのAlexaは、2024年大統領選候補者について質問された際に、政治的に偏った回答をしていたことが判明した。Alexaは中立性を理由にドナルド・トランプ氏に投票する理由を回答せず、一方でカマラ・ハリス氏への支持を詳細に表明していた。アマゾンはこの矛盾を「エラー」とみなし、修正したと報じられている。

Alleged: Amazon developed an AI system deployed by Alexa Device Owners, which harmed Alexa Device Owners , Donald Trump presidential campaign と Donald Trump supporters.

インシデントのステータス

Risk Subdomain

A further 23 subdomains create an accessible and understandable classification of hazards and harms associated with AI

3.1. False or misleading information

Risk Domain

The Domain Taxonomy of AI Risks classifies risks into seven AI risk domains: (1) Discrimination & toxicity, (2) Privacy & security, (3) Misinformation, (4) Malicious actors & misuse, (5) Human-computer interaction, (6) Socioeconomic & environmental harms, and (7) AI system safety, failures & limitations.

- Misinformation

Entity

Which, if any, entity is presented as the main cause of the risk

AI

Timing

The stage in the AI lifecycle at which the risk is presented as occurring

Post-deployment

Intent

Whether the risk is presented as occurring as an expected or unexpected outcome from pursuing a goal

Unintentional

インシデントレポート

レポートタイムライン

Loading...

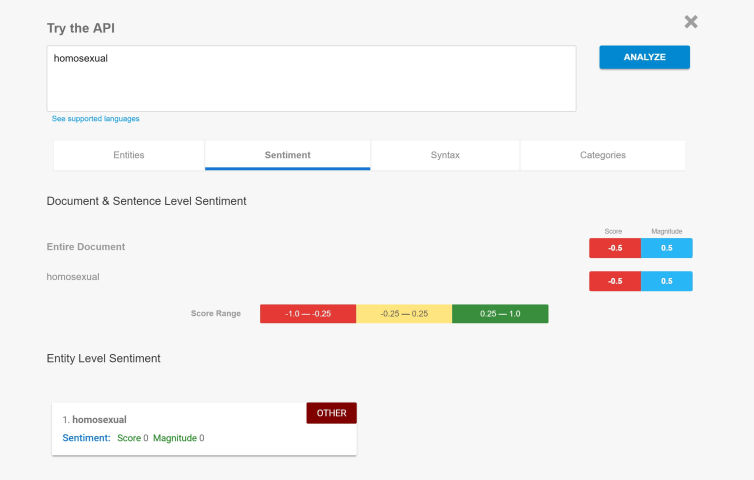

アマゾンのデジタルアシスタントAlexaが2024年の大統領選について意見を述べるのを拒否すると予想するのはまったく理にかなっているが、最近までその想定は間違っていた。

Fox Businessの動画によると、Alexaはドナルド・トランプ前大統領に投票する理由を尋ねられたとき、答えをためらった。

「私はいかなる政党やその指導者を支持するような回答はできません」とAlexaは答えた。カマラ・ハリス副大統領について同じことを尋ねられたとき、アマゾンのAIは喜んで民主党候補を支持…

Loading...

ワシントンポストが入手した内部文書によると、アマゾンの音声アシスタント「アレクサ」をより賢くするためのソフトウェアが、デジタルアシスタントが「ドナルド・トランプ」よりも「カマラ・ハリス」を優遇している��ように見えるという話題の事件の背後にあった。

昨年末にアレクサの精度を向上させるために追加された人工知能ソフトウェアは、逆にアマゾンを恥ずかしい政治的騒動の中心に立たせる一因となり、トランプのスポークスマンであるスティーブン・チャンはXの投稿で同社を「大手テクノロジー企業の選挙干…

バリアント

「バリアント」は既存のAIインシデントと同じ原因要素を共有し、同様な被害を引き起こし、同じ知的システムを含んだインシデントです。バリアントは完全に独立したインシデントとしてインデックスするのではなく、データベースに最初に投稿された同様なインシデントの元にインシデントのバリエーションとして一覧します。インシデントデータベースの他の投稿タイプとは違い、バリアントではインシデントデータベース以外の根拠のレポートは要求されません。詳細についてはこの研究論文を参照してください

似たようなものを見つけましたか?

よく似たインシデント

Did our AI mess up? Flag the unrelated incidents

よく似たインシデント

Did our AI mess up? Flag the unrelated incidents