Incidents associés

Ce n'est pas la première fois que l'intelligence artificielle est à l'honneur pour un racisme apparent, mais les récents résultats des concours de Beauty.AI ont suscité la controverse en favorisant clairement les peaux claires.

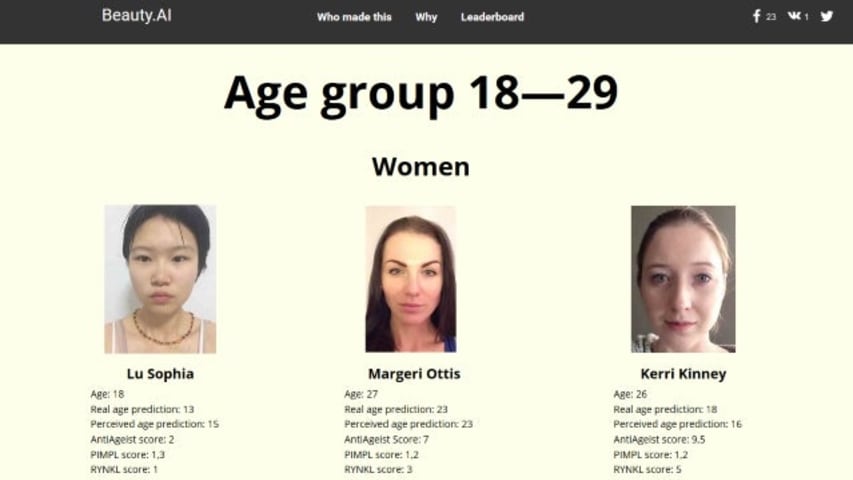

Le concours, qui s'est déroulé en ligne et était ouvert aux hommes et aux femmes du monde entier de tous âges, s'est terminé avec des gagnants presque entièrement à la peau blanche, ce qui a conduit aux cris de racisme des robots.

Cependant, étant donné que l'IA n'est aussi intelligente que les ensembles de données sur lesquels elle est formée, cela pourrait exagérer. Les robots n'ont aucun moyen d'être intrinsèquement racistes. Un titre alternatif pourrait être "Une méthodologie de recherche ratée conduit à des résultats biaisés", mais ce n'est pas une lecture aussi convaincante.

En effet, Alex Zhavoronkov, directeur scientifique de Beauty.AI, a déclaré que les résultats étaient un manque de minorités ethniques dans l'ensemble de données de formation. Cela signifiait que même si la peau claire n'était pas définie comme faisant partie de la beauté, l'IA a quand même attiré l'association.

Cet oubli, ou cette lacune, de la recherche signifiait que malgré l'objectif général du concours d'éliminer les préjugés humains en jugeant sur des critères spécifiques, il se glissait toujours de toute façon.

Plus tôt dans l'année, un chatbot AI Twitter créé par Microsoft appelé Tay a dû être mis hors ligne après seulement 24 heures après avoir appris à devenir un raciste obsédé par le sexe.

De toute évidence, nous devons trouver un moyen de former l'IA de manière plus robuste.

En relation: Microsoft s'excuse pour les tirades néonazies et folles de sexe du chatbot AI Twitter

Regardez: iPhone 7 contre Galaxy S7

Pensez-vous que les robots peuvent être racistes, ou pensez-vous que ce sont toujours de mauvaises données fournies par les humains ? Faites-le nous savoir dans les commentaires ci-dessous.