Incidents associés

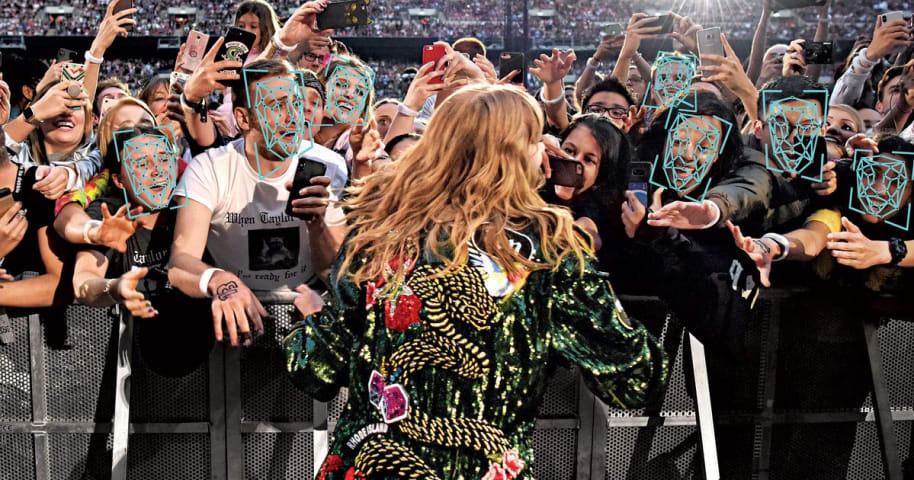

Le vendredi 16 août vers 7h00, une paire d'[appareils suspects](https://www.nytimes.com/2019/08/16/nyregion/fulton-street-subway-pressure-cooker .html) a été retrouvé sur un quai de métro à la station Fulton Street dans le bas de Manhattan et, une heure plus tard, un troisième près d'une poubelle sur West 16th Street. Au départ, la police pensait qu'il pourrait s'agir de bombes improvisées, comme les autocuiseurs remplis d'éclats d'obus qui ont explosé au marathon de Boston en 2013 et à Chelsea en 2016, mais après inspection, ils se sont avérés être des cuiseurs à riz vides inoffensifs, probablement destinés à effrayer mais pas exploser. Les trains ont été retardés pendant le trajet du matin, mais comme cela se produit assez souvent sans aucune aide terroriste, la chose la plus effrayante à propos de cet épisode a peut-être été la façon dont l'auteur présumé a été arrêté. Quelques minutes après la découverte, le NYPD a extrait des images d'un homme quittant les appareils des caméras de surveillance du métro et les a transmises à sa section d'identification faciale (FIS), qui [les a exécutées via un logiciel] (https://nypost.com/2019/08 /25/how-nypds-facial-recognition-software-ided-subway-rice-cooker-kook/) qui a automatiquement comparé son visage à des millions de photos d'identité dans la base de données du service de police. Le programme a recraché des centaines de correspondances potentielles au cours desquelles les agents ont rapidement repéré la personne qui les intéressait : Larry Griffin II, un sans-abri de 26 ans que le NYPD avait arrêté en mars avec un attirail de drogue. Le FIS a revérifié ses photos de surveillance par rapport aux comptes de médias sociaux de Griffin, et à 8 h 15, son nom et ses photos ont été envoyés sur les téléphones portables de tous les flics de New York. Il a été arrêté dans le Bronx tard dans la nuit et accusé de trois chefs d'avoir posé une fausse bombe. (Il a plaidé non coupable.) Cela peut sembler être une histoire de bien-être : une personne potentiellement dangereuse a été identifiée et appréhendée avec une rapidité auparavant impossible et sans faire de victimes grâce à l'utilisation conforme aux règles de l'art de la nouvelle technologie (ou plus récente ; le NYPD a utilise un logiciel de reconnaissance faciale depuis 2011). Mais dézoomez un peu et cela ressemble plus à une doublure argentée sur l'une des plus grandes histoires de malaise de cette année : le système de reconnaissance faciale qui a piégé Griffin n'est qu'un petit morceau d'un appareil de surveillance tentaculaire, invisible et détruisant la vie privée qui maintenant nous entoure tous, construit sous notre nez (et en utilisant notre nez) par des entreprises technologiques, des forces de l'ordre, des intérêts commerciaux et un éventail secret de courtiers en données et d'autres tiers. En 2019, la reconnaissance faciale est peut-être finalement sortie de l'opprimé dystopique - ce n'était que la quatrième ou la cinquième chose la plus effrayante dans Minority Report ; il n'a jamais joué plus qu'un rôle de soutien sur Black Mirror ; et dans les films Terminator, il s'agissait d'une fonction de sécurité cruciale empêchant le Terminator de mettre fin aux mauvaises personnes - à l'inquiétude moderne à part entière. Un bref récapitulatif de l'année de Face Panic : ce printemps, nous avons appris que la base de données de reconnaissance faciale du FBI comprend désormais plus de 641 millions d'images et l'identité d'une majorité sans méfiance Américains, qui peuvent être fouillés à tout moment sans mandat ni motif probable. Nous avons également appris que des législateurs effrayés avaient interdit à la police d'utiliser la reconnaissance faciale à Oakland ; Berkeley; Somerville, Massachusetts; et San Francisco, de tous les endroits où les produits technologiques orwelliens sont l'industrie locale. Mais partout ailleurs et dans tous les autres contextes, la reconnaissance faciale est légale et presque totalement non réglementée - et nous avons entendu dire qu'elle était déjà utilisée sur nous dans [les rues de la ville] (https://www.wired.com/story/some-us- villes-moving-real-time-facial-surveillance/), aéroports, magasins de détail, [restaurants](https://thetakeout.com/restaurants- are-using-facial-recognition-software-to-re-1827237920), hôtels, [événements sportifs] (https://www.espn.com/chalk/story/_/id/24884024/why-use-facial-recognition-cameras-sporting-events-the-rise), [églises](https://www. washingtonpost.com/), et probablement beaucoup d'autres endroits que nous ne connaissons tout simplement pas. Au cours de l'été, nous avons entendu une rumeur concernant une nouvelle application photo qui pourrait être un [stratégie secret du gouvernement russe](https://www.theverge.com/2019/7/17/20698393/faceapp-aging-russia- security-privacy-concerns-dnc-democrats-warning-campaign-election) pour récolter nos selfies pour sa propre base de données de reconnaissance faciale. Cela s'est avéré être faux (ou du moins nous le pensons), mais cela nous a peut-être fait reconsidérez toutes les photos que nous avons données à d'autres entreprises dont les conditions d'utilisation remplies d'échappatoires se traduisent par "nous possédons votre visage" - y compris Facebook, qui est censé avoir [l'une des plus grandes bases de données de reconnaissance faciale au monde](https:/ /slate.com/technology/2019/07/facebook-facial-recognition-ice-bad.html) et ne s'est pas avéré être le gardien le plus responsable de nos [informations privées](https://slate.com/ technologie/2019/04/facebook-data-breach-540-million-users-privacy.html). Nous avons à peine entendu parler du Commercial Facial Recognition Privacy Act of 2019, un projet de loi présenté en mars par le sénateur républicain Roy Blunt et le démocrate Brian Schatz qui aurait interdit aux entreprises d'utiliser la reconnaissance faciale pour vous suivre en public, et de collecter ou de vendre vos données faciales, sans votre consentement. C'était le genre de proposition bipartite de bon sens avec laquelle presque tout le monde peut être d'accord; il a été renvoyé à un comité et n'a jamais fait l'objet d'un vote. Mais nous avons beaucoup entendu parler du manque de fiabilité de la reconnaissance faciale et du fait que les erreurs d'identification sont courantes, en particulier pour les [personnes de couleur] (http://www.apple.com/), et que le système de la police métropolitaine de Londres a un [taux d'échec épouvantable] (https://www.wired.co.uk/article/met-police-london-facial-recognition-test), et que le logiciel d'Amazon a déjà confondu un groupe de membres du Congrès apparemment honnêtes avec [criminal suspects](https:// www.aclu.org/blog/privacy-technology/surveillance-technologies/amazons-face-recognition-falsely-matched-28). Peut-être que cela signifiait, espérions-nous, que la technologie n'était encore qu'à moitié cuite et que nos inquiétudes étaient prématurées, et qu'un gros procès pourrait tout faire disparaître. Et puis nous avons entendu parler de Larry Griffin II. Et si son histoire était censée calmer les craintes sur la reconnaissance faciale, eh bien, mission pas forcément accomplie. Si le logiciel fonctionne assez bien pour identifier un suspect de canular parmi 8,4 millions de New-Yorkais en moins d'une heure en utilisant seulement quelques photos de surveillance granuleuses, peut-être que nos inquiétudes ne sont pas si prématurées après tout. Parce que même si la reconnaissance faciale n'est pas encore totalement fiable, et qu'elle ne le sera peut-être jamais, elle transforme déjà les forces de l'ordre. Et il n'aura probablement pas besoin d'être parfait pour transformer également notre vie quotidienne. Dans une histoire peut-être connexe, peut-être avez-vous remarqué une demande inhabituellement élevée de photos de votre visage au cours des dernières années ? La reconnaissance faciale informatisée est en développement depuis les années 1960. Les progrès ont été réguliers mais lents, cependant, jusqu'à l'arrivée récente des [réseaux de neurones artificiels avancés](https://medium.com/@ageitgey/machine-learning-is-fun-part-4-modern-face-recognition-with -deep-learning-c3cffc121d78) - c'est-à-dire des systèmes informatiques modélisés sur des cerveaux d'animaux capables de reconnaître des modèles en traitant des exemples - qui ont permis aux programmeurs humains d'alimenter ces réseaux de nombreuses photos de visages, puis de s'effacer pendant que les algorithmes s'apprennent à quoi ressemblent les visages et puis comment distinguer ces visages et finalement comment décider si un visage sur une photo est le même visage sur une photo différente, même si ce visage porte des lunettes de soleil ou du maquillage ou une moustache ou est mal éclairé ou légèrement flou sur une image mais pas l'autre. Plus un algorithme doit apprendre de photos - des millions ou des milliards, idéalement - plus il devient précis. Certaines entreprises vous ont demandé de télécharger vos photos de vacances et de vous taguer dessus. Et d'autres ont demandé un selfie en échange d'une caricature auto-générée de vous ou pour vous dire à quelle célébrité ou peinture de la Renaissance vous ressemblez le plus. Et puis certaines entreprises se sont impatientées de toutes ces demandes, alors elles ont acquis les autres entreprises qui avaient déjà collecté vos photos, ou elles [scrapaient des images publiques de vous des médias sociaux et des sites de rencontres] (https://www.nbcnews.com/tech/internet/facial-recognition-s-dirty-little-secret-millions-online-photos-scraped-n981921), ou ils ont mis en place des caméras dans les espaces publics pour prendre leurs propres photos. Combien d'algorithmes ont été entraînés sur votre visage ? Difficile à dire, car il n'y a pas vraiment de lois exigeant votre consentement, mais Facebook, Google, Amazon, Apple, Microsoft, IBM et des dizaines de start-ups avec des noms comme Facefirst, FaceX et Trueface ont tous leur propre visage- algorithmes de reconnaissance, et ils ont dû apprendre quelque part. Certains de ces algorithmes sont également assez précis, du moins dans des conditions optimales. L'année dernière, le National Institute of Standards and Technology (NIST) du Département américain du commerce [a testé 127 algorithmes de reconnaissance faciale de 40 développeurs](https://nvlpubs.nist.gov/nistpubs/ir/2018/NIST.IR.8238 .pdf) pour voir à quelle fréquence ils pourraient trouver des correspondances dans une grande base de données. Avec des images de haute qualité à comparer, les algorithmes les plus performants n'ont pas réussi à renvoyer la bonne correspondance dans 0,2 % des recherches, ce qui est [20 fois mieux que les résultats d'un test similaire en 2014](https://www.nist .gov/news-events/news/2018/11/nist-evaluation-shows-advance-face-recognition-softwares-capabilities). La reconnaissance faciale s'améliorera inévitablement d'elle-même, mais elle pourrait être encore plus précise lorsqu'elle est utilisée en combinaison avec d'autres données biométriques à longue portée. En Chine, la reconnaissance de la marche identifie déjà les personnes en fonction de leur façon de marcher, avec une précision de 94 % selon une entreprise offrant le service. Et le Pentagone affirme avoir développé un [laser à pulsations cardiaques](https://www.technologyreview.com/s/613891/the-pentagon-has-a-laser-that-can-identify-people-from-a-distanceby -their-heartbeat/) - c'est-à-dire un faisceau infrarouge capable de lire la signature cardiaque unique d'une personne à travers une chemise ou une veste, prétendument avec une précision de 95 %. (Le modèle actuel peut apparemment détecter un battement de cœur à 200 mètres de distance, mais avec un laser légèrement meilleur, cependant : "Je ne veux pas dire que vous pourriez le faire depuis l'espace", a déclaré une source du Pentagone au MIT Technology Review, " mais des portées plus longues devraient être possibles. ») Pour qu'un logiciel de reconnaissance faciale vous reconnaisse dans la nature, il doit être connecté à une base de données contenant votre photo et des informations d'identification. (Ce n'est pas parce qu'un algorithme s'est entraîné avec votre visage qu'il sait qui vous êtes.) Sauf si vous êtes Elena Ferrante ou un membre de Daft Punk, et peut-être même si vous êtes eux, il y a de fortes chances que vous soyez dans une base de données ou deux. Si vous avez déjà été tagué sur une photo sur Facebook ou Instagram, par exemple, vous appartenez à ce qui est selon les propres revendications de Facebook [la plus grande base de données de reconnaissance faciale au monde] (https://research.fb.com/publications/deepface -closing-the-gap-to-human-level-performance-in-face-verification/), auquel les utilisateurs ajoutent chaque jour des centaines de millions de nouvelles images. L'algorithme de reconnaissance faciale de la société, DeepFace, qui se recycle constamment sur ces nouvelles images, est présumé être [plus précis](https://www.theverge.com/2014/7/7/5878069/why-facebook- bat-le-fbi-à-la-reconnaissance-faciale) que les logiciels utilisés par la plupart des organismes chargés de l'application de la loi. Pour l'instant, Facebook indique qu'il n'utilise DeepFace que pour suggérer des balises lorsque les utilisateurs téléchargent de nouvelles images. Mais cela n'a pas aidé l'entreprise en août lorsqu'une cour d'appel fédérale a statué que 7 millions d'utilisateurs de Facebook dans l'Illinois [peuvent poursuivre l'entreprise](https://www.Reuters.com/article/us-facebook-privacy-lawsuit/ facebook-loses-facial-recognition-appeal-must-face-privacy-class-action-idUSKCN1UY2BZ) pour avoir stocké leurs données faciales sans autorisation, ce qui, selon eux, constitue une violation de la loi sur la confidentialité des informations biométriques de l'État, actuellement la seule loi de ce type en aux États-Unis, ce qui pourrait rendre Facebook responsable jusqu'à 5 000 dollars par utilisateur concerné ou [35 milliards de dollars au total](https://arstechnica.com/tech-policy/2019/10/35-billion-facial-recognition-lawsuit-against -facebook-avancer/). (En réponse, Facebook a arrêté de suggérer des balises pour les photos par défaut.) La [base de données de reconnaissance faciale du FBI] (https://www.gao.gov/assets/700/699489.pdf) couvre les photos d'identité, le répertoire complet des photos de visas et de passeports du département d'État et les photos des départements des véhicules à moteur dans au moins 22 États (et plus) qui ont permis à l'agence de scanner les permis de conduire des résidents sans leur consentement. (Dans l'Utah, le Vermont et Washington, où les immigrants sans papiers peuvent conduire légalement, les DMV ont [partagé les données de reconnaissance faciale avec l'Immigration and Customs Enforcement](https://www.washingtonpost.com/technology/2019/07/07/fbi- ice-find-state-drivers-license-photos-are-gold-mine-facial-recognition-searches/). Si vous avez réussi à vous tenir à l'écart de la base de données du FBI jusqu'à présent, cela pourrait devenir plus difficile en octobre 2020 , lorsque les Américains de 47 États devront présenter soit un passeport, soit un nouveau [permis de conduire avec identification réelle] (https://www.tsa.gov/real-id) conforme aux normes fédérales pour embarquer sur un vol intérieur. Tout cela serait déjà assez gênant dans un monde où la sécurité des données est parfaite ou dans lequel vous pourriez obtenir un nouveau visage aussi facilement que votre banque remplace une carte de débit volée. Mais nous ne vivons dans aucun de ces mondes, et les visages ont déjà été piratés. En juin, U.S. Customs and Border Protection a annoncé que des pirates avaient piraté les serveurs de l'un de ses sous-traitants et les données faciales des voyageurs volés, dont certaines auraient [apparu sur le dark web](https://www.vice.com/en_us/article/43j5wm/here-are-images-of-drivers-hacked-from-a -nous-border-protection-contractor-on-the-dark-web-perceptics). Malgré de nombreux scandales plus méritants, aucun n'a causé autant d'hystérie en 2019 que FaceApp. En juillet, tous vos amis, ainsi que Snooki, les Jonas Brothers et Lebron James, ont partagé des photos prises avec l'outil de traitement d'images, qui sont devenues virales en faisant ressembler les utilisateurs à des personnes âgées. Mais la panique s'est ensuivie lorsqu'ils ont lu l'impitoyable [conditions d'utilisation] de FaceApp (https://www.faceapp.com/terms). ("Vous accordez à FaceApp une licence sous-licenciable perpétuelle, irrévocable, non exclusive, libre de droits, mondiale, entièrement payée et transférable pour utiliser, reproduire, modifier, adapter, publier, traduire, créer des œuvres dérivées, distribuer, exécuter publiquement et afficher votre contenu d'utilisateur et tout nom, nom d'utilisateur ou ressemblance fourni en relation avec votre contenu d'utilisateur dans tous les formats et canaux de médias connus ou développés ultérieurement, sans compensation pour vous.") dans [St. Saint-Pétersbourg, Russie] (https://www.washingtonpost.com/technology/2019/07/18/heres-what-we-know-about-russian-company-behind-faceapp/). Vladimir Poutine avait-il encore trompé l'Amérique, cette fois en lui remettant les données faciales insaisissables de ses influenceurs ? Non, ou du moins probablement pas. FaceApp a nié que l'entreprise partage des données avec des tiers, et a affirmé que la plupart des images des utilisateurs sont supprimées dans les 48 heures, qui semblait calmer les peurs. Mais si FaceApp décidait d'augmenter les enjeux et de se tourner vers la reconnaissance faciale, ce ne serait pas la première entreprise comme elle à le faire : l'application de gestion de photos EverRoll lancée en 2012 et a collecté 13 milliards d'images dans lesquelles les utilisateurs s'étaient marqués eux-mêmes et leur amis. La société mère d'EverRoll, qui s'est récemment rebaptisée Paravision, a abandonné l'application en 2016 et [a utilisé ces images pour former son logiciel de reconnaissance faciale] (https://fortune.com/longform/facial-recognition/), qui est désormais classée comme la [Non. 3 algorithme le plus précis testé par le NIST] (https://www.nist.gov/programs-projects/frvt-11-verification) et est [vendu aux forces de l'ordre] (https://fortune.com/longform/facial- reconnaissance/). Le pire des cas pour la reconnaissance faciale pourrait ressembler à quelque chose comme [le prochain "système de crédit social" de la Chine](https://www.wired.co.uk/article/china-social-credit-system- Lorsque le système sera pleinement opérationnel l'année prochaine, le gouvernement utilisera toutes les méthodes de surveillance à sa disposition, y compris la reconnaissance faciale et 200 millions de caméras, pour suivre le comportement des citoyens et attribuer à chacun d'eux un score social, qui aura une variété de conséquences. Des infractions telles que le jaywalking et l'achat de trop de jeux vidéo pourraient rendre plus difficile la location d'un appartement ou l'obtention d'un prêt auprès d'une banque. Ce n'est probablement pas le cas aux États-Unis, mais un type de surveillance plus ordinaire est presque inévitable. Peut-être est-il déjà là. La reconnaissance faciale commerciale existe depuis des années, mais comme aucune loi n'oblige quiconque à divulguer qu'il l'utilise sur vous, il est impossible de dire à quel point elle est répandue. Ce qui signifie que toute caméra que vous croisez pourrait reconnaître votre visage. Face-Six, une société basée à Tel-Aviv fondée par Moshe Greenshpan en 2012 après [Skakash](https:/ /www.broadwayworld.com/bwwtv/article/Celebrity-Face-Recognition-iPhone-App-Now-Available-for-TV-Viewers-20130207), une application mobile qu'il développait et qui aurait identifié des acteurs dans des films et des émissions de télévision , n'a pas réussi à attirer les investisseurs. Greenshpan dit qu'il sert désormais plus de 500 clients dans le monde, offrant une variété de produits personnalisés, y compris FA6 Retail (pour empêcher le vol à l'étalage) , FA6 Class (pour prendre l'assiduité dans les écoles), [FA6 Med](https://www.face-six.com/ patient-identification/) (à utiliser dans les hôpitaux pour vérifier l'identité des patients et prévenir les erreurs de traitement), et FA6 Drone (qui "identifie les criminels, les personnes disparues, et des civils à partir de la caméra d'un drone », et qui est disponible « pour des usages gouvernementaux et privés ».) Mais le produit le plus controversé de Greenshpan a été Churchix, qu'il vend aux églises qui veulent gardez une trace des paroissiens qui se présentent à la messe. Churchix a attiré une couverture négative lors de son lancement en 2015, dont certains sont liés au [site Web de l'entreprise] (https://churchix.com/press-room/). « Au début, toute la presse était bonne », dit Greenshpan. « Vous devez vraiment expliquer aux gens pourquoi la reconnaissance faciale est plus bonne que mauvaise. Les églises gèrent la fréquentation manuellement, mais lorsque nous fournissons un outil efficace qui le fait automatiquement, tout à coup, il y a des inquiétudes. » Et si ces préoccupations incluent la transparence ? "Nous ne savons pas ce que chaque client fait avec notre logiciel", dit Greenshpan, "mais généralement les églises [qui utilisent Churchix] ne le disent pas à leurs membres." Mais Greenshpan me met en contact avec David Weil, fondateur de the Warehouse, un centre de loisirs parascolaire et un parc de planche à roulettes à Bloomington, Indiana, qui utilise le logiciel de Face-Six sur deux systèmes de sécurité caméras, dans un but extrêmement précis : "Notre bâtiment s'étend sur cinq acres sous un même toit, et il y a plus de 200 délinquants sexuels enregistrés dans la région", déclare Bien. "Donc, avec autant d'espace et autant de pédophiles, ce logiciel nous a vraiment aidés." Lorsque les visiteurs entrent dans le bâtiment, les caméras scannent leurs visages et le logiciel de Face-Six les recherche dans une base de données fournie par le bureau du shérif local. Selon Weil, l'Entrepôt a enregistré 72 000 visites en 2018, et la reconnaissance faciale a réussi à éloigner deux délinquants sexuels : « Nous leur avons simplement dit poliment : "Nous sommes un centre pour jeunes". Vous n'êtes pas autorisé à être ici », dit-il. "J'avais une fausse carte d'identité, mais le monsieur comprenait très bien la situation." Parmi les autres moyens dont nous savons que la reconnaissance faciale est déjà en cours de déploiement : les compagnies aériennes l'utilisent pour remplacer les cartes d'embarquement, et le Département de la sécurité intérieure indique qu'il prévoit d'utiliser la reconnaissance faciale sur [97 % des passagers des compagnies aériennes d'ici 2022](https:// www.theverge.com/2019/4/18/18484581/us-airport-facial-recognition-departing-flights-biometric-exit). Et au moins trois arènes ont expérimenté la technologie, dont le Madison Square Garden. Aux arrêts de la récente tournée Reputation de Taylor Swift, [les visages des fans ont été scannés](https://www.theguardian.com/technology/2019/feb/15/how-taylor-swift-showed-us-the-scary-future -of-facial-recognition?CMP=fb_a-technology_b-gdntech ) et a recherché dans une base de données de ses centaines de harceleurs connus. L'année dernière, les résidents d'un complexe d'appartements à Brownsville ont protesté lorsqu'ils a découvert que leur propriétaire voulait utiliser la reconnaissance faciale pour compléter leurs porte-clés - mais d'autres bâtiments de la ville l'utilisent depuis des années, y compris les 12 qui composent le [complexe Knickerbocker Village] (https://www.wired .com/story/cities-examine-proper-improper-facial-recognition/) dans le Lower East Side. Certains systèmes de portier virtuel l'incluent également. Au moins huit districts scolaires publics aux États-Unis ont installé des systèmes de reconnaissance faciale pour détecter les élèves suspendus et toute autre personne interdite du terrain de l'école. Les détaillants utilisent la reconnaissance faciale pour prévenir le vol, et certains logiciels sont même fournis avec des bases de données de voleurs à l'étalage connus, mais peu de magasins l'admettront. L'année dernière, l'ACLU a demandé à 20 grandes chaînes de distribution si elles utilisaient la reconnaissance faciale, dont Best Buy, Costco, Target et Walmart, et n'a reçu que deux réponses – du conglomérat d'épicerie Ahold Delhaize, dont les marques incluent Food Lion et Stop & Shop, qui ne l'utilise pas, et de la chaîne de matériel Lowe's, qui a testé la reconnaissance faciale dans le passé mais s'est arrêtée depuis. Les détaillants n'ont pas besoin d'exécuter un logiciel de reconnaissance faciale dans leurs locaux pour en bénéficier. Apple nie avoir utilisé la technologie dans ses emplacements physiques, mais lors d'un incident déroutant l'année dernière, un [adolescent de New York a été arrêté](https://www.washingtonpost.com/technology/2019/04/23/teen -poursuit-apple-billion-blames-facial-recognition-stores-his-arrest/) et accusé d'avoir volé dans plusieurs Apple Stores lorsque la police a déclaré qu'il avait été identifié par reconnaissance faciale. Apple emploie apparemment une entreprise extérieure appelée Security Industry Specialists dans certains emplacements ; Le SIS a peut-être exécuté un logiciel de reconnaissance faciale sur des images de surveillance capturées dans les Apple Stores que l'adolescent aurait volé. (Les accusations ont été abandonnées contre lui lorsqu'un détective du NYPD s'est rendu compte qu'il ne ressemblait en rien au suspect dans les images des vols. En avril, l'adolescent a poursuivi Apple et SIS pour 1 milliard de dollars.) La reconnaissance faciale pourrait bientôt être plus précieuse pour les détaillants par d'autres moyens. . Une possibilité probable est que certains éliminent les files d'attente aux caisses en demandant aux clients de payer avec leur visage. Une autre consiste à utiliser la reconnaissance faciale pour cibler les personnes les plus susceptibles d'acheter des choses en suivant leurs habitudes d'achat en personne de la même manière que les cookies suivent nos habitudes en ligne - ou peut-être, éventuellement, en utilisant ce qu'ils savent de nous-mêmes virtuels pour nous diriger vers des produits dans le vrai monde. Si vous avez déjà été effrayé par une publicité étrangement bien ciblée qui vous a été diffusée sur Facebook ou Instagram, imaginez être aidé par un employé de vente au détail qui sait ce qu'il y a dans votre historique Web. Mais que se passe-t-il si vous n'êtes pas la personne que la reconnaissance faciale indique que vous êtes ? L'année dernière, l'ACLU a utilisé le logiciel de reconnaissance faciale d'Amazon, Rekognition, pour rechercher une base de données de 25 000 photos d'identité à l'aide de photos de membres du Congrès et a découvert qu'il [avait identifié à tort 28 législateurs comme des criminels](https://www.aclu.org/blog /privacy-technology/surveillance-technologies/amazons-face-recognition-falsely-matched-28), dont six membres du Congressional Black Caucus, et un test similaire cet été [confondu 26 législateurs de l'État de Californie](https://www .aclunc.org/news/facial-recognition-technology-falsely-identifies-26-california-legislators-mugshots), encore une fois avec des personnes de couleur surreprésentées dans les fausses correspondances. Amazon affirme que l'ACLU [a intentionnellement déformé son logiciel] (https://www.fastcompany.com/90389905/aclu-amazon-face-recognition-falsely-matched-ca-lawmakers) en fixant son seuil de confiance trop bas - la société recommande que la police n'agit que sur les matchs dans lesquels le système exprime une confiance d'au moins 99% - mais rien n'empêche la police de faire la même chose. "C'est édenté", déclare Jacob Snow, l'avocat de la technologie et des libertés civiles à l'ACLU qui a effectué les tests. "Amazon pourrait dire aux forces de l'ordre:" Nous allons fixer le seuil de confiance à 99%, et vous ne pouvez pas le changer. "Mais ils ne le font pas." La peau foncée n'est pas la seule chose avec laquelle la reconnaissance faciale échoue. Dans les tests du NIST, il a constaté que même les algorithmes les plus performants avaient du mal à identifier les photos de la même personne à différents âges et étaient souvent incapables de faire la différence entre des jumeaux – pas seulement des jumeaux identiques, mais aussi des jumeaux fraternels du même sexe. Et les performances dépendent de la clarté des photos utilisées. Le NIST comparait principalement des clichés de haute qualité à d'autres clichés de haute qualité, mais dans des conditions réelles, avec des photos de surveillance floues prises sous de mauvais angles par des caméras mal configurées, les résultats peuvent varier. Et si vous n'êtes pas la personne que la reconnaissance faciale dit que vous êtes ? Même un système de reconnaissance faciale avec un faible taux d'erreur peut causer des problèmes lorsqu'il est déployé à grande échelle. Au cours de six tests récents du système de reconnaissance faciale de la police de Londres, qui a scanné les visages des personnes dans les rues publiques à la recherche de suspects recherchés, [42 correspondances ont été faites mais seulement huit ont été vérifiées](https://news.sky .com/story/met-polices-facial-recognition-tech-has-81-error-rate-independent-report-says-11755941) (30 correspondances ont finalement été confirmées comme étant des erreurs d'identification et quatre des 42 personnes ont disparu dans la foule avant que les agents aient pu établir le contact). Parce qu'ils ont scanné des milliers de visages au total, la police de Londres a déclaré que son taux d'erreur était de 0,1 %, mais la plupart des gros titres ont demandé à différer : forbes.com/sites/thomasbrewster/2019/07/04/london-police-facial-recognition-fails-80-of-the-time-and-must-stop-now/#1fd5b945bf95), a déclaré l'un. La police a également été surprise en train de prendre une licence créative avec la technologie. Un rapport publié en mai par le Centre sur la confidentialité et la technologie de l'Université de Georgetown a révélé que six départements aux États-Unis permettent aux agents d'exécuter des croquis composites de suspects via un logiciel de reconnaissance faciale. Ce même rapport raconte l'histoire d'un suspect qui aurait été pris par des caméras de surveillance en train de voler de la bière dans un CVS à Gramercy Park en 2017, mais la vidéo était de mauvaise qualité et aucune correspondance utile n'a été renvoyée. Un détective a cependant remarqué que l'homme ressemblait à Woody Harrelson, alors il a lancé une recherche en utilisant une image de l'acteur – ce qui a finalement conduit à une arrestation. "La personne sur laquelle ils ont fini par enquêter était la dixième personne sur la liste des candidats", explique Clare Garvie de Georgetown Law, l'auteur du rapport, "ce qui signifie que l'algorithme pensait que neuf autres personnes [dans la base de données de photos du NYPD] semblaient plus comme Woody Harrelson. Si vous pouvez mettre la personne A dans un algorithme et trouver la personne B, pourquoi cela ne prouve-t-il pas que si vous cherchez la personne B, vous pourriez accidentellement trouver la personne A ? Ils ont intentionnellement forcé une identification erronée en tant que technique d'enquête valide. La porte-parole du NYPD, Devora Kaye, note que cette affaire n'était "que l'une des plus de 5 300 demandes" adressées au FIS en 2017. Le NYPD, dit-elle, n'utilise que la reconnaissance faciale comme outil d'enquête et n'arrête ni ne détient les suspects dont l'identité n'a pas été révélée. été corroborée par d'autres moyens. « Une correspondance par reconnaissance faciale est une piste. Personne n'a jamais été arrêté uniquement sur la base d'une correspondance informatique, aussi convaincante soit-elle. Si l'histoire de Larry Griffin II illustre une utilisation optimale de la reconnaissance faciale pour les forces de l'ordre, Kaitlin Jackson, avocate de la défense publique des Bronx Defenders, me dit celui qui expose ses inconvénients. Jackson représentait un homme qui avait été arrêté pour le vol de chaussettes d'un T.J. Magasin Maxx en février 2018, soi-disant après avoir brandi un cutter sur un agent de sécurité. "Mon client a été arrêté des mois après le vol, et la seule façon dont j'ai découvert que la reconnaissance faciale était utilisée, c'est que j'ai juste commencé à appeler le procureur et à lui dire : 'Comment diable avez-vous décidé des mois après que c'était mon client ? Il n'y a pas de médecine légale », dit-elle. "Il s'est avéré que la police est allée voir T.J. Sécurité Maxx et a déclaré: "Nous voulons retirer la surveillance \ [vidéo ], nous allons la faire passer par la reconnaissance faciale" – ils l'ont donc déjà laissé entendre que tout suspect aura été choisi par reconnaissance faciale. Et puis ils ont envoyé au garde de sécurité une seule photo qu'il sait avoir été parcourue par reconnaissance faciale, et ils ont dit: "Est-ce la personne?" C'est la procédure la plus suggestive que vous puissiez imaginer. Et puis ils procèdent à l'arrestation et disent que c'est sur la base d'une pièce d'identité \ [témoin oculaire ], et ils essaient d'enterrer qu'il s'agit d'un cas de reconnaissance faciale. (Le NYPD a déclaré que l'accusé avait déjà commis un vol dans le même magasin et a déclaré que l'agent de sécurité le connaissait "depuis des interactions antérieures". Le détective chargé de l'affaire lui a montré une image en espérant qu'elle "mettrait un nom sur un visage". département a déclaré dans un dossier juridique.) Le client de Jackson avait au moins deux lignes de défense: il a un frère jumeau, qui aurait pu déclencher le match de reconnaissance faciale – bien que Jackson ne pense pas non plus que le jumeau ait volé des chaussettes – mais plus important , sa femme était en travail au moment du vol et il se trouvait dans la salle d'accouchement. "Nous avions des photos d'eux à l'hôpital, et son nom figurait sur le certificat de naissance", explique Jackson. Mais l'accusation ne rejetterait pas l'affaire - en partie, soupçonne-t-elle, parce qu'ils ont une "foi éternelle que le logiciel ne se trompe pas". Leur seul recours, a-t-elle dit, serait d'argumenter: "Peut-être qu'il est parti quelques minutes avant l'accouchement de son bébé et s'est enfui chercher des chaussettes, puis est revenu." Jackson dit que son client a passé la moitié de l'année dernière en prison. « Il était en probation lorsqu'il a été arrêté. Donc, notre vrai problème était la façon dont tous ces systèmes interagissent. La probation a déposé une suspension, et ils ne retireraient pas la suspension à cause de cette affaire, et l'accusation ne rejetterait pas cette affaire. Et puis finalement [le parquet] lui a proposé quelque chose qui le ferait sortir de prison. Alors il a fait ce que beaucoup d'entre nous feraient - il a plaidé pour quelque chose qu'il n'avait pas fait. Mais la reconnaissance faciale ne concerne pas seulement qui vous êtes, ce que vous avez acheté, les crimes que vous avez commis ou non, et si votre ressemblance avec un délinquant sexuel rendra difficile la recherche d'endroits où skateboard - c'est aussi ce que vous ressentez. Parce qu'une autre chose que la technologie peut faire, ou du moins est censée faire, est de détecter les émotions. Amazon, IBM, Microsoft et d'autres affirment que leur logiciel peut deviner quelle émotion vous ressentez en fonction de vos expressions faciales - ou dans certains cas microexpressions, sous le logique que même si vous essayez de cacher vos sentiments, certains muscles faciaux sont hors de votre contrôle. Amazon, par exemple, dit que Rekognition peut déduire si un visage exprime [bonheur, tristesse, colère, confusion, dégoût, surprise, calme ou peur](https://docs.aws.amazon.com/rekognition/latest/dg /API_Emotion.html?ascsubtag=[]in[p]ck2v0oszv000ponyenxurdvlm&tag=thestrategistsite-20 ) - bien que la documentation prévienne que les résultats "ne sont pas une détermination de l'état émotionnel interne d'une personne et ne doivent pas être utilisés de cette manière", et que "une personne prétendant avoir un visage triste peut ne pas être émotionnellement triste." D'autres fournisseurs sont plus confiants dans leurs capacités de lecture d'humeur. La start-up londonienne RealEyes propose aux annonceurs un service qui scanne le visage des gens via les webcams de leurs ordinateurs pour mesurer leur niveau d'attention et leurs émotions lorsqu'ils regardent des publicités. La société basée dans l'Utah Hirevue affirme que son logiciel peut analyser les entretiens d'embauche vidéo pour juger des traits de personnalité et éliminer les candidats désintéressés. (Les [clients] de Hirevue(https://www.hirevue.com/customers) incluent Dunkin' Donuts, Staples et Urban Outfitters.) Sur son site Web, le La société de reconnaissance faciale Kairos se vante du travail qu'elle a accompli pour Legendary Pictures en mesurant les réactions des membres du public lors des projections de films tests : "Plus de 450 000 mesures émotionnelles ont été enregistrées par minute au cours de la projection des films de prévisualisation, pour un total d'environ 100 millions de mesures faciales traité au total. Kairos dit que Legendary a utilisé ces données pour déterminer quelles parties des films fonctionnaient le mieux dans les publicités, identifier "les données démographiques les plus susceptibles de partager des bandes-annonces" et s'assurer que les films de Legendary étaient "attrayants pour le grand public ainsi que pour les fans ciblés". Ni Kairos ni Legendary Pictures ne confirmeraient quels films étaient impliqués, mais la PDG de Kairos, Melissa Doval, dit que les projections ont probablement eu lieu en 2013 ou 2014, et il y a une photo du film Superman de 2013 [Man of Steel](https://www.vulture. com/2013/06/movie-review-man-of-steel.html) sur le site Web de Kairos. Vos tics faciaux ne vous feront pas nécessairement perdre des emplois ou donneront une mauvaise impression de vos goûts pour les films de super-héros, car les logiciels de détection des émotions peuvent ne pas vraiment fonctionner. En juillet, un groupe de cinq psychologues de haut niveau a publié un rapport dans Psychological Science in the Public Interest, qui citait plus de 1 000 autres articles de journaux et ont constaté que les expressions faciales sont plus complexes que ce que le logiciel leur attribue : « Il n'est pas possible de déduire avec confiance le bonheur d'un sourire, la colère d'un air renfrogné ou la tristesse d'un froncement de sourcils, car la plupart des technologies actuelles essaient à faire lors de l'application de ce que l'on croit à tort être des faits scientifiques. ** En fin de compte, la chose la plus inquiétante ** à propos de la reconnaissance faciale pourrait être son accessibilité. Parce qu'il n'est pas seulement disponible pour les gouvernements et les entreprises - il est également à vendre à vous, à moi, à votre propriétaire, à des pervers aléatoires et à toute autre personne disposant d'un appareil photo et d'un ordinateur, et pour moins cher que ce à quoi vous vous attendriez probablement : Amazon's Rekognition, par exemple , offre un essai gratuit d'un an qui vous permet d'identifier les visages dans 5 000 images ou 1 000 minutes de vidéo par mois (et après, c'est un centime pour dix photos ou dix centimes par minute de vidéo). Si aucun des progiciels prêts à l'emploi ne répond à vos besoins particuliers, il s'avère qu'il est assez facile, si vous savez ce que vous faites, de lancer votre propre application de reconnaissance faciale à l'aide du code open-source. J'ai regardé un tutoriel YouTube dans lequel un programmeur a construit son propre système de reconnaissance faciale qui pouvait distinguer son visage et le casting de Game of Thrones. Il n'est pas difficile d'imaginer des applications plus sinistres. Ce printemps, un développeur a affirmé sur les réseaux sociaux chinois qu'il avait utilisé la reconnaissance faciale et des photos accessibles au public sur Facebook et Instagram pour [identifier 100 000 femmes dans des vidéos porno amateur] (https://www.vice.com/en_us/article/ 9kxny7/diy-facial-recognition-for-porn-weibo). Il n'a partagé aucune preuve et a peut-être menti - mais étant donné toutes les autres choses apparemment incroyables sur la reconnaissance faciale que nous savons maintenant être vraies, peut-être qu'il ne l'était pas. Je voulais expérimenter moi-même, alors j'ai acheté un Tend Insights Lynx Indoor 2, un petit et pas cher mais [bien revu](https: //www.yahoo.com/lifestyle/60-home-security-camera-facial-recognition-rivals-299-one-heres-013930138.html) caméra de sécurité domestique livrée avec son propre logiciel de reconnaissance faciale. Cela a bien fonctionné pour ce qu'il a fait, ce qui dans mon cas n'était pas grand-chose : j'ai placé l'appareil photo sur mon bureau, je l'ai connecté à mon réseau Wi-Fi, j'ai téléchargé l'application iPhone associée et j'ai téléchargé une photo de moi pour qu'il sache quoi je ressemblais. J'ai quitté mon appartement, et en quelques minutes quand je suis revenu, le Lynx a envoyé une notification push sur mon téléphone pour me dire que j'étais à la maison, avec une courte vidéo pour preuve. Cela peut ne pas ressembler à 60 $ bien dépensé, mais il était un petit prix pour un sentiment de contrôle que je n'aurais peut-être plus jamais : Après le test inaugural de mon système de reconnaissance faciale à la maison, je l'ai débranché et je l'ai fourré dans un tiroir.