Incidents associés

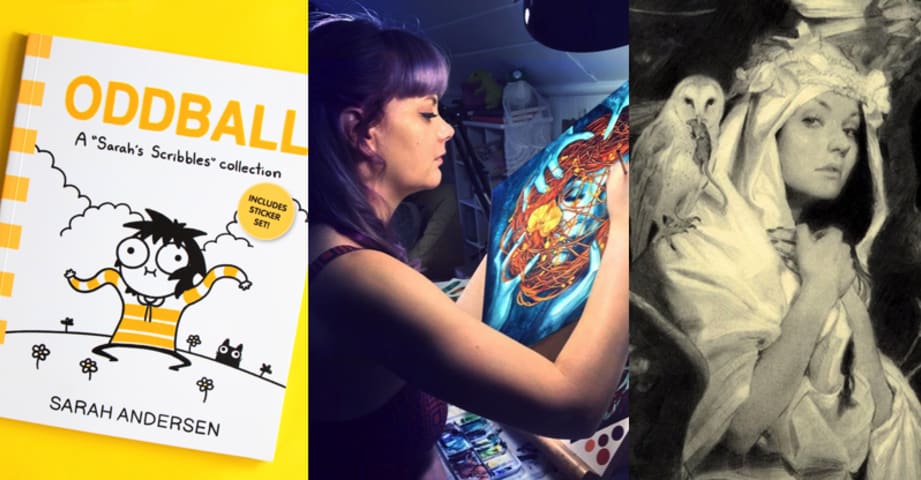

Bonjour. C'est Matthew Butterick. Je suis écrivain, designer, programmeur et avocat. En novembre 2022, j'ai fait équipe avec les incroyablement excellents plaideurs en recours collectif [Joseph Saveri](https://saverilawfirm.com/attorneys/joseph-r- saveri/), Cadio Zirpoli et Travis Manfredi au Joseph Saveri Law Cabinet pour déposer une poursuite contre GitHub Copilot pour son « open-source sans précédent piratage de logiciels ». (Ce procès est toujours en cours.) Depuis lors, nous avons entendu des gens du monde entier, en particulier des écrivains, des artistes, des programmeurs et d'autres créateurs, qui s'inquiètent de l'IA. systèmes formés sur de grandes quantités d'œuvres protégées par le droit d'auteur sans consentement, sans crédit et sans compensation. Aujourd'hui, nous faisons un pas de plus vers une IA équitable et éthique pour tous. Au nom de trois merveilleuses artistes plaignantes—Sarah Andersen, Kelly McKernan et Karla Ortiz—nous Nous avons intenté un recours collectif contre Stability AI, DeviantArt et Midjourney pour leur utilisation de [Stable Diffusion](https://stability. ai/blog/stable-diffusion-announcement), un outil de collage du 21e siècle qui remixe les œuvres protégées par le droit d'auteur de millions d'artistes dont le travail a été utilisé comme données de formation. Les formidables plaideurs Brian Clark et [Laura Matson](https://www.locklaw.com/professionals /laura-m-matson/) de Lockridge Grindal Nauen P.L.L.P. Dépôts d'aujourd'hui : * [Plainte en recours collectif](pdf/00201/1-1-stable-diffusion- plainte.pdf) * Plainte en recours collectif : Pièces En tant qu'avocat également membre de longue date de la communauté des arts visuels, c'est un honneur de prendre la parole au nom d'autres artistes et de poursuivre cette conversation vitale sur la façon dont l'IA coexistera avec la culture et la créativité humaines. Les entreprises génératrices d'images ont clairement exprimé leur point de vue. Maintenant, ils peuvent entendre des artistes. ## Un outil de collage du 21ème siècle "Le Concert" de Johannes Vermeer, volé au Gardner Museum Stable Diffusion est un logiciel d'intelligence artificielle (IA) produit, publié en août 2022 par une société appelée Stability AI. Stable Diffusion contient des copies non autorisées de millions, voire de milliards, d'images protégées par le droit d'auteur. Ces copies ont été faites à l'insu ou sans le consentement des artistes. Même en supposant des dommages nominaux de 1 $ par image, la valeur de ce détournement serait d'environ 5 milliards de dollars. (À titre de comparaison, le plus grand braquage d'œuvres d'art de tous les temps a été celui de 1990 le vol de 13 œuvres d'art au Musée Isabella Stewart Gardner, avec une valeur actuelle estimée à 500 millions de dollars.) La diffusion stable appartient à une catégorie de systèmes d'IA appelée IA générative. Ces systèmes sont entraînés sur un certain type de travail créatif – par exemple du texte, du code logiciel ou des images – puis remixent ces travaux pour dériver (ou « générer ») d'autres travaux du même type. Après avoir copié les cinq milliards d'images - sans le consentement des artistes originaux - Stable Diffusion s'appuie sur un processus mathématique appelé diffusion pour stocker des copies compressées de ces images d'entraînement, qui à leur tour sont recombinées dériver d'autres images. C'est, en bref, un outil de collage du 21e siècle. Ces images résultantes peuvent ou non ressemblent extérieurement aux images de formation. Néanmoins, ils sont dérivés de copies des images de formation et leur font concurrence sur le marché. Au minimum, la capacité de Stable Diffusion à inonder le marché avec un nombre pratiquement illimité d'images contrefaisantes infligera des dommages permanents au marché de l'art et des artistes. Même le PDG de Stability AI, Emad Mostaque a prévu que "Les futurs modèles [AI] seront entièrement sous licence". Mais la diffusion stable ne l'est pas. C'est un parasite qui, s'il est autorisé à proliférer, causera un préjudice irréparable aux artistes, aujourd'hui et à l'avenir. ## Le problème de la diffusion La technique de diffusion a été inventée en 2015 par des chercheurs en intelligence artificielle de l'université de Stanford. Le schéma ci-dessous, issu des recherches de l'équipe de Stanford, illustre les deux phases du processus de diffusion à l'aide de données d'entraînement en forme de spirale. La première phase de la diffusion consiste à prendre une image (ou d'autres données) et à y ajouter progressivement plus de bruit visuel en une série d'étapes. (Ce processus est décrit dans la rangée supérieure du diagramme.) À chaque étape, l'IA enregistre comment l'ajout de bruit modifie l'image. Lors de la dernière étape, l'image a été « diffusée » dans un bruit essentiellement aléatoire. La deuxième phase est comme la première, mais en sens inverse. (Ce processus est décrit dans la rangée inférieure du diagramme, qui ** se lit de droite à gauche **.) Après avoir enregistré les étapes qui transforment une certaine image en bruit, l'IA peut exécuter ces étapes à l'envers. En commençant par un bruit aléatoire, l'IA applique les étapes en sens inverse. En supprimant le bruit (ou "débruitant") les données, l'IA produira une copie de l'image originale. Dans le diagramme, la spirale reconstruite (en rouge) a des parties floues dans la moitié inférieure que la spirale d'origine (en bleu) n'a pas. Bien que la spirale rouge soit clairement une copie de la spirale bleue, en termes informatiques, on l'appellerait une copie lossy, ce qui signifie que certains détails sont perdus lors de la traduction. C'est le cas de nombreux formats de données numériques, y compris MP3 et JPEG, qui font également des copies hautement compressées de données numériques en omettant de petits détails. En bref, la diffusion est un moyen pour un programme d'IA de comprendre comment reconstruire une copie des données d'apprentissage par débruitage. Parce qu'il en est ainsi, en termes de droit d'auteur, ce n'est pas différent d'un MP3 ou d'un JPEG, un moyen de stocker une copie compressée de certaines données numériques. ### Interpolation avec des images latentes En 2020, la technique de diffusion a été améliorée par des chercheurs de l'UC Berkeley de deux manières : 1. Ils ont montré comment un modèle de diffusion pouvait stocker ses former des images dans un format plus compressé sans affecter sa capacité à reconstruire des copies haute fidélité. Ces copies compressées d'images d'entraînement sont appelées images latentes. 2. Ils ont découvert que ces images latentes pouvaient être interpolées, c'est-à-dire mélangées mathématiquement, pour produire de nouvelles images dérivées. Le diagramme ci-dessous, tiré des recherches de l'équipe de Berkeley, montre comment ce processus fonctionne. L'image dans le cadre rouge a été interpolée à partir des deux images "Source" pixel par pixel. Cela ressemble à deux images de visage translucides empilées l'une sur l'autre, pas à un seul visage convaincant. L'image dans le cadre vert a été générée différemment. Dans ce cas, les deux images sources ont été compressées en images latentes. Une fois ces images latentes interpolées, cette image latente nouvellement interpolée a été reconstruite en pixels en utilisant le processus de débruitage. Par rapport à l'interpolation pixel par pixel, l'avantage est évident : l'interpolation basée sur des images latentes ressemble à un seul visage humain convaincant, et non à une superposition de deux visages. Malgré la différence des résultats, en termes de droit d'auteur, ces deux modes d'interpolation sont équivalents : ils génèrent tous deux des œuvres dérivées en interpolant deux images sources. * La diffusion stable convertit les images d'apprentissage en images latentes à l'aide d'un autoencodeur variationnel (ou VAE). Pour un aperçu général, voir Intuitively Understanding Variational Autoencoders (qui note que ces systèmes sont conçus pour "explorer les variations des données que vous avez déjà" et qu'ils sont "spécifiquement utiles pour reconstruire [leur] propre entrée"). Pour des exemples d'utilisation de l'auto-encodeur variationnel de Stable Diffusion, voir [Stable Diffusion using Hugging Face—Looking under the hood](https://aayushmnit.com/posts/2022-11-05-StableDiffusionP2/2022-11-05-StableDiffusionP2. html#vae---variational-auto-encoder) (inclut un exemple de code Python et note que "l'encodeur agit comme un compresseur qui écrase l'image... et le décodeur recrée l'image d'origine"). Pour des exemples de ses caractéristiques de compression avec perte, voir Stable Diffusion Based Image Compression. * Mathématiquement, les images latentes produites par un auto-encodeur sont modélisées comme des points dans un espace géométrique multidimensionnel appelé espace latent. Pour un aperçu général de la façon dont les images latentes sont stockées et interpolées dans l'espace latent, voir Understanding Latent Space in Machine Learning et [ Visualisation de l'espace latent] (https://hackernoon.com/latent-space-visualization-deep-learning-bits-2-bd09a46920df) (les deux ont d'excellents diagrammes et exemples). Pour obtenir des exemples d'interpolation d'image latente à l'aide de Stable Diffusion, consultez A walk through latent space with Stable Diffusion (comprend un exemple de code Python). * Les chercheurs de l'UC Berkeley ont également introduit l'idée de gérer la diffusion avec un modèle d'IA appelé U-Net. Le U-Net a été inventé par des chercheurs biomédicaux à Fribourg, en Allemagne, en 2015 dans le but de segmenter l'image, ou de détecter des groupes de pixels visuellement liés. Pour ce faire, le U-Net applique un ensemble de compressions et de décompressions à l'image. Pour en savoir plus sur la façon dont Stable Diffusion s'appuie sur un U-Net, voir Stable Diffusion with Diffusers, [Stable Diffusion using Hugging Face—Looking under the hood](https:/ https://towardsdatascience.com/ vous-ne-pouvez-pas-épeler-diffusion-sans-u-60635f569579). ### Conditionnement avec invites textuelles En 2022, la technique de diffusion a encore été améliorée par des chercheurs de Munich. Ces chercheurs ont découvert comment façonner le processus de débruitage avec des informations supplémentaires. Ce processus est appelé conditionnement. (L'un de ces chercheurs, Robin Rombach, est maintenant employé par Stability AI en tant que développeur de Stable Diffusion.) Seul le chien en bas à gauche semble manger de la glace. Les deux sur la droite semblent manger de la viande, pas de la crème glacée. L'outil de conditionnement le plus courant consiste en de courtes descriptions textuelles, également appelées invites de texte, qui décrivent des éléments de l'image, par exemple : "un chien portant une casquette de baseball en mangeant de la glace". (Résultat affiché à droite.) Cela a donné naissance à l'interface dominante de Stable Diffusion et d'autres générateurs d'images AI : convertir une invite de texte en image. L'interface d'invite de texte a cependant un autre objectif. Cela crée une couche de mauvaise direction magique qui rend plus difficile pour les utilisateurs d'obtenir des copies évidentes des images de formation (mais pas impossible). Néanmoins, étant donné que toutes les informations visuelles du système sont dérivées des images d'entraînement protégées par le droit d'auteur, les images produites, quelle que soit leur apparence extérieure, sont nécessairement des œuvres dérivées de ces images d'entraînement. ### Comment Stable Diffusion combine ces éléments Dans Stable Diffusion, les éléments décrits ci-dessus sont implémentés sous la forme de trois modèles d'IA distincts qui coopèrent. Pour plus de détails sur la façon dont ces trois modèles fonctionnent ensemble, voir [Stable Diffusion using Hugging Face—Looking under the hood](https://aayushmnit.com/posts/2022-11-05-StableDiffusionP2/2022-11-05-StableDiffusionP2. html) et La diffusion stable illustrée. ## Les accusés ### Stability AI Stability AI, fondée par Emad Mostaque, est basée à Londres. Stability AI a financé LAION, une organisation allemande qui crée des ensembles de données d'images de plus en plus volumineux (sans consentement, crédit ou compensation pour les artistes originaux) à l'usage des sociétés d'IA. Stability AI est le développeur de Stable Diffusion. Stability AI a formé Stable Diffusion à l'aide de l'ensemble de données LAION. Stability AI a également lancé DreamStudio, une application payante qui regroupe Stable Diffusion dans une interface Web. ### DeviantArt DeviantArt a été fondée en 2000 et est depuis longtemps l'une des plus grandes communautés d'artistes sur le Web. Comme le montrent Simon Willison et Andy Baio, des milliers - et probablement plus près de millions - d'images dans LAION ont été copiées de DeviantArt et utilisé pour entraîner la diffusion stable. Plutôt que de défendre sa communauté d'artistes en les protégeant contre la formation à l'IA, DeviantArt a plutôt choisi de sortir DreamUp, une application payante construite autour de Stable Diffusion. À son tour, un flot d'art généré par l'IA a inondé DeviantArt, évinçant les artistes humains. Lorsqu'ils ont été confrontés à l'éthique et à la légalité de ces manœuvres lors d'une session de questions-réponses en direct en novembre 2022, les membres de l'équipe de direction de DeviantArt, dont le PDG Moti Levy, ne pouvait pas expliquer pourquoi ils avaient trahi leur communauté d'artistes en adoptant Stable Diffusion, tout en violant intentionnellement leurs propres conditions d'utilisation et leur politique de confidentialité. ### Midjourney Midjourney a été fondée en 2021 par David Holz à San Francisco. Midjourney propose un générateur de texte en image via Discord et une application Web. Bien que se présentant comme un "laboratoire de recherche", Midjourney a cultivé un large public de clients payants qui utilisent professionnellement le générateur d'images de Midjourney. Holz a dit il veut que Midjourney soit "axé sur rendre tout beau et artistique. À cette fin, Holz [a admis](https://www.forbes.com/sites/robsalkowitz/2022/09/16/midjourney-founder-david-holz-on-the-impact-of-ai-on- art-imagination-and-the-creative-economy) que Midjourney s'est entraîné sur "un gros coup d'internet". Cependant, interrogé sur l'éthique de la copie massive d'images de formation, il a dit—> Il n'y a pas de lois spécifiques à ce sujet. Et quand Holz a en outre été interrogé sur le fait de permettre aux artistes de se retirer de la formation, [il a dit](https://www.forbes.com/sites/robsalkowitz/2022/09/16/midjourney-founder-david-holz-on- l'impact-de-l'IA-sur-l'imagination-artistique-et-l'économie-créative)—> Nous examinons cela. Le défi est maintenant de savoir quelles sont les règles. Nous sommes impatients d'aider M. Holz à découvrir les nombreuses lois étatiques et fédérales qui protègent les artistes et leur travail. ## Les plaignants Nos plaignants sont de merveilleux artistes accomplis qui se sont portés volontaires pour représenter une classe de milliers, voire de millions, d'autres artistes touchés par l'IA générative. ### Sarah Andersen Sarah Andersen est dessinatrice et illustratrice. Elle est diplômée du Maryland Institute College of Art en 2014. Elle vit actuellement à Portland, Oregon. Sa bande dessinée semi-autobiographique, Sarah's Scribbles, trouve l'humour de vivre comme une introvertie. Son roman graphique FANGS a été nominé pour un prix Eisner. Sarah a également écrit The Alt-Right Manipulated My Comic. Puis A.I. Je l'ai revendiqué pour le New York Times. ### Kelly McKernan Kelly McKernan est une artiste indépendante basée à Nashville. Ils sont diplômés de la Kennesaw State University en 2009 et sont artistes à temps plein depuis 2012. Kelly crée des peintures originales à l'aquarelle et à la gouache acrylique pour des galeries, des commandes privées et leur [boutique en ligne] (https://www.kellymckernan.com/ boutique). En plus de maintenir un large public sur les réseaux sociaux, Kelly partage des tutoriels et enseigne des ateliers, voyage à travers les États-Unis pour des événements et des bandes dessinées, et crée également des illustrations pour des livres, des bandes dessinées, des jeux, etc. ### Karla Ortiz Karla Ortiz est une artiste portoricaine internationalement reconnue et primée. Avec son sens du design exceptionnel, ses rendus réalistes et ses récits axés sur les personnages, Karla a contribué à de nombreux projets à gros budget dans les industries du cinéma, de la télévision et des jeux vidéo. Karla est également illustratrice régulière pour de grandes sociétés d'édition et de jeux de rôle. L'art figuratif et mystérieux de Karla a été présenté dans des galeries remarquables telles que Spoke Art et Hashimoto Contemporary à San Francisco; Nucleus Gallery, Thinkspace et Maxwell Alexander Gallery à Los Angeles ; et Galerie Arludik à Paris. Elle vit actuellement à San Francisco avec son chat Bady. Si vous êtes un membre de la presse ou du public avec d'autres questions sur cette affaire ou des sujets connexes, contactez stablediffusion_inquiries@saverilawfirm.com. (Mais s'il vous plaît, n'envoyez pas d'informations confidentielles ou privilégiées.) Cette page Web est informative. Les principes généraux du droit sont discutés. Mais ni Matthew Butterick ni personne du cabinet d'avocats Joseph Saveri ou de Lockridge Grindal Nauen n'est votre avocat, et rien n'est proposé ici comme conseil juridique. Les références au droit d'auteur relèvent de la législation américaine. Cette page sera mise à jour au fur et à mesure que de nouvelles informations seront disponibles.