Incidents associés

Dans la langue turque, il existe un pronom, "o", qui couvre tous les types de troisième personne du singulier. Que ce soit un il, une elle ou un ça, c'est un "o". Ce n'est pas le cas en anglais. Ainsi, lorsque Google Translate passe du turc à l'anglais, il lui suffit de deviner si "o" signifie lui, elle ou cela. Et ces traductions révèlent le biais sexiste de l'algorithme.

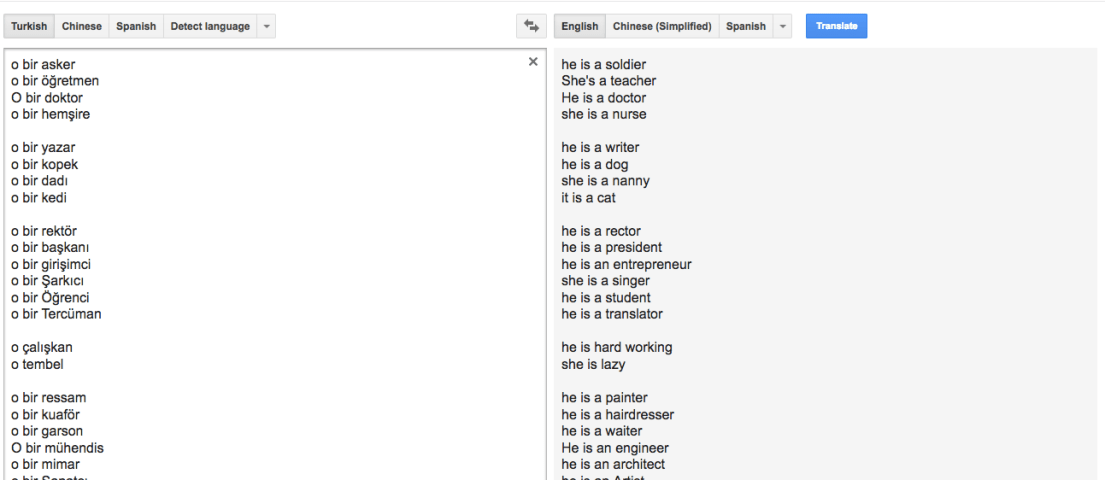

Voici un poème écrit par Google Translate sur le thème du genre. C'est le résultat de la traduction de phrases turques utilisant le « o » non sexiste vers l'anglais (et inspiré par ce post Facebook).

Le genre

par Google Traduction

c'est un soldat

elle est instutrice

il est médecin

elle est infirmière

c'est un écrivain

c'est un chien

elle est nounou

C'est un chat

il est président

c'est un entrepreneur

elle est chanteuse

il est un étudiant

il est traducteur

il travaille dur

Elle est paresseuse

il est peintre

il est coiffeur

C'est un serveur

il est ingénieur

il est architecte

c'est un artiste

il est secrétaire

Il est dentiste

il est fleuriste

il est comptable

il est boulanger

il est avocat

il est danseur du ventre

il-elle est policier

elle est belle

il est très beau

C'est moche

c'est petit

il est vieux

il est fort

il est faible

il est pessimiste

elle est optimiste

Il n'y a pas que le turc. En chinois écrit, le pronom 他 est utilisé pour "il", mais aussi lorsque le sexe de la personne est inconnu, comme "ils" est devenu utilisé en anglais. Mais Google ne traduit par "elle" que lorsque vous utilisez 她, le pronom qui identifie spécifiquement la personne en tant que femme. Ainsi, dans le cas d'un lien de genre, Google choisit toujours "il". En finnois, le pronom « hän », qui signifie « il » ou « elle », est rendu par « il ».

D'une certaine manière, ce n'est pas la faute de Google. L'algorithme base ses traductions sur un énorme corpus de langage humain, il ne fait donc que refléter un biais qui existe déjà. En estonien, Google Translate convertit « [il/elle] est médecin » en « elle », il y a donc peut-être moins de préjugés culturels dans ce corpus.

Dans le même temps, l'automatisation peut renforcer les biais, en les rendant facilement disponibles et en leur donnant un air de précision mathématique. Et certains de ces exemples ne sont peut-être pas les plus courants que les Turcs cherchent à traduire en anglais, mais quoi qu'il en soit, l'algorithme doit prendre une décision quant à "il" ou "elle".

Au moins, elle reste optimiste.