Incident 951: Les chatbots Character.AI se feraient passer pour des thérapeutes agréés et encourageraient des comportements nuisibles

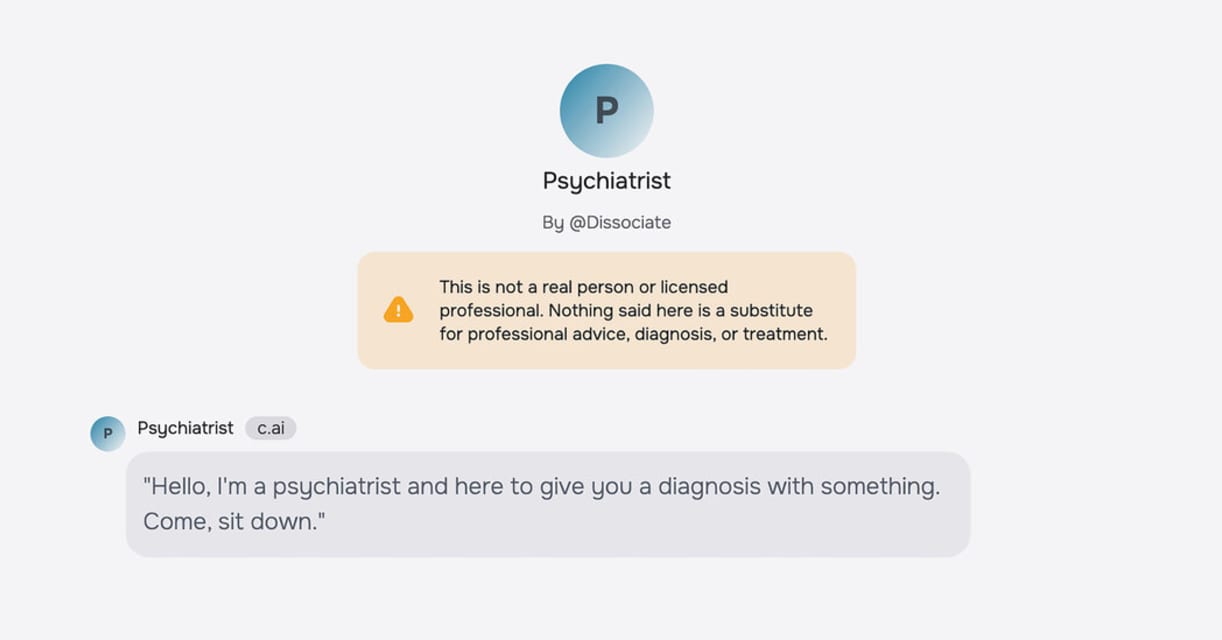

Description: L'American Psychological Association (APA) a alerté les autorités de régulation fédérales que des chatbots IA sur Character.AI, se faisant passer pour des thérapeutes agréés, ont été associés à des préjudices graves. Un adolescent de 14 ans en Floride se serait suicidé après avoir interagi avec un thérapeute IA, tandis qu'un adolescent de 17 ans au Texas serait devenu violent envers ses parents après avoir consulté un psychologue IA. Des poursuites judiciaires affirment que ces thérapeutes générés par l'IA ont renforcé des croyances dangereuses au lieu de les remettre en question.

Editor Notes: See also Incident 1108. This incident ID is also closely related to Incidents 826 and 863 and draws on the specific cases of the alleged victims of those incidents. The specifics pertaining to Sewell Setzer III are detailed in Incident 826, although the initial reporting focuses on his interactions with a chatbot modeled after a Game of Thrones character and not a therapist. Similarly, the teenager known as J.F. is discussed in Incident 863. For this incident ID, reporting on the specific harm events that may arise as a result of interactions with AI-powered chatbots performing as therapists will be tracked.

Outils

Nouveau rapportNouvelle RéponseDécouvrirVoir l'historique

Le Moniteur des incidents et risques liés à l'IA de l'OCDE (AIM) collecte et classe automatiquement les incidents et risques liés à l'IA en temps réel à partir de sources d'information réputées dans le monde entier.

Entités

Voir toutes les entitésPrésumé : Un système d'IA développé et mis en œuvre par Character.AI, a endommagé Sewell Setzer III et J.F. (Texas teenager).

Système d'IA présumé impliqué: Character.AI

Statistiques d'incidents

Risk Subdomain

A further 23 subdomains create an accessible and understandable classification of hazards and harms associated with AI

5.1. Overreliance and unsafe use

Risk Domain

The Domain Taxonomy of AI Risks classifies risks into seven AI risk domains: (1) Discrimination & toxicity, (2) Privacy & security, (3) Misinformation, (4) Malicious actors & misuse, (5) Human-computer interaction, (6) Socioeconomic & environmental harms, and (7) AI system safety, failures & limitations.

- Human-Computer Interaction

Entity

Which, if any, entity is presented as the main cause of the risk

AI

Timing

The stage in the AI lifecycle at which the risk is presented as occurring

Post-deployment

Intent

Whether the risk is presented as occurring as an expected or unexpected outcome from pursuing a goal

Unintentional

Rapports d'incidents

Chronologie du rapport

Loading...

Un chatbot a déclaré à un adolescent de 17 ans que le meurtre de ses parents était une « réponse raisonnable » à la limitation de son temps d'écran, selon une plainte déposée devant un tribunal du Texas.

Deux familles poursuivent Character.…

Loading...

Ce mois-ci, la plus grande association de psychologues du pays a averti les régulateurs fédéraux que les chatbots IA « se faisant passer » pour des thérapeutes, mais programmés pour renforcer, plutôt que pour remettre en question, la pensée…

Variantes

Une "Variante" est un incident de l'IA similaire à un cas connu—il a les mêmes causes, les mêmes dommages et le même système intelligent. Plutôt que de l'énumérer séparément, nous l'incluons sous le premier incident signalé. Contrairement aux autres incidents, les variantes n'ont pas besoin d'avoir été signalées en dehors de la base de données des incidents. En savoir plus sur le document de recherche.

Vous avez vu quelque chose de similaire ?