Incident 895: Un prétendu deepfake concernant un endocrinologue néo-zélandais favoriserait une allégation trompeuse sur le diabète

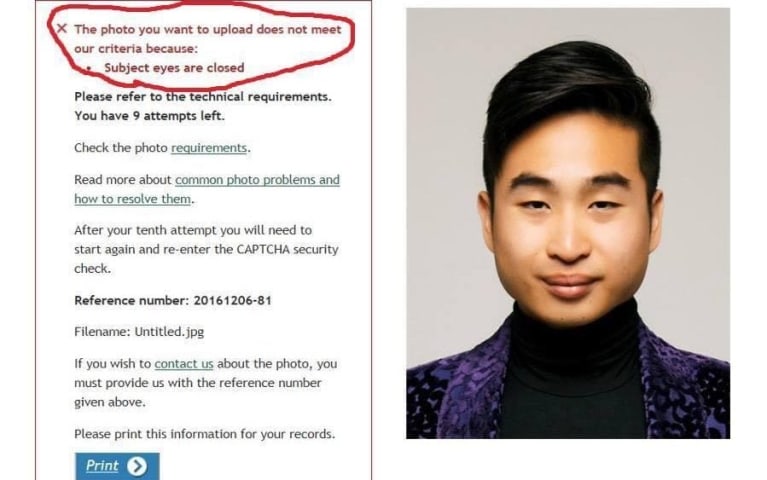

Description: Une vidéo a circulé sur les réseaux sociaux, montrant Sir Jim Mann, endocrinologue à l'Université d'Otago, faisant la promotion d'un produit à base de gommes de chanvre destiné aux diabétiques et les exhortant à arrêter la metformine. La vidéo aurait été générée par l'IA et aurait diffusé des images et des propos manipulés présentant de faux conseils médicaux.

Entités

Voir toutes les entitésAlleged: Unknown deepfake technology developers developed an AI system deployed by Unknown scammers, which harmed New Zealand general public , Jim Mann et Diabetes patients.

Système d'IA présumé impliqué: Unknown deepfake app

Statistiques d'incidents

Risk Subdomain

A further 23 subdomains create an accessible and understandable classification of hazards and harms associated with AI

4.3. Fraud, scams, and targeted manipulation

Risk Domain

The Domain Taxonomy of AI Risks classifies risks into seven AI risk domains: (1) Discrimination & toxicity, (2) Privacy & security, (3) Misinformation, (4) Malicious actors & misuse, (5) Human-computer interaction, (6) Socioeconomic & environmental harms, and (7) AI system safety, failures & limitations.

- Malicious Actors & Misuse

Entity

Which, if any, entity is presented as the main cause of the risk

Human

Timing

The stage in the AI lifecycle at which the risk is presented as occurring

Post-deployment

Intent

Whether the risk is presented as occurring as an expected or unexpected outcome from pursuing a goal

Intentional

Rapports d'incidents

Chronologie du rapport

Loading...

Un éminent spécialiste du diabète est alarmé par le fait qu'une fausse vidéo d'information utilisant son image qui exhorte les gens à arrêter de prendre leurs médicaments puisse rendre les gens malades.

L'Université d'Otago s'inquiète d'une…

Loading...

Un endocrinologue bien connu en Nouvelle-Zélande a récemment été victime d'une arnaque deepfake, selon un reportage du New Zealand Herald.

L'image de Sir Jim Mann, DM, PhD, MA, de l'Université d'Otago, a été utilisée dans une vidéo deepfake…

Variantes

Une "Variante" est un incident de l'IA similaire à un cas connu—il a les mêmes causes, les mêmes dommages et le même système intelligent. Plutôt que de l'énumérer séparément, nous l'incluons sous le premier incident signalé. Contrairement aux autres incidents, les variantes n'ont pas besoin d'avoir été signalées en dehors de la base de données des incidents. En savoir plus sur le document de recherche.

Vous avez vu quelque chose de similaire ?

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Loading...

Biased Google Image Results

· 18 rapports

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Loading...

Biased Google Image Results

· 18 rapports