Entités

Voir toutes les entitésStatistiques d'incidents

Classifications de taxonomie GMF

Détails de la taxonomieKnown AI Goal

Image Cropping

Known AI Technology

Neural Network

Known AI Technical Failure

Generalization Failure

Potential AI Technical Failure

Distributional Bias, Incomplete Data Attribute Capture

Rapports d'incidents

Chronologie du rapport

- Afficher le rapport d'origine à sa source

- Voir le rapport sur l'Archive d'Internet

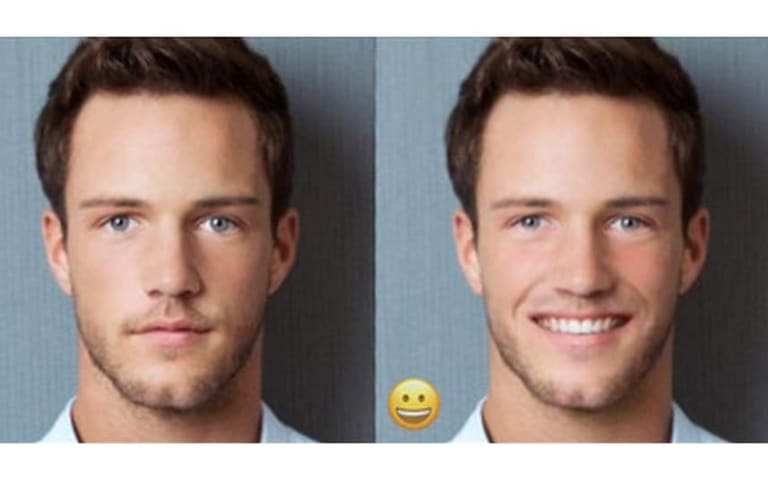

L'algorithme de Twitter pour recadrer automatiquement les images jointes aux tweets ne se concentre souvent pas sur le contenu important qu'ils contiennent. Un problème, bien sûr, mais cela semble mineur à la surface. Cependant, au cours du…

- Afficher le rapport d'origine à sa source

- Voir le rapport sur l'Archive d'Internet

Une �étude de 10 000 images a révélé un biais dans ce que le système choisit de mettre en évidence. Twitter a cessé de l'utiliser sur mobile et envisagera de l'abandonner sur le Web.

L'AUTOMNE DERNIER, l'étudiant CANADIEN Colin Madland a rem…

- Afficher le rapport d'origine à sa source

- Voir le rapport sur l'Archive d'Internet

En octobre 2020, nous avons entendu des commentaires de personnes sur Twitter selon lesquels notre [algorithme de recadrage d'image](https: //blog.twitter.com/engineering/en_us/topics/infrastructure/2018/Smart-Auto-Cropping-of-Images.html) …

- Afficher le rapport d'origine à sa source

- Voir le rapport sur l'Archive d'Internet

Twitter a présenté des plans pour un concours de primes de bogues avec une différence. Cette fois-ci, au lieu de payer les chercheurs qui découvrent des problèmes de sécurité, Twitter récompensera ceux qui trouveront des exemples de biais e…

- Afficher le rapport d'origine à sa source

- Voir le rapport sur l'Archive d'Internet

Le premier [programme de primes pour le biais de l'IA] de Twitter (https://www.engadget.com/twitter-bug-bounty-contest-algorithm-bias-image-cropping-185634779.html) est terminé, et il y a déjà des problèmes que l'entreprise souhaite résoudr…

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Incidents similaires

Did our AI mess up? Flag the unrelated incidents