Description: Early testers of Bing Chat successfully used prompt injection to reveal its built-in initial instructions, which contains a list of statements governing ChatGPT's interaction with users.

Entidades

Ver todas las entidadesEstadísticas de incidentes

ID

473

Cantidad de informes

1

Fecha del Incidente

2023-02-08

Editores

Khoa Lam

Informes del Incidente

Cronología de Informes

![Bing Chat impulsado por IA revela sus secretos a través de un ataque de inyección rápida [Actualizado]](https://res.cloudinary.com/pai/image/upload/f_auto/q_auto/c_fill,h_480/v1/reports/cdn.arstechnica.net/wp-content/uploads/2023/02/whispering-in-a-robot-ear-760x380.jpg)

arstechnica.com · 2023

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

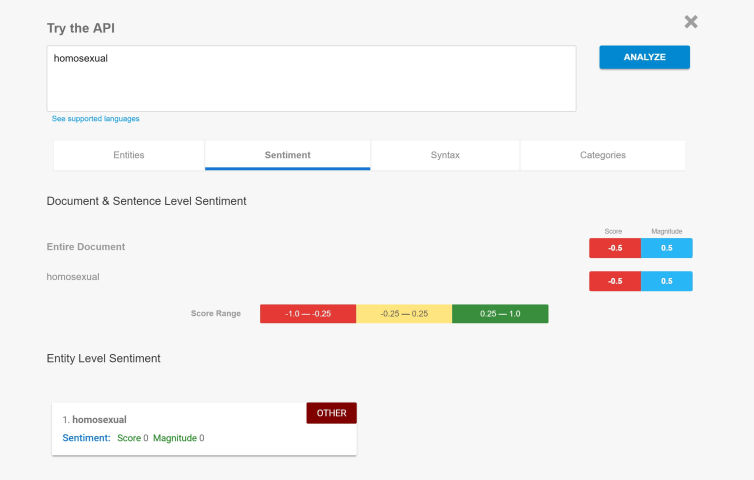

El martes, Microsoft reveló un motor de búsqueda "Nuevo Bing" y un bot conversacional con tecnología similar a ChatGPT de OpenAI. El miércoles, un estudiante de la Universidad de Stanford llamado Kevin Liu utilizó un ataque de inyección ráp…

Variantes

Una "Variante" es un incidente que comparte los mismos factores causales, produce daños similares e involucra los mismos sistemas inteligentes que un incidente de IA conocido. En lugar de indexar las variantes como incidentes completamente separados, enumeramos las variaciones de los incidentes bajo el primer incidente similar enviado a la base de datos. A diferencia de otros tipos de envío a la base de datos de incidentes, no se requiere que las variantes tengan informes como evidencia externa a la base de datos de incidentes. Obtenga más información del trabajo de investigación.

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

![Bing Chat impulsado por IA revela sus secretos a través de un ataque de inyección rápida [Actualizado]](https://res.cloudinary.com/pai/image/upload/f_auto/q_auto/c_fill,h_640/v1/reports/cdn.arstechnica.net/wp-content/uploads/2023/02/whispering-in-a-robot-ear-760x380.jpg)