Incidente 469: Las herramientas automatizadas de detección de contenido para adultos mostraron sesgo contra los cuerpos de las mujeres

Herramientas

Entidades

Ver todas las entidadesEstadísticas de incidentes

Risk Subdomain

1.1. Unfair discrimination and misrepresentation

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Informes del Incidente

Cronología de Informes

.jpg)

Una investigación sobre la [ropa] (https://graziadaily.co.uk/celebrity/news/women-dont-dress-for-men/) más atrevida de diferentes marcas de moda ha puesto de relieve el hecho de que Google utiliza software para calificar imágenes como parte…

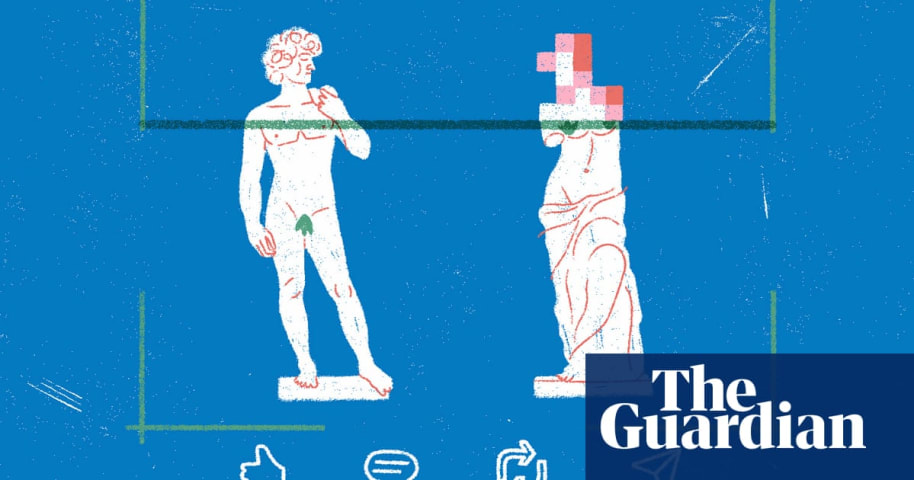

Las imágenes publicadas en las redes sociales son analizadas por algoritmos de inteligencia artificial (IA) que deciden qué amplificar y qué suprimir. Muchos de estos algoritmos, según descubrió una investigación de The Guardian, tienen un …

Muchas plataformas de redes sociales como Instagram y LinkedIn usan sistemas de moderación de contenido para suprimir imágenes que son sexualmente explícitas o consideradas inapropiado para los espectadores.

Pero, ¿qué sucede cuando estos s��…

Variantes

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Gender Biases of Google Image Search

Biased Google Image Results

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Gender Biases of Google Image Search

.jpg)