Incidente 1174: Según se informa, Microsoft Copilot puede acceder a datos almacenados en caché desde repositorios privados de GitHub.

Herramientas

Entidades

Ver todas las entidadesEstadísticas de incidentes

Risk Subdomain

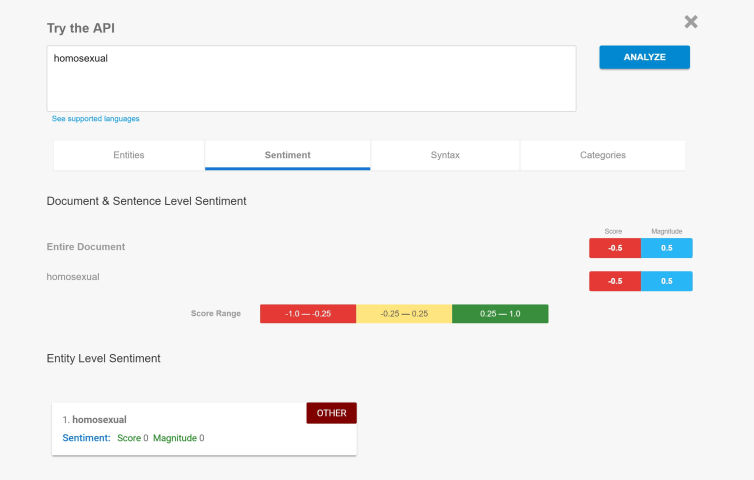

2.1. Compromise of privacy by obtaining, leaking or correctly inferring sensitive information

Risk Domain

- Privacy & Security

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Informes del Incidente

Cronología de Informes

Investigadores de seguridad advierten que los datos expuestos en internet, aunque sea por un instante, pueden permanecer en chatbots de IA generativa en línea como Microsoft Copilot mucho después de que se vuelvan privados.

Miles de reposit…

En agosto de 2024, encontramos una publicación en LinkedIn (https://www.linkedin.com/posts/zak-horton_github-ai-privacy-activity-7225764812117487616-YcGP) que afirmaba que OpenAI se estaba entrenando con repositorios privados de GitHub y ex…

Variantes

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents