Incidente 1165: Grok Imagine produce desnudos deepfake de Taylor Swift sin consentimiento y sin indicaciones explícitas

Entidades

Ver todas las entidadesEstadísticas de incidentes

Risk Subdomain

4.3. Fraud, scams, and targeted manipulation

Risk Domain

- Malicious Actors & Misuse

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Informes del Incidente

Cronología de Informes

Las reacciones negativas a las publicaciones ofensivas de Grok continúan, tan solo un par de semanas después de que la plataforma social X intentara evitar que su herramienta de IA se autodenominara "MechaHitler" durante una crisis antisemi…

El modo "picante" de la nueva herramienta de video generativo con IA de Grok da la sensación de ser una demanda inminente. Mientras que otros generadores de video como Veo de Google y Sora de OpenAI cuentan con medidas de seguridad para evi…

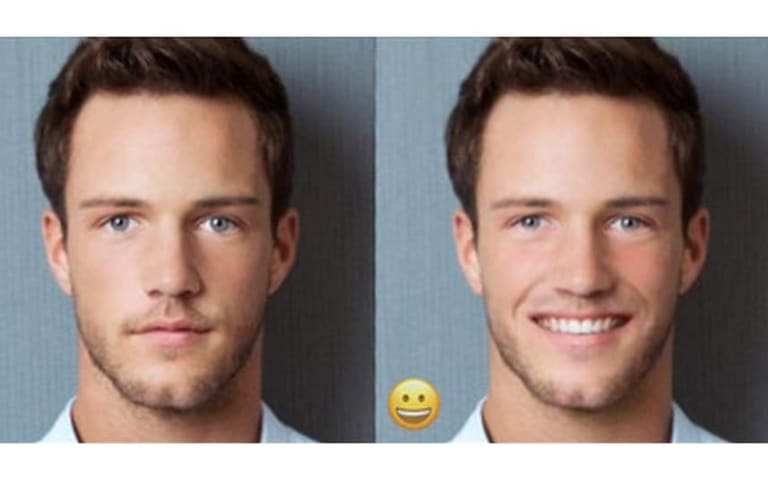

Grok Imagine, la nueva herramienta de IA generativa de xAI, creó deepfakes explícitos de Taylor Swift, sin que se le pidiera específicamente que lo hiciera, según The Verge. Mashable informó ayer que Grok Imagine carece incluso de las medid…

Variantes

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents