Incidents associés

Résumé

Des preuves suggèrent que des informaticiens nord-coréens utilisent la technologie deepfake en temps réel pour infiltrer des organisations via des postes de télétravail, ce qui présente des risques importants en matière de sécurité, de droit et de conformité. Les stratégies de détection présentées dans ce rapport fournissent aux équipes de sécurité et de RH des conseils pratiques pour renforcer leurs processus de recrutement face à cette menace.

Dans notre démonstration, il a fallu un peu plus d'une heure, sans aucune expérience préalable, pour comprendre comment créer un deepfake en temps réel à l'aide d'outils facilement disponibles et de matériel grand public bon marché. Cela permet aux pirates de créer facilement des identités synthétiques convaincantes, leur permettant d'opérer sans être détectés et potentiellement de générer des revenus pour les régimes sanctionnés.

Si les limites de la technologie deepfake actuelle sont encore perceptibles, elles s'atténuent rapidement. Les organisations doivent mettre en place des défenses multicouches en combinant des procédures de vérification renforcées, des contrôles techniques et une surveillance continue tout au long du cycle de vie des employés.

Les clients de Palo Alto Networks sont mieux protégés contre les menaces évoquées dans cet article grâce aux services de lutte contre les menaces internes de l'Unité 42 (https://www.paloaltonetworks.com/resources/datasheets/unit42-insider-threat-services).

Les organisations peuvent contacter l'équipe de réponse aux incidents de l'Unité 42 (https://start.paloaltonetworks.com/contact-unit42.html) pour obtenir une assistance spécifique concernant cette menace et d'autres.

| Sujets connexes de l'Unité 42 | Ingénierie sociale, RPDC, Wagemole | | --- | --- |

Entretiens avec des Nord-Coréens

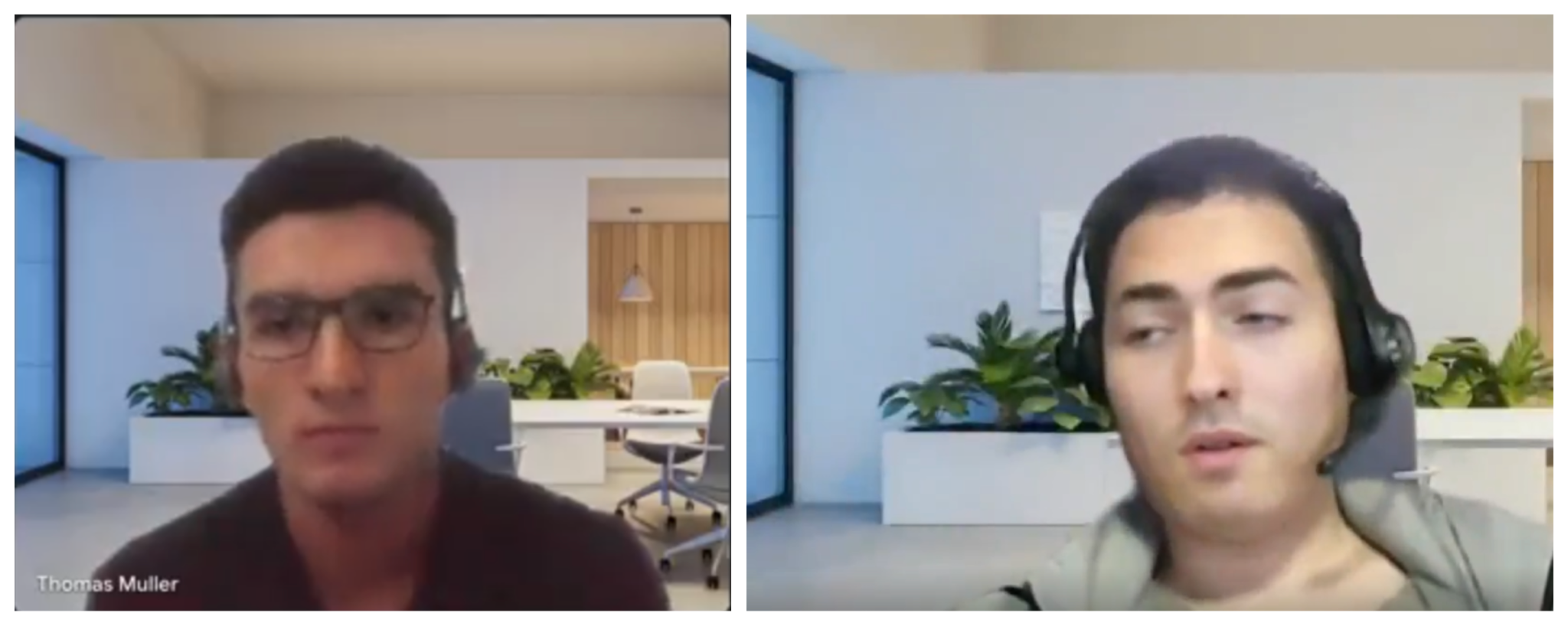

Les spécialistes du recrutement et de la cybersécurité ont récemment signalé une forte augmentation du nombre de candidats utilisant des deepfakes en temps réel lors des entretiens d'embauche. Des enquêteurs ont recensé des cas où les candidats présentaient des flux vidéo synthétiques, utilisant des arrière-plans virtuels identiques pour différents profils, comme le montre la figure 1.

Figure 1. Comparaison côte à côte de deux interviewés deepfakes. Source : Daniel Grek Sanchez Castellanos et Bettina Liporazzi.

La newsletter Pragmatic Engineer a documenté une étude de cas impliquant une entreprise polonaise d'IA ayant rencontré deux candidats deepfake distincts. Les enquêteurs ont suspecté que la même personne utilisait les deux profils, notamment lorsque l'opérateur a montré une confiance nettement accrue lors du deuxième entretien technique après avoir expérimenté le format et les questions de l'entretien.

L'analyse des indicateurs présentés dans le rapport Pragmatic Engineer par l'Unité 42 concorde avec les tactiques, techniques et procédures (TTP) connues des opérations informatiques de la République populaire démocratique de Corée (RPDC) (https://unit42.paloaltonetworks.com/north-korean-it-workers/). Il s'agit d'une évolution logique de leur système établi d'infiltration frauduleuse.

Les acteurs malveillants nord-coréens ont toujours manifesté un intérêt marqué pour les techniques de manipulation d'identité. Dans notre enquête de 2023, nous avons signalé leurs efforts pour créer des identités synthétiques basées sur des informations personnelles compromises, les rendant ainsi plus difficiles à détecter.

Nous avons découvert des preuves supplémentaires en analysant la brèche de Cutout.pro (https://www.bitdefender.com/en-us/blog/hotforsecurity/hacker-leaks-records-of-20-million-users-of-ai-visual-creation-platform-online), un service de manipulation d'images par IA, qui a révélé de nombreuses adresses e-mail probablement liées aux activités d'employés informatiques de la RPDC. La figure 2 illustre cette manipulation d'images sur des portraits avec échange de visages.

Images côte à côte d'une personne avant et après un échange de visages, montrant la transformation d'une apparence naturelle à gauche en une apparence plus soignée grâce à un filtre. ](https://unit42.paloaltonetworks.com/wp-content/uploads/2025/04/word-image-308904-139512-2.png)

Figure 2. Un opérateur nord-coréen expérimente l'échange de visages.

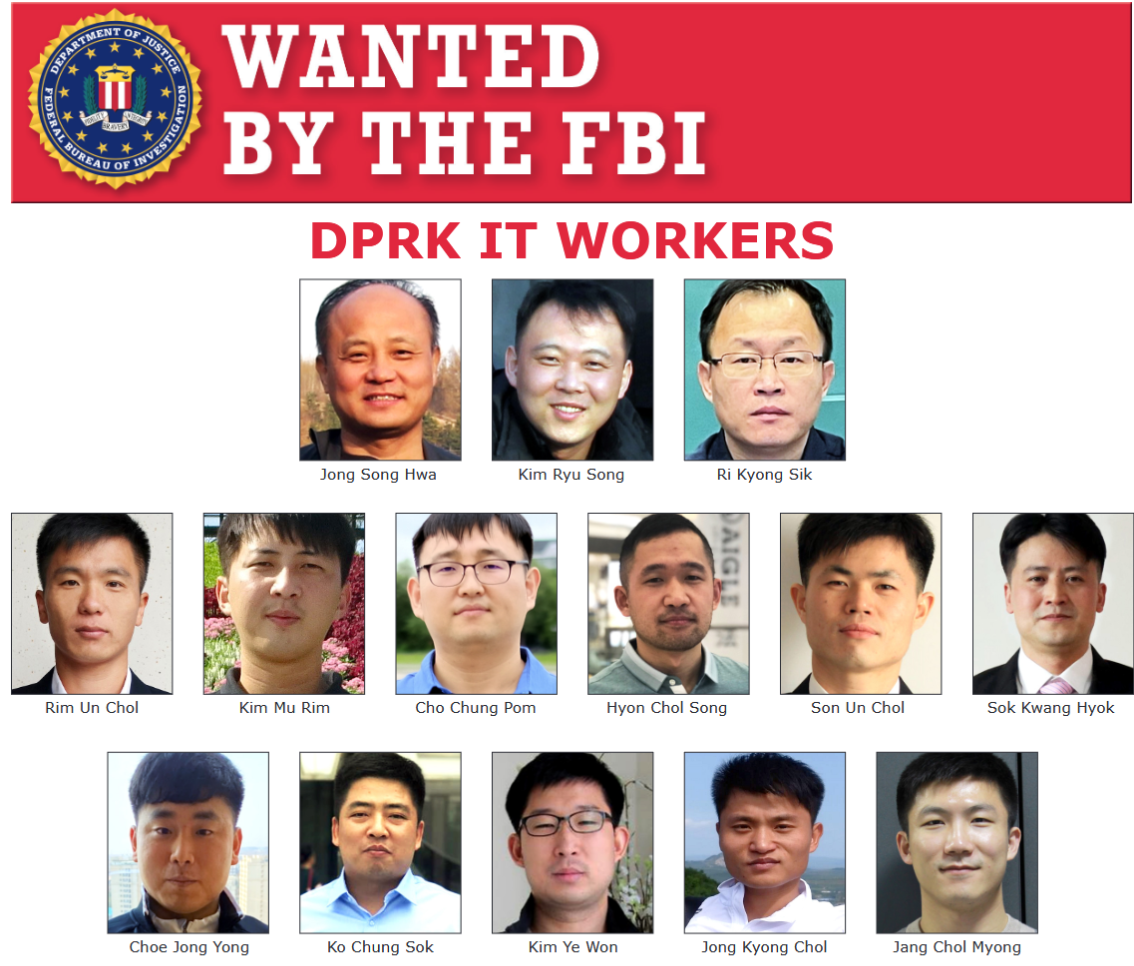

Les informaticiens de la RPDC ont progressivement perfectionné leur méthodologie d'infiltration en mettant en œuvre une technologie de deepfake en temps réel. Cette technologie offre deux avantages opérationnels majeurs. Premièrement, elle permet à un même opérateur de passer plusieurs entretiens pour le même poste en utilisant différents profils synthétiques. Deuxièmement, elle permet aux agents d'éviter d'être identifiés et ajoutés aux bulletins de sécurité et aux avis de recherche, comme celui illustré à la figure 3. Ensemble, elle permet aux informaticiens de la RPDC de bénéficier d'une sécurité opérationnelle renforcée et d'une détectabilité réduite.

Figure 3. Avis de recherche pour des travailleurs informatiques de la RPDC, récupéré le 20 mars 2025.

Nul à acceptable

Un seul chercheur, sans expérience en manipulation d'images, avec des connaissances limitées en deepfake et un ordinateur vieux de cinq ans, a créé une identité synthétique pour des entretiens d'embauche en 70 minutes. La facilité de création démontre à quel point cette technologie est devenue dangereusement accessible aux acteurs malveillants.

À l'aide d'un moteur de recherche IA, d'une connexion internet correcte et d'un processeur graphique GTX 3070 acheté fin 2020, ils ont produit l'échantillon illustré à la figure 4.

Figure 4. Démonstration d'un deepfake en temps réel sur du matériel bon marché et largement disponible.

Ils ont utilisé uniquement des images individuelles générées par thispersonnotexist[.]org, qui autorise l'utilisation de visages générés à des fins personnelles et commerciales, ainsi que des outils gratuits pour les deepfakes. Grâce à ces outils, ils ont généré plusieurs identités, comme le montre la figure 5.

Figure 5. Démonstration de changement d'identité.

Un simple changement de tenue vestimentaire et d'image d'arrière-plan pouvait suffire à faire revenir un nouveau candidat auprès d'un recruteur. En réalité, la partie la plus chronophage de tout ce processus a été la création d'un flux de caméra virtuelle à capturer dans un logiciel de visioconférence.

Avec un peu plus de temps et un processeur graphique beaucoup plus puissant, une version à plus haute résolution du même procédé a produit des résultats plus convaincants, comme le montre la figure 6.

Figure 6. Un deepfake de meilleure qualité utilisant une technique plus gourmande en ressources.

Opportunités de détection

Les systèmes de deepfake en temps réel présentent plusieurs lacunes techniques qui créent des opportunités de détection :

- Problèmes de cohérence temporelle : Les mouvements rapides de la tête ont provoqué des artefacts notables, le système de suivi ayant du mal à maintenir un positionnement précis des points de repère.

- Gestion de l'occlusion : Lorsque la main de l'opérateur passait sur son visage, le système de deepfake ne parvenait pas à reconstruire correctement le visage partiellement masqué.

- Adaptation à l'éclairage : Des changements soudains de conditions d'éclairage ont révélé des incohérences dans le rendu, notamment sur les contours du visage.

- Synchronisation audiovisuelle : De légers décalages entre les mouvements des lèvres et la parole étaient détectables après une observation attentive.

À l'heure actuelle, plusieurs moyens existent pour compliquer la vie des aspirants deepfakes. La méthode la plus efficace semble consister à passer la main sur le visage, ce qui perturbe le suivi des repères faciaux.

Govind Mittal et al. de l'Université de New York suggèrent des stratégies supplémentaires :

- Mouvements rapides de la tête

- Expressions faciales exagérées

- Changements soudains de luminosité

Ces techniques exploitent les faiblesses des systèmes de deepfake en temps réel, provoquant des artefacts visibles qui aident les humains à détecter les faux avec une grande précision.

Nous allons présenter trois autres options à ajouter au répertoire d'un intervieweur dans les figures 7a à c.

Figure 7a. L'« oreille contre l'épaule ».

Figure 7b. Le « nez découvert ».

Figure 7c. Le « ciel ou sol ».

Stratégies d'atténuation

La campagne visant les informaticiens en RPDC exige une étroite collaboration entre les équipes des ressources humaines (RH) et de sécurité de l'information. La combinaison de ces deux éléments offre à l'organisation davantage de possibilités de détection tout au long du cycle de recrutement et d'emploi.

Avertissement : Les stratégies d'atténuation suivantes sont destinées à fournir des informations et des suggestions au lecteur. Elles sont fournies à titre informatif uniquement et ne constituent pas un avis juridique. Avant de mettre en œuvre l'une de ces pratiques, consultez votre propre conseiller juridique afin de vous assurer de leur conformité avec la législation en vigueur.

Pour les équipes RH :

- Demander aux candidats d'activer leur caméra pour les entretiens, y compris les consultations initiales.

- Enregistrer ces entretiens (avec le consentement des candidats) pour une éventuelle analyse forensique.

- Mettre en place un processus complet de vérification d'identité comprenant :

- Vérification de l'authenticité des documents à l'aide d'outils forensiques automatisés qui vérifient les fonctionnalités de sécurité, les indicateurs de falsification et la cohérence des informations entre les documents soumis.

- Vérification d'identité avec détection d'activité intégrée : les candidats doivent présenter leur pièce d'identité physique tout en effectuant des actions spécifiques en temps réel.

- Correspondance entre les documents d'identité et la personne interrogée, garantissant ainsi la correspondance entre la personne interrogée et sa prétendue identité.

- Former les recruteurs et les équipes techniques chargées des entretiens à l'identification de schémas suspects dans les entretiens vidéo, tels que les mouvements oculaires anormaux, les incohérences d'éclairage et les problèmes de synchronisation audiovisuelle.

- Familiariser les recruteurs avec les mouvements difficiles à exécuter pour les logiciels de deepfake (par exemple, se tourner de profil, approcher le visage ou bouger rapidement la tête).

Pour les équipes de sécurité :

- Sécuriser le processus de recrutement en enregistrant les adresses IP des candidatures et en vérifiant qu'elles ne proviennent pas d'infrastructures anonymisées ou de zones géographiques suspectes.

- Enrichir les numéros de téléphone fournis pour vérification. s'il s'agit d'opérateurs de voix sur IP (VoIP), notamment ceux généralement associés à la dissimulation d'identité.

- Maintenir des accords de partage d'informations avec des entreprises partenaires et participer aux centres d'analyse et de partage d'informations (ISAC) concernés afin de se tenir au courant des dernières techniques d'identité synthétique.

- Identifier et bloquer les applications logicielles permettant l'installation de webcams virtuelles (https://democreator.wondershare.com/virtual-camera/virtual-camera-software.html) sur les appareils gérés par l'entreprise lorsqu'il n'existe aucune justification commerciale légitime à leur utilisation.

Indicateurs supplémentaires :

- Surveiller les schémas d’accès réseau anormaux après l’embauche, notamment les connexions à des services d’anonymisation ou les transferts de données non autorisés.

- Déployer des méthodes d’authentification multifacteur exigeant la possession physique des appareils, rendant l’usurpation d’identité plus difficile.

Considérations relatives à la politique organisationnelle :

- Élaborer des protocoles clairs pour le traitement des cas suspects d’identité synthétique, incluant des procédures d’escalade et des méthodes de conservation des preuves.

- Créer un programme de sensibilisation à la sécurité sensibilisant tous les employés impliqués dans le recrutement aux signaux d’alerte liés à l’identité synthétique.

- Mettre en place des contrôles techniques limitant l’accès des nouveaux employés jusqu’à l’atteinte de nouvelles étapes de vérification.

- Documenter les échecs de vérification et partager les indicateurs techniques appropriés avec les partenaires du secteur et les agences gouvernementales concernées.

En mettant en œuvre ces stratégies de détection et d’atténuation multicouches, les organisations peuvent réduire considérablement le risque d’infiltration d’identité synthétique tout en maintenant un processus de recrutement efficace pour les candidats légitimes.

Conclusion

La menace d’identité synthétique, représentée par les activités informatiques des employés nord-coréens, représente un défi en constante évolution pour les organisations du monde entier. Nos recherches démontrent l'accessibilité alarmante de la création d'identités synthétiques, avec des barrières techniques de plus en plus nombreuses à mesure que les visages générés par l'IA, les outils de falsification de documents et les technologies de manipulation vocale/vidéo en temps réel deviennent plus sophistiqués et facilement accessibles.

Avec l'évolution constante des technologies d'identité synthétique, les organisations doivent mettre en œuvre des stratégies de défense multicouches combinant :

- Des procédures de vérification renforcées

- Des contre-mesures assistées par l'IA pour la détection des deepfakes

- Une vérification continue tout au long de l'emploi

Cette approche améliore considérablement la capacité d'une organisation à détecter et à atténuer non seulement les employés informatiques nord-coréens, mais aussi diverses menaces similaires.

Aucune méthode de détection ne garantit à elle seule une protection contre les menaces d'identité synthétique, mais une stratégie de défense multicouche améliore considérablement la capacité de votre organisation à identifier et à atténuer ces risques. En combinant les meilleures pratiques RH avec les contrôles de sécurité, vous pouvez maintenir un processus de recrutement efficace tout en vous protégeant contre les tactiques sophistiquées employées par les employés informatiques nord-coréens et les acteurs malveillants similaires.

Les clients de Palo Alto Networks peuvent mieux se protéger contre les menaces évoquées ci-dessus grâce à l'Unité 42 Services de lutte contre les menaces internes pour améliorer globalement la détection et la correction.

Si vous pensez avoir été compromis ou si vous avez une question urgente, contactez l'équipe de réponse aux incidents de l'Unité 42 (https://start.paloaltonetworks.com/contact-unit42.html) ou appelez :

- Amérique du Nord : Numéro gratuit : +1 (866) 486-4842 (866.4.UNIT42)

- Royaume-Uni : +44.20.3743.3660

- Europe et Moyen-Orient : +31.20.299.3130

- Asie : +65.6983.8730

- Japon : +81.50.1790.0200

- Australie : +61.2.4062.7950

- Inde : 00080005045107

Palo Alto Networks a partagé ces conclusions avec les membres de la Cyber Threat Alliance (CTA). Les membres de la CTA utilisent ces renseignements pour déployer rapidement des protections auprès de leurs clients et perturber systématiquement les cybercriminels. En savoir plus sur la Cyber Threat Alliance.

Ressources supplémentaires

- Un faux informaticien nord-coréen lié à une attaque de phishing sur l'application de visioconférence BeaverTail - Unité 42, Palo Alto Networks

- Des entreprises mondiales paient des Nord-Coréens à leur insu : voici comment les attraper - Unité 42, Palo Alto Networks

- Piratage d'employeurs et recherche d'emploi : deux campagnes liées à l'emploi portent la marque des acteurs malveillants de la RPDC - Unité 42, Palo Alto Networks

- Interview contagieuse : Des acteurs malveillants de la RPDC incitent les chercheurs d’emploi du secteur technologique à installer de nouvelles variantes des logiciels malveillants BeaverTail et InvisibleFerret - Unité 42, Palo Alto Networks

- Gotcha : Détection de deepfakes vidéo en temps réel par challenge-réponse - Govind Mittal, Chinmay Hegde, Nasir Memon

- Des falsificateurs d’IA démasqués lors d’un recrutement de développeurs technologiques : post-mortem - Gergely Orosz, The Pragmatic Engineer

- [Voici ce qui se passe dans Une interview deepfake - Billy Hurley, IT Brew

- La dynamique émergente des campagnes d'escroquerie deepfake sur le Web - Unité 42