Incidents associés

Loading...

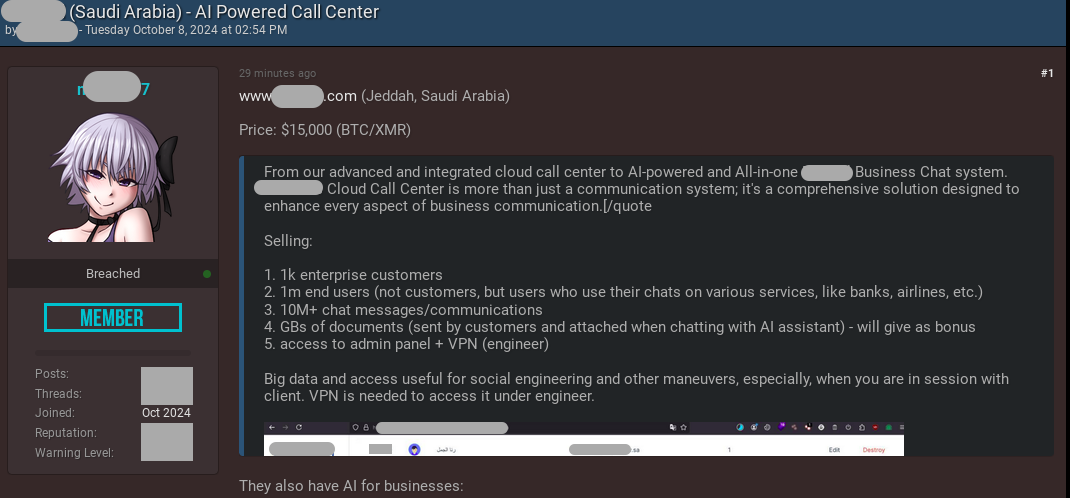

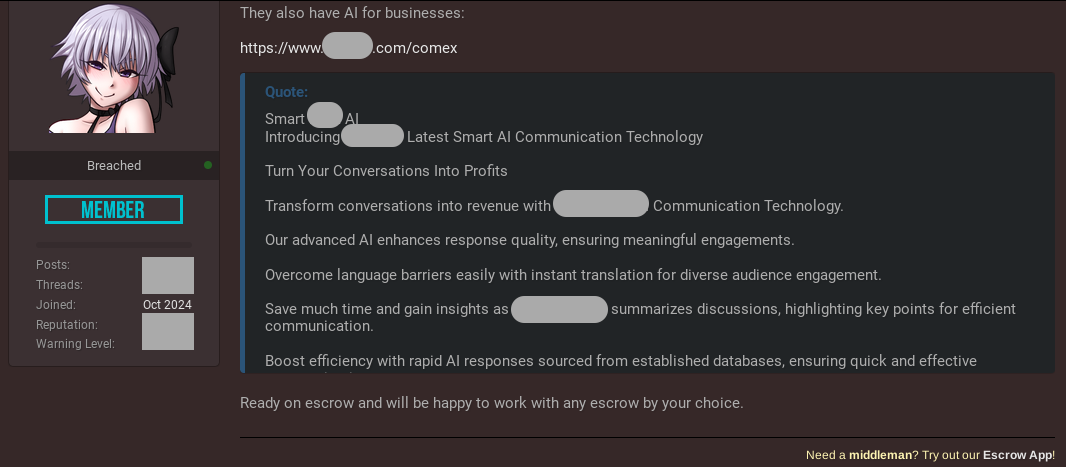

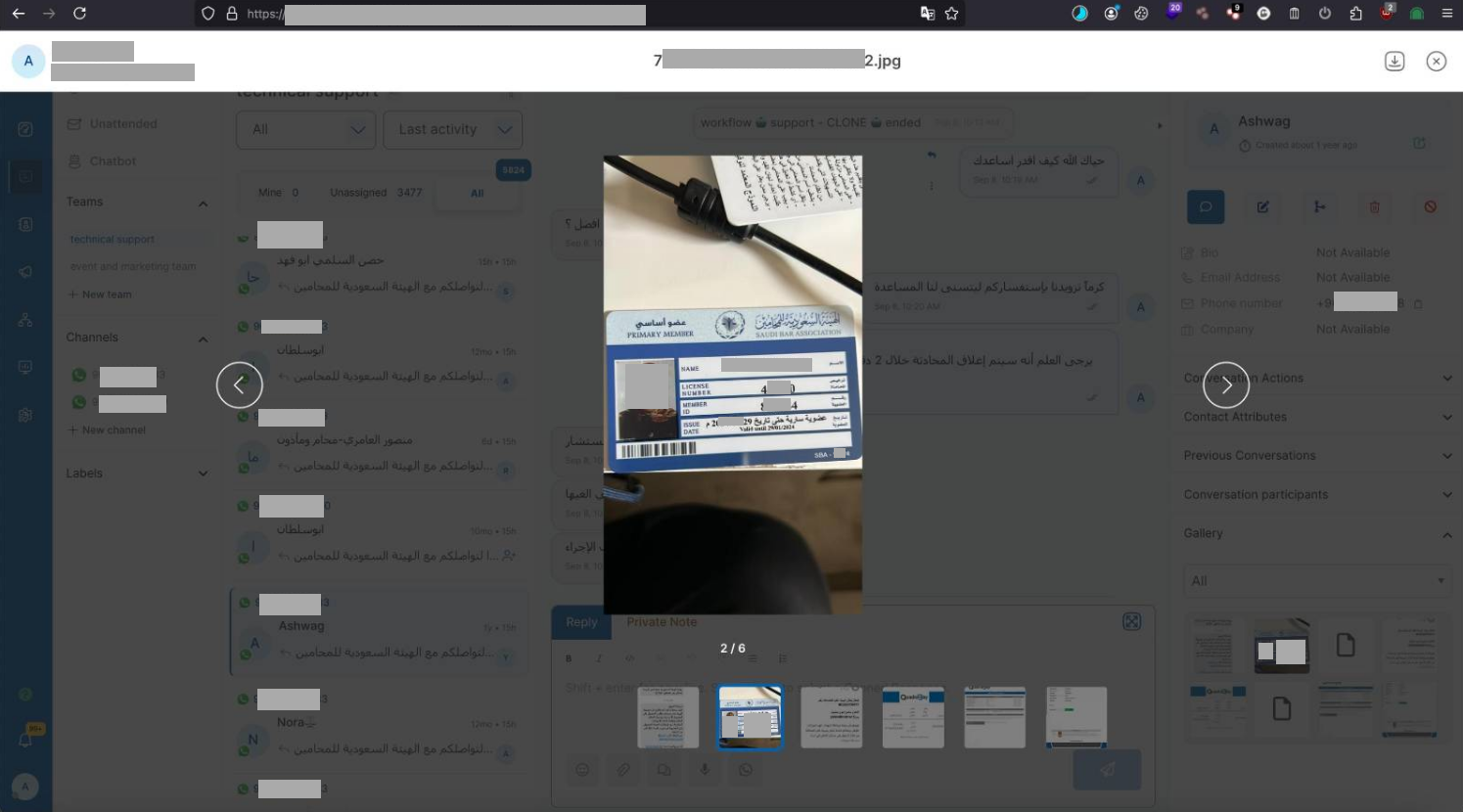

L'acteur malveillant a obtenu un accès non autorisé au tableau de bord de gestion de la plateforme, qui contient plus de 10 210 800 conversations entre des consommateurs, des opérateurs et des agents d'IA (bots). Les données volées pourraient être utilisées pour orchestrer des activités frauduleuses avancées et des campagnes d'ingénierie sociale, ainsi que d'autres tactiques cybercriminelles utilisant l'IA. L'incident a été détecté en temps opportun et atténué avec succès en alertant la partie concernée et en collaborant avec les organismes chargés de l'application de la loi. La conséquence malheureuse est que des acteurs malveillants ont volé une quantité massive d'informations, créant des risques pour la vie privée des consommateurs. Sur la base des renseignements humains disponibles (HUMINT), Resecurity a acquis des artefacts supplémentaires liés à l'incident auprès de l'acteur :

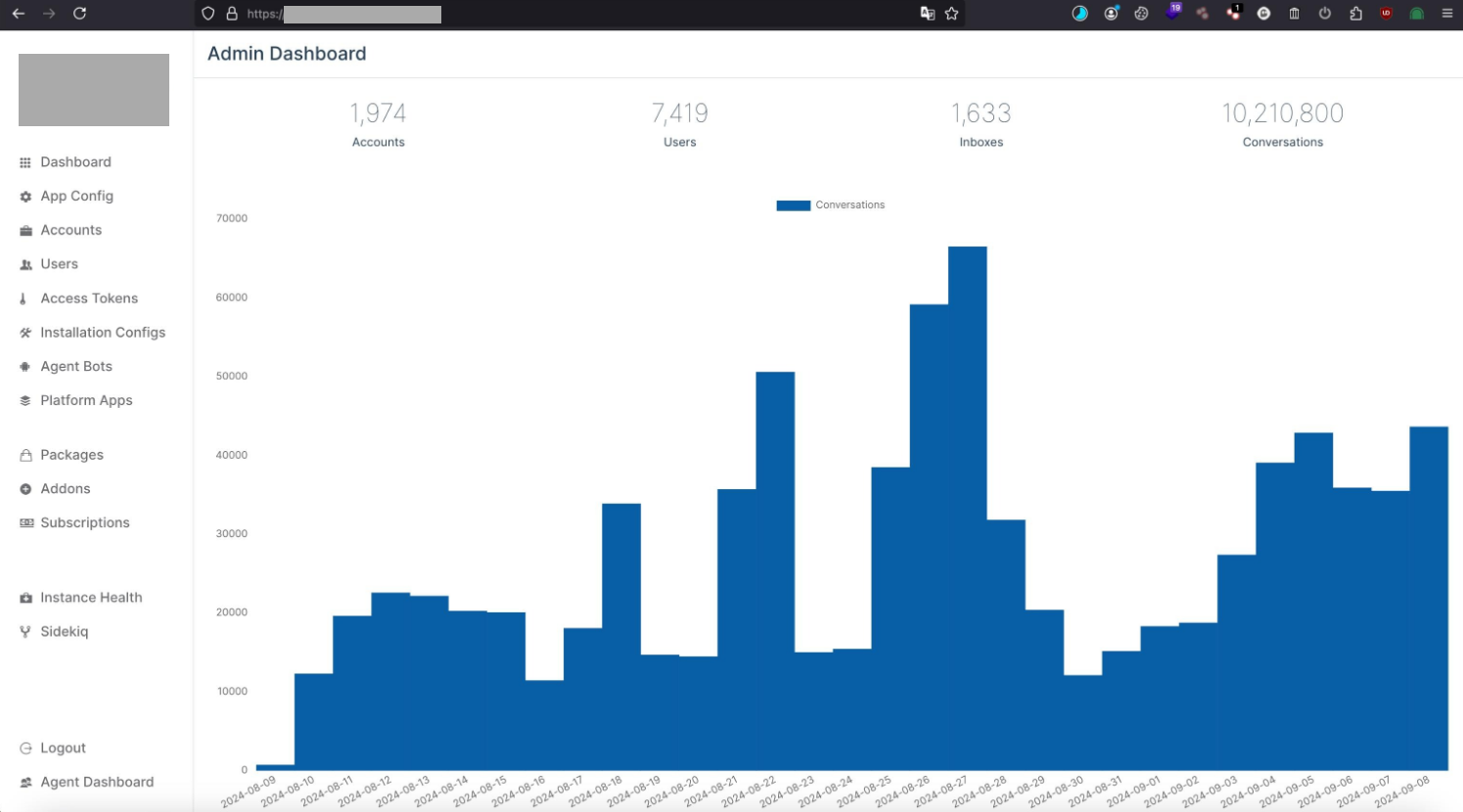

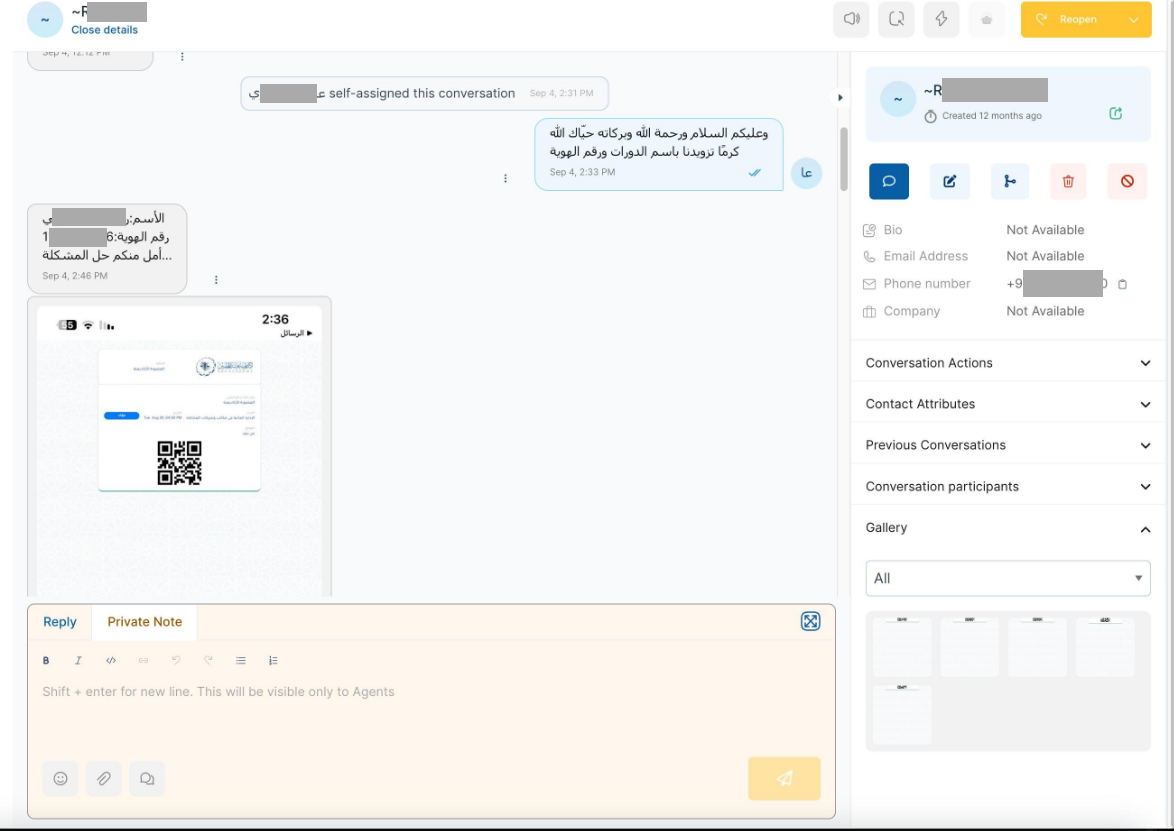

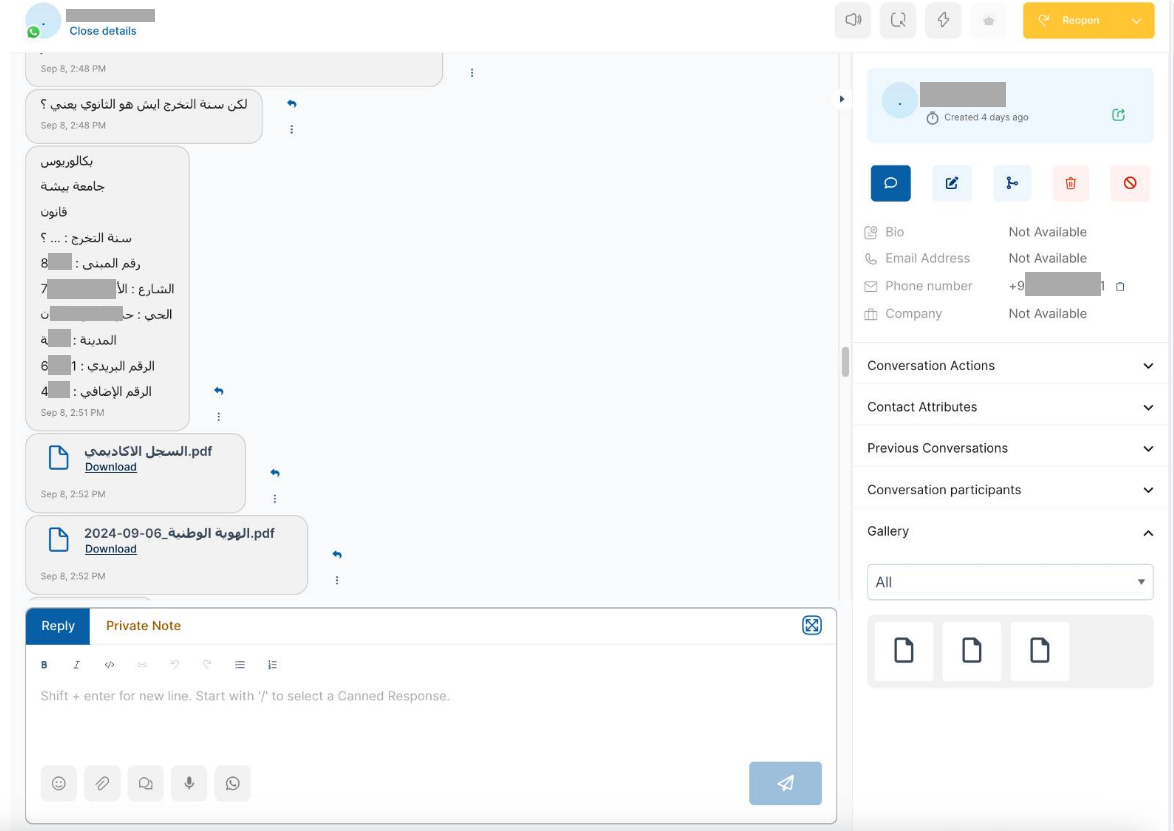

L'acteur malveillant a obtenu un accès non autorisé au tableau de bord de gestion de la plateforme, qui contient plus de 10 210 800 conversations entre des consommateurs, des opérateurs et des agents d'IA (bots). Les données volées pourraient être utilisées pour orchestrer des activités frauduleuses avancées et des campagnes d'ingénierie sociale, ainsi que d'autres tactiques cybercriminelles utilisant l'IA. L'incident a été détecté en temps opportun et atténué avec succès en alertant la partie concernée et en collaborant avec les organismes chargés de l'application de la loi. La conséquence malheureuse est que des acteurs malveillants ont volé une quantité massive d'informations, créant des risques pour la vie privée des consommateurs. Sur la base des renseignements humains disponibles (HUMINT), Resecurity a acquis des artefacts supplémentaires liés à l'incident auprès de l'acteur :  \ L'un des impacts significatifs de l'activité malveillante identifiée - les communications piratées entre les agents d'IA et les consommateurs ont révélé des informations personnelles identifiables (PII), y compris des documents d'identité nationale et d'autres détails sensibles fournis pour répondre à des demandes spécifiques. L'adversaire pourrait appliquer des techniques d'exploration et d'extraction de données pour acquérir des enregistrements intéressants et les utiliser dans des scénarios de phishing avancés et à d'autres fins de cyberoffensive.

\ L'un des impacts significatifs de l'activité malveillante identifiée - les communications piratées entre les agents d'IA et les consommateurs ont révélé des informations personnelles identifiables (PII), y compris des documents d'identité nationale et d'autres détails sensibles fournis pour répondre à des demandes spécifiques. L'adversaire pourrait appliquer des techniques d'exploration et d'extraction de données pour acquérir des enregistrements intéressants et les utiliser dans des scénarios de phishing avancés et à d'autres fins de cyberoffensive.  ### Confiance dans la plateforme d'IA : précurseur d'une fuite de données À la suite de la compromission, les adversaires pourraient accéder à des sessions clients spécifiques et voler des données et acquérir des connaissances sur le contexte de l'interaction avec l'agent d'IA, ce qui pourrait ultérieurement conduire à un détournement. Ce vecteur peut être particulièrement efficace dans les campagnes frauduleuses et d'ingénierie sociale lorsque l'adversaire se concentre sur l'acquisition d'informations de paiement auprès de la victime en utilisant un prétexte de vérification KYC ou d'assistance technique d'une institution financière ou d'un réseau de paiement spécifique. De nombreuses plateformes d'IA conversationnelles permettent aux utilisateurs de basculer entre un opérateur assisté par l'IA et un humain - le mauvais acteur pourrait intercepter la session et contrôler davantage le dialogue. En exploitant la confiance des utilisateurs, les mauvais acteurs pourraient demander aux victimes de fournir des informations sensibles ou d'organiser certaines actions (par exemple, confirmer un OTP) qui pourraient être utilisées dans des stratagèmes frauduleux. Resecurity prévoit une variété de stratagèmes d'ingénierie sociale qui pourraient être orchestrés en abusant et en accédant à des plateformes d'IA conversationnelles de confiance.

### Confiance dans la plateforme d'IA : précurseur d'une fuite de données À la suite de la compromission, les adversaires pourraient accéder à des sessions clients spécifiques et voler des données et acquérir des connaissances sur le contexte de l'interaction avec l'agent d'IA, ce qui pourrait ultérieurement conduire à un détournement. Ce vecteur peut être particulièrement efficace dans les campagnes frauduleuses et d'ingénierie sociale lorsque l'adversaire se concentre sur l'acquisition d'informations de paiement auprès de la victime en utilisant un prétexte de vérification KYC ou d'assistance technique d'une institution financière ou d'un réseau de paiement spécifique. De nombreuses plateformes d'IA conversationnelles permettent aux utilisateurs de basculer entre un opérateur assisté par l'IA et un humain - le mauvais acteur pourrait intercepter la session et contrôler davantage le dialogue. En exploitant la confiance des utilisateurs, les mauvais acteurs pourraient demander aux victimes de fournir des informations sensibles ou d'organiser certaines actions (par exemple, confirmer un OTP) qui pourraient être utilisées dans des stratagèmes frauduleux. Resecurity prévoit une variété de stratagèmes d'ingénierie sociale qui pourraient être orchestrés en abusant et en accédant à des plateformes d'IA conversationnelles de confiance.  La victime finale (le consommateur) restera complètement inconsciente si un adversaire intercepte la session et continuera d'interagir avec l'agent d'IA, pensant que la session est sécurisée et que la suite de l'action est légitime. L'adversaire peut exploiter la confiance de la victime dans la plateforme d'IA et obtenir des informations sensibles, qui pourraient ensuite être utilisées pour la fraude de paiement et le vol d'identité.

La victime finale (le consommateur) restera complètement inconsciente si un adversaire intercepte la session et continuera d'interagir avec l'agent d'IA, pensant que la session est sécurisée et que la suite de l'action est légitime. L'adversaire peut exploiter la confiance de la victime dans la plateforme d'IA et obtenir des informations sensibles, qui pourraient ensuite être utilisées pour la fraude de paiement et le vol d'identité.  Le problème des informations personnelles identifiables conservées peut être observé dans les communications piratées trouvées par un adversaire potentiel dans les données disponibles de la plateforme d'IA conversationnelle et leurs modèles. Par exemple, selon l'une des études de cas publiées par le Centre australien de cybersécurité de la Direction des signaux australiens (ACSC de l'ASD) en collaboration avec des partenaires internationaux, les systèmes d'IA hébergés par des tiers nécessitent une évaluation complète des risques. En novembre 2023, une équipe de chercheurs a publié les résultats de leurs tentatives d'extraction de données de formation mémorisées à partir de modèles de langage d'IA. L'une des applications expérimentées par les chercheurs était ChatGPT. Français Dans le cas de ChatGPT, les chercheurs ont découvert que le fait d'inciter le modèle à répéter un mot indéfiniment conduisait le modèle à divulguer des données d'entraînement à un rythme bien plus élevé que lorsqu'il se comportait normalement. Les données d'entraînement extraites comprenaient des informations personnelles identifiables (PII). ### Systèmes d'IA hébergés par des tiers : un risque majeur pour la chaîne d'approvisionnement Outre le problème des informations personnelles identifiables (PII) conservées stockées dans les communications entre l'agent d'IA et les utilisateurs finaux, les acteurs malveillants ont également pu cibler les jetons d'accès, que les entreprises pouvaient utiliser pour la mise en œuvre du service avec l'API de services et d'applications externes :

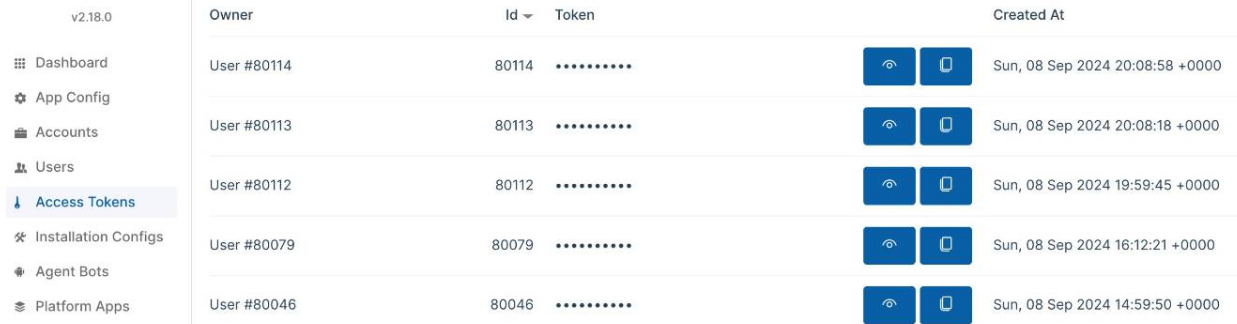

Le problème des informations personnelles identifiables conservées peut être observé dans les communications piratées trouvées par un adversaire potentiel dans les données disponibles de la plateforme d'IA conversationnelle et leurs modèles. Par exemple, selon l'une des études de cas publiées par le Centre australien de cybersécurité de la Direction des signaux australiens (ACSC de l'ASD) en collaboration avec des partenaires internationaux, les systèmes d'IA hébergés par des tiers nécessitent une évaluation complète des risques. En novembre 2023, une équipe de chercheurs a publié les résultats de leurs tentatives d'extraction de données de formation mémorisées à partir de modèles de langage d'IA. L'une des applications expérimentées par les chercheurs était ChatGPT. Français Dans le cas de ChatGPT, les chercheurs ont découvert que le fait d'inciter le modèle à répéter un mot indéfiniment conduisait le modèle à divulguer des données d'entraînement à un rythme bien plus élevé que lorsqu'il se comportait normalement. Les données d'entraînement extraites comprenaient des informations personnelles identifiables (PII). ### Systèmes d'IA hébergés par des tiers : un risque majeur pour la chaîne d'approvisionnement Outre le problème des informations personnelles identifiables (PII) conservées stockées dans les communications entre l'agent d'IA et les utilisateurs finaux, les acteurs malveillants ont également pu cibler les jetons d'accès, que les entreprises pouvaient utiliser pour la mise en œuvre du service avec l'API de services et d'applications externes :  La manipulation des jetons peut conduire à l'injection de données malveillantes dans les canaux d'intégration pris en charge et avoir un impact négatif sur les consommateurs finaux des plateformes conversationnelles d'IA. Français Les résultats des agents d'IA pourraient être intégrés à diverses plateformes, et des bots pourraient être ajoutés à d'autres applications comme Discord, WhatsApp, Slack et Zapier. En raison de la pénétration importante des systèmes d'IA externes dans l'infrastructure de l'entreprise et du traitement de volumes massifs de données, leur mise en œuvre sans évaluation des risques appropriée doit être considérée comme un risque émergent de cybersécurité de la chaîne d'approvisionnement informatique. Selon Gartner, les outils d'IA tiers présentent des risques pour la confidentialité des données. Lorsque votre organisation intègre des modèles et des outils d'IA de fournisseurs tiers, vous absorbez également les grands ensembles de données utilisés pour former ces modèles d'IA. Vos utilisateurs pourraient accéder à des données confidentielles dans les modèles d'IA d'autres personnes, ce qui pourrait créer des conséquences réglementaires, commerciales et réputationnelles pour votre organisation. ### Spectre d'attaques contre les systèmes compatibles avec l'IA Le spectre des tactiques et techniques adverses contre les systèmes compatibles avec l'IA sur la base d'observations d'attaques réelles est défini dans la Matrice MITRE ATLAS. Il fournit un cadre pour identifier et traiter les vulnérabilités des systèmes d’IA, ce qui peut aider à prévenir les attaques et à protéger les données sensibles, et permet aux chercheurs de naviguer dans le paysage des menaces pesant sur les systèmes d’intelligence artificielle.

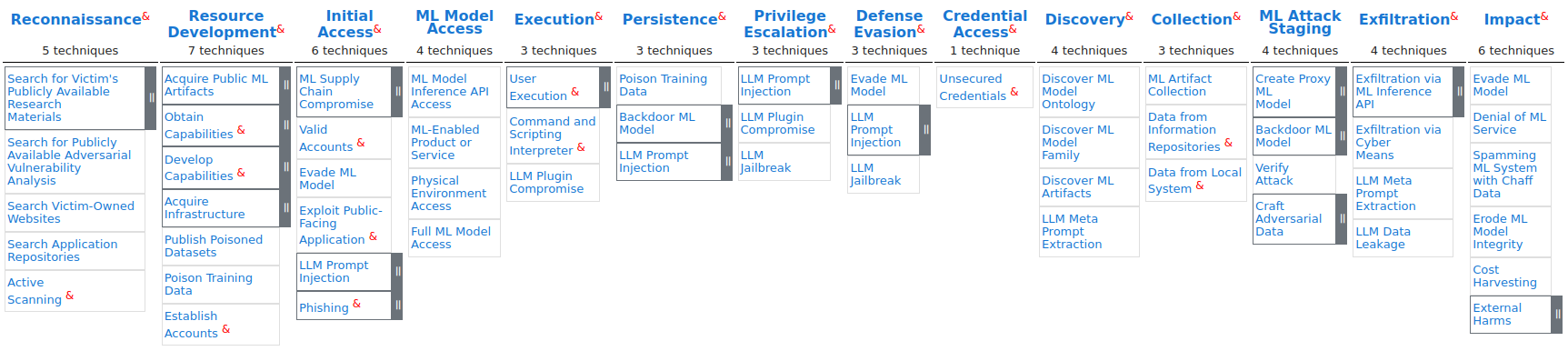

La manipulation des jetons peut conduire à l'injection de données malveillantes dans les canaux d'intégration pris en charge et avoir un impact négatif sur les consommateurs finaux des plateformes conversationnelles d'IA. Français Les résultats des agents d'IA pourraient être intégrés à diverses plateformes, et des bots pourraient être ajoutés à d'autres applications comme Discord, WhatsApp, Slack et Zapier. En raison de la pénétration importante des systèmes d'IA externes dans l'infrastructure de l'entreprise et du traitement de volumes massifs de données, leur mise en œuvre sans évaluation des risques appropriée doit être considérée comme un risque émergent de cybersécurité de la chaîne d'approvisionnement informatique. Selon Gartner, les outils d'IA tiers présentent des risques pour la confidentialité des données. Lorsque votre organisation intègre des modèles et des outils d'IA de fournisseurs tiers, vous absorbez également les grands ensembles de données utilisés pour former ces modèles d'IA. Vos utilisateurs pourraient accéder à des données confidentielles dans les modèles d'IA d'autres personnes, ce qui pourrait créer des conséquences réglementaires, commerciales et réputationnelles pour votre organisation. ### Spectre d'attaques contre les systèmes compatibles avec l'IA Le spectre des tactiques et techniques adverses contre les systèmes compatibles avec l'IA sur la base d'observations d'attaques réelles est défini dans la Matrice MITRE ATLAS. Il fournit un cadre pour identifier et traiter les vulnérabilités des systèmes d’IA, ce qui peut aider à prévenir les attaques et à protéger les données sensibles, et permet aux chercheurs de naviguer dans le paysage des menaces pesant sur les systèmes d’intelligence artificielle.  À l'aide de la matrice MITRE ATLAS, Resecurity a mappé l'activité malveillante observée aux principaux TTP : - AML.T0012\ Comptes valides - AML.T0049\ Exploiter une application publique - AML.T0052\ Phishing - AML.T0055\ Informations d'identification non sécurisées - AML.T0007\ Découverte d'artefacts ML - AML.T0035\ Collecte d'artefacts ML - AML.T0043\ Création de données contradictoires - AML.T0025\ Exfiltration via des moyens cybernétiques - AML.T0024\ Exfiltration via l'API d'interface ML - AML.T0048\ Dommages externes (impact financier) ### Mesures d'atténuation Resecurity souligne l'importance d'un programme complet de gestion de la confiance, des risques et de la sécurité de l'IA (TRiSM) pour garantir de manière proactive que les systèmes d'IA sont conformes, équitables, fiables et protègent la confidentialité des données. La loi sur l'IA de l'UE et d'autres cadres réglementaires en Amérique du Nord, en Chine et en Inde établissent déjà des réglementations pour gérer les risques des applications d'IA. Par exemple, les récentes directives de la PDPC sur l'IA à Singapour encouragent déjà les entreprises à être plus transparentes dans la recherche du consentement pour l'utilisation des données personnelles par le biais de divulgations et de notifications. Les entreprises doivent s'assurer que les systèmes d'IA sont dignes de confiance, offrant ainsi aux consommateurs une confiance dans la manière dont leurs données personnelles sont utilisées. Selon les Principes pour des technologies d’IA générative responsables, fiables et respectueuses de la vie privée publiés par le Commissariat à la protection de la vie privée du Canada et d’autres organismes de réglementation du secteur, il est essentiel de mener des évaluations, telles que des évaluations des facteurs relatifs à la vie privée (EFVP), pour identifier et atténuer les impacts potentiels ou connus qu’un système d’IA générative (ou son utilisation proposée, le cas échéant) peut avoir sur la vie privée. Français Selon les meilleures pratiques pour le déploiement de systèmes d'IA sécurisés et résilients publiées par l'Agence de sécurité nationale (NSA), les experts recommandent d'adopter un état d'esprit Zero-Trust (ZT), qui suppose qu'une violation est inévitable ou a déjà eu lieu. Compte tenu de l'activité malveillante observée impliquant la compromission des plateformes d'IA conversationnelles et de leur impact significatif sur la confidentialité des clients, Resecurity peut souligner l'importance des communications sécurisées entre les agents d'IA et les consommateurs finaux. Cela comprend la minimisation de la conservation des informations personnellement identifiables (PII) et l'adoption d'une approche proactive de la cybersécurité de la chaîne d'approvisionnement dans le contexte des solutions d'IA hébergées par des tiers. ### Importance Les plateformes d'IA conversationnelles sont devenues un élément essentiel de la chaîne d'approvisionnement informatique moderne pour les grandes entreprises et les agences gouvernementales. Leur protection nécessitera un équilibre entre les mesures de cybersécurité traditionnelles propres au SaaS (Software-as-a-Service) et celles spécialisées et adaptées aux spécificités de l'IA. À un moment donné, les plateformes d'IA conversationnelles commenceront à remplacer les canaux de communication traditionnels. Au lieu de la messagerie électronique « à l'ancienne », ces plateformes permettent une interaction via des agents d'IA qui fournissent des réponses rapides et fournissent une navigation à plusieurs niveaux entre les services d'intérêt en temps quasi réel. L'évolution de la technologie a également conduit à des ajustements de tactiques de la part des adversaires cherchant à exploiter les dernières tendances et dynamiques du marché mondial des TIC à leur propre avantage. Resecurity a détecté un intérêt notable de la part de la communauté des cybercriminels et des acteurs étatiques pour les plateformes d'IA conversationnelles - en raison d'un nombre considérable de consommateurs et des volumes massifs d'informations traités lors des interactions et des sessions personnalisées prises en charge par l'IA. Les cybercriminels cibleront les plateformes d'IA conversationnelles en raison de l'apparition de nouvelles offres orientées vers le consommateur. Par exemple, cette année, la Chine a lancé le prototype d'un hôpital IA pour présenter une approche innovante des soins de santé, dans laquelle des assistants infirmiers et des médecins virtuels interagiront avec les patients. De telles innovations peuvent créer des risques importants pour la vie privée des patients à long terme, car l'IA conversationnelle peut transmettre et traiter des informations sensibles sur les données de santé. L'IA conversationnelle révolutionne déjà le secteur bancaire et de la fintech en automatisant le support client, en fournissant des conseils financiers personnalisés et en améliorant l'efficacité transactionnelle, la satisfaction client et l'efficacité opérationnelle. Ces exemples prouvent la diversité des applications de l'IA conversationnelle, allant des assistants virtuels en contact avec le consommateur aux systèmes d'automatisation et d'assistance au niveau de l'entreprise. À mesure que la technologie continue d'évoluer, nous pouvons nous attendre à voir encore plus de cas d'utilisation créatifs de l'IA conversationnelle à l'avenir, et de nouvelles menaces de cybersécurité ciblant ces technologies et les utilisateurs finaux. ### Références - Atténuer les risques émergents et les menaces de sécurité provenant des agents d'IA\ https://securitymea.com/2024/09/10/mitigate-emerging-risks-and-security-threats-from-ai-agents/ - Aborder la confiance, le risque et la sécurité dans les modèles d'IA\ https://www.gartner.com/en/articles/what-it-takes-to-make-ai-safe-and-effective - Principes pour des technologies d'IA génératives responsables, dignes de confiance et respectueuses de la vie privée\ https://www.priv.gc.ca/en/privacy-topics/technology/artificial-intelligence/gd_principles_ai/- S'engager avec l'intelligence artificielle (IA)\ https://media.defense.gov/2024/Jan/23/2003380135/-1/-1/0/CSI-ENGAGING-WITH-ARTIFICIAL-INTELLIGENCE.P...

À l'aide de la matrice MITRE ATLAS, Resecurity a mappé l'activité malveillante observée aux principaux TTP : - AML.T0012\ Comptes valides - AML.T0049\ Exploiter une application publique - AML.T0052\ Phishing - AML.T0055\ Informations d'identification non sécurisées - AML.T0007\ Découverte d'artefacts ML - AML.T0035\ Collecte d'artefacts ML - AML.T0043\ Création de données contradictoires - AML.T0025\ Exfiltration via des moyens cybernétiques - AML.T0024\ Exfiltration via l'API d'interface ML - AML.T0048\ Dommages externes (impact financier) ### Mesures d'atténuation Resecurity souligne l'importance d'un programme complet de gestion de la confiance, des risques et de la sécurité de l'IA (TRiSM) pour garantir de manière proactive que les systèmes d'IA sont conformes, équitables, fiables et protègent la confidentialité des données. La loi sur l'IA de l'UE et d'autres cadres réglementaires en Amérique du Nord, en Chine et en Inde établissent déjà des réglementations pour gérer les risques des applications d'IA. Par exemple, les récentes directives de la PDPC sur l'IA à Singapour encouragent déjà les entreprises à être plus transparentes dans la recherche du consentement pour l'utilisation des données personnelles par le biais de divulgations et de notifications. Les entreprises doivent s'assurer que les systèmes d'IA sont dignes de confiance, offrant ainsi aux consommateurs une confiance dans la manière dont leurs données personnelles sont utilisées. Selon les Principes pour des technologies d’IA générative responsables, fiables et respectueuses de la vie privée publiés par le Commissariat à la protection de la vie privée du Canada et d’autres organismes de réglementation du secteur, il est essentiel de mener des évaluations, telles que des évaluations des facteurs relatifs à la vie privée (EFVP), pour identifier et atténuer les impacts potentiels ou connus qu’un système d’IA générative (ou son utilisation proposée, le cas échéant) peut avoir sur la vie privée. Français Selon les meilleures pratiques pour le déploiement de systèmes d'IA sécurisés et résilients publiées par l'Agence de sécurité nationale (NSA), les experts recommandent d'adopter un état d'esprit Zero-Trust (ZT), qui suppose qu'une violation est inévitable ou a déjà eu lieu. Compte tenu de l'activité malveillante observée impliquant la compromission des plateformes d'IA conversationnelles et de leur impact significatif sur la confidentialité des clients, Resecurity peut souligner l'importance des communications sécurisées entre les agents d'IA et les consommateurs finaux. Cela comprend la minimisation de la conservation des informations personnellement identifiables (PII) et l'adoption d'une approche proactive de la cybersécurité de la chaîne d'approvisionnement dans le contexte des solutions d'IA hébergées par des tiers. ### Importance Les plateformes d'IA conversationnelles sont devenues un élément essentiel de la chaîne d'approvisionnement informatique moderne pour les grandes entreprises et les agences gouvernementales. Leur protection nécessitera un équilibre entre les mesures de cybersécurité traditionnelles propres au SaaS (Software-as-a-Service) et celles spécialisées et adaptées aux spécificités de l'IA. À un moment donné, les plateformes d'IA conversationnelles commenceront à remplacer les canaux de communication traditionnels. Au lieu de la messagerie électronique « à l'ancienne », ces plateformes permettent une interaction via des agents d'IA qui fournissent des réponses rapides et fournissent une navigation à plusieurs niveaux entre les services d'intérêt en temps quasi réel. L'évolution de la technologie a également conduit à des ajustements de tactiques de la part des adversaires cherchant à exploiter les dernières tendances et dynamiques du marché mondial des TIC à leur propre avantage. Resecurity a détecté un intérêt notable de la part de la communauté des cybercriminels et des acteurs étatiques pour les plateformes d'IA conversationnelles - en raison d'un nombre considérable de consommateurs et des volumes massifs d'informations traités lors des interactions et des sessions personnalisées prises en charge par l'IA. Les cybercriminels cibleront les plateformes d'IA conversationnelles en raison de l'apparition de nouvelles offres orientées vers le consommateur. Par exemple, cette année, la Chine a lancé le prototype d'un hôpital IA pour présenter une approche innovante des soins de santé, dans laquelle des assistants infirmiers et des médecins virtuels interagiront avec les patients. De telles innovations peuvent créer des risques importants pour la vie privée des patients à long terme, car l'IA conversationnelle peut transmettre et traiter des informations sensibles sur les données de santé. L'IA conversationnelle révolutionne déjà le secteur bancaire et de la fintech en automatisant le support client, en fournissant des conseils financiers personnalisés et en améliorant l'efficacité transactionnelle, la satisfaction client et l'efficacité opérationnelle. Ces exemples prouvent la diversité des applications de l'IA conversationnelle, allant des assistants virtuels en contact avec le consommateur aux systèmes d'automatisation et d'assistance au niveau de l'entreprise. À mesure que la technologie continue d'évoluer, nous pouvons nous attendre à voir encore plus de cas d'utilisation créatifs de l'IA conversationnelle à l'avenir, et de nouvelles menaces de cybersécurité ciblant ces technologies et les utilisateurs finaux. ### Références - Atténuer les risques émergents et les menaces de sécurité provenant des agents d'IA\ https://securitymea.com/2024/09/10/mitigate-emerging-risks-and-security-threats-from-ai-agents/ - Aborder la confiance, le risque et la sécurité dans les modèles d'IA\ https://www.gartner.com/en/articles/what-it-takes-to-make-ai-safe-and-effective - Principes pour des technologies d'IA génératives responsables, dignes de confiance et respectueuses de la vie privée\ https://www.priv.gc.ca/en/privacy-topics/technology/artificial-intelligence/gd_principles_ai/- S'engager avec l'intelligence artificielle (IA)\ https://media.defense.gov/2024/Jan/23/2003380135/-1/-1/0/CSI-ENGAGING-WITH-ARTIFICIAL-INTELLIGENCE.P...