Incidents associés

Le 3 novembre 2021, Meareg Amare, professeur de chimie à l'Université de Bahir Dar en Éthiopie, a été abattu devant son domicile. Amare, qui était d'origine tigréenne, avait été ciblé dans une série de publications sur Facebook le mois précédent, alléguant qu'il avait volé du matériel à l'université, l'avait vendu et avait utilisé le produit pour acheter une propriété. Dans les commentaires, les internautes ont appelé à sa mort. Le fils d'Amare, le chercheur Abrham Amare, a fait appel à Facebook pour que les messages soient supprimés, mais n'a rien entendu pendant des semaines. Huit jours après le meurtre de son père, Abrham a reçu une réponse de Facebook : l'un des messages ciblant son père, partagé par une page comptant plus de 50 000 abonnés, avait été supprimé.

"Je tiens Facebook personnellement responsable du meurtre de mon père", dit-il.

Aujourd'hui, Abrham, ainsi que son collègue chercheur et conseiller juridique d'Amnesty International, Fisseha Tekle, ont intenté une action en justice contre Meta au Kenya, alléguant que l'entreprise a permis aux discours de haine de se répandre sur la plate-forme, provoquant une violence généralisée. La poursuite demande à l'entreprise de déprioriser le contenu haineux dans l'algorithme de la plate-forme et d'ajouter à son personnel de modération de contenu.

"Facebook ne peut plus être autorisé à donner la priorité au profit au détriment de nos communautés. Comme la radio au Rwanda, Facebook a attisé les flammes de la guerre en Éthiopie », déclare Rosa Curling, directrice de Foxglove, une organisation à but non lucratif basée au Royaume-Uni qui s'attaque aux violations des droits de l'homme par les géants mondiaux de la technologie. L'association soutient la pétition. "L'entreprise dispose d'outils clairs - ajustez ses algorithmes pour rétrograder la haine virale, embaucher plus de personnel local et s'assurer qu'ils sont bien payés et que leur travail est sûr et équitable - pour éviter que cela ne continue."

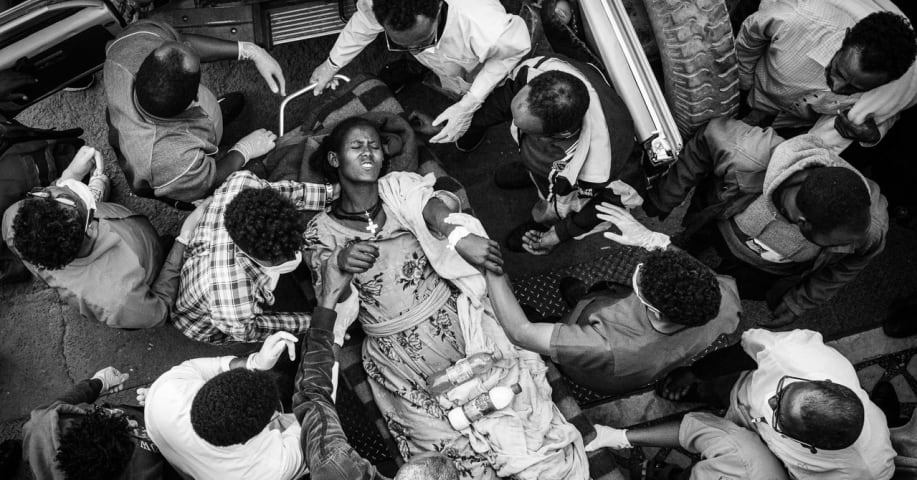

Depuis 2020, l'Éthiopie est plongée dans la guerre civile. Le Premier ministre Abiy Ahmed a répondu aux attaques contre des bases militaires fédérales en envoyant des troupes dans le Tigré, une région du nord du pays qui borde l'Érythrée voisine. Un [rapport] d'avril(https://www.hrw.org/news/2022/04/06/crimes-against-humanity-and-ethnic-cleansing-ethiopias-western-tigray-zone#_Toc100057514) publié par Amnesty International et Human Rights Watch ont trouvé des preuves substantielles de crimes contre l'humanité et d'une campagne de nettoyage ethnique contre les Tigréens de souche par les forces gouvernementales éthiopiennes.

Fisseha Tekle, chercheur principal d'Amnesty International sur l'Éthiopie, a en outre impliqué Facebook dans la propagation de contenus abusifs qui, selon la pétition, ont mis en danger la vie de sa famille. Depuis 2021, Amnesty et Tekle ont suscité de nombreuses réprimandes de la part des partisans de la campagne éthiopienne dans le Tigré, apparemment pour ne pas rejeter la responsabilité des atrocités commises en temps de guerre sur les pieds des séparatistes tigréens. En fait, les recherches de Tekle sur les innombrables crimes contre l'humanité au milieu du conflit ont pointé du doigt les belligérants de tous les côtés, trouvant les séparatistes et le gouvernement fédéral éthiopien mutuellement coupables de meurtres et de viols systématiques de civils. Tekle a déclaré aux journalistes lors d'une conférence de presse en octobre : "Il n'y a pas de partie innocente qui n'ait pas commis de violations des droits de l'homme dans ce conflit".

Dans une déclaration que Foxglove a partagée avec WIRED, Tekle a déclaré avoir été témoin du rôle présumé de Facebook dans la recherche ternie visant à faire la lumière sur les massacres parrainés par le gouvernement, décrivant les plateformes de médias sociaux perpétuant la haine et la désinformation comme corrosives pour le travail des défenseurs des droits humains.

Facebook, qui est utilisé par plus de 6 millions personnes en Éthiopie, a été une voie clé par laquelle les récits ciblant et déshumanisant les Tigréens se sont répandus. Dans un [post] Facebook de juillet 2021 (https://www.facebook.com/112704996810839/posts/573861097361891/) qui reste sur la plateforme, le Premier ministre Ahmed a qualifié les rebelles tigréens de « mauvaises herbes » qui doivent être arrachées. Cependant, les Facebook Papers ont révélé que l'entreprise n'avait pas la capacité de modérer correctement le contenu dans la plupart des plus de 45 langues du pays .

Des documents divulgués partagés par la dénonciatrice de Facebook Frances Haugen montrent que les dirigeants de la société mère Meta sont restés bien informés du potentiel de la plate-forme à exacerber la violence politique et ethnique tout au long de la guerre du Tigré, ce qui a parfois valu à l'Éthiopie une attention particulière de la part de la première équipe de gestion des risques et d'intervention de l'entreprise. Au moins en 2021, selon les documents, le conflit dans le pays avait déclenché suffisamment d'alarmes pour justifier la formation d'une opération semblable à une salle de guerre connue sous le nom d'IPOC, un processus créé par Facebook en 2018 pour répondre rapidement aux "moments de crise" politiques.

Par rapport à ses processus habituels de modération de contenu, l'IPOC est considéré en interne comme un scalpel, déployé non seulement pour anticiper les menaces émergentes, mais aussi pour trier les cas "d'abus écrasants" provoqués par des points chauds politiques. Cela inclut l'utilisation de mesures dites "briser la vitre": des dizaines de "leviers" que les équipes de l'IPOC peuvent déployer lors d'événements exceptionnellement incitatifs pour étouffer les pics de discours de haine sur la plateforme. Aux États-Unis, par exemple, cela comprenait les élections de novembre 2020 et l'attaque qui a suivi contre le Capitole américain.

Lors d'un témoignage devant le Sénat américain l'automne dernier, Haugen a comparé la violence en Éthiopie au génocide de plus de 25 000 musulmans rohingyas au Myanmar, des crimes de guerre pour lesquels Facebook a été internationalement condamné pour son rôle dans l'incitation, par le [Conseil des droits de l'homme des Nations Unies ] (https://www.ohchr.org/sites/default/files/Documents/HRBodies/HRCouncil/FFM-Myanmar/A_HRC_39_64.pdf), entre autres. "Ce que nous avons vu au Myanmar et que nous voyons maintenant en Éthiopie ne sont que les premiers chapitres d'une histoire si terrifiante que personne ne veut en lire la fin", a déclaré Haugen, un ancien chef de produit Facebook, aux législateurs.

Pas plus tard qu'en décembre 2020, Meta manquait de classificateurs de discours de haine pour l'oromo et l'amharique, deux des principales langues parlées en Éthiopie. Pour compenser son personnel insuffisant et en l'absence de classificateurs, l'équipe de Meta a recherché d'autres proxies qui lui permettraient d'identifier les contenus dangereux, une méthode connue sous le nom de [modération basée sur le réseau](https://restofworld.org/2021/why -facebook-continue-d'échouer-en-ethiopie/). Mais l'équipe a eu du mal parce qu'elle a découvert, pour des raisons qui ne sont pas immédiatement claires, que les utilisateurs éthiopiens étaient beaucoup moins susceptibles d'effectuer des actions que Facebook utilisait depuis longtemps pour aider à détecter les discours de haine, qui comprenaient l'apparition de trop de réactions faciales "en colère". Une proposition interne a suggéré d'abandonner complètement ce modèle, en le remplaçant à la place par un autre qui donne plus de poids à d'autres actions "négatives", telles que les utilisateurs qui n'aiment pas les pages ou qui cachent les publications. Il n'est pas clair d'après les documents si la proposition a été acceptée.

Dans sa feuille de route de 2021, Meta a désigné l'Éthiopie comme un pays à risque « grave » de violence, et dans une évaluation de la réponse de l'entreprise aux contenus violents et incitant à la violence, elle a classé sa propre capacité en Éthiopie à 0 sur 3. Pourtant, dans un autre document, un membre du personnel de Meta a reconnu que l'entreprise manquait de "capacité d'examen humain" pour l'Éthiopie à l'approche des élections dans le pays.

Les pétitionnaires ont demandé à la Haute Cour de publier une déclaration désignant Meta comme responsable de la violation d'une liste de droits fondamentaux garantis par la Constitution du Kenya de 2010 : le droit à la liberté d'expression et d'association ; le droit de ne pas être soumis à la violence ou de ne pas voir inutilement rendues publiques des informations sur sa famille ou ses affaires privées ; et le droit à une protection égale devant la loi, entre autres. De plus, les requérants ont demandé au tribunal d'ordonner la création d'un fonds pour les victimes de plus de 2 milliards de dollars, le tribunal lui-même répartissant les fonds au cas par cas. Enfin, ils ont demandé au tribunal d'obliger Facebook à déclarer que ses algorithmes ne feront plus la promotion de contenus incitatifs, haineux et dangereux et à les rétrograder partout où ils se trouvent, en plus de déployer un nouveau protocole d'atténuation de crise "qualitativement équivalent à ceux déployés dans le US », pour le Kenya et tous les autres pays dont le contenu Meta est modéré depuis Nairobi.

"Le Kenya est le centre de modération de contenu pour les publications en Oromo, Tigrinya et Amharique. Ce sont les trois seules langues éthiopiennes, sur les 85 parlées dans le pays, que les modérateurs de contenu actuels de Facebook peuvent même tenter de couvrir », explique Curling. "Il y a actuellement 25 modérateurs de contenu Facebook qui travaillent sur du contenu lié à l'Éthiopie pour un pays de 117 millions d'habitants. Les décisions de ces personnes, forcées de travailler dans des conditions affreuses et injustes, concernant les postes supprimés et ce qui reste en ligne sont prises au Kenya, et ce sont donc les tribunaux kenyans qui doivent déterminer la contestation judiciaire des deux hommes.

La porte-parole de Meta, Sally Aldous, a déclaré à WIRED que les discours de haine et l'incitation à la violence sont contraires aux politiques de l'entreprise. « Notre travail de sécurité et d'intégrité en Éthiopie est guidé par les commentaires des organisations locales de la société civile et des institutions internationales », dit-elle. "Nous employons du personnel possédant des connaissances et une expertise locales, et continuons à développer nos capacités pour détecter les contenus en infraction dans les langues les plus parlées du pays, notamment l'amharique, l'oromo, le somali et le tigrinya."