Incidents associés

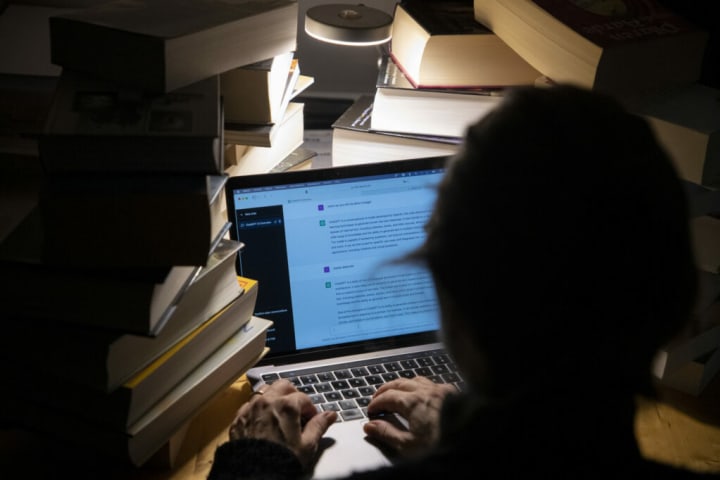

Un jeune Belge s'est récemment suicidé après avoir parlé à un chatbot nommé ELIZA pendant plusieurs semaines, suscitant des appels à une meilleure protection des citoyens et à la nécessité de sensibiliser.

"Sans ces conversations avec le chatbot, mon mari serait toujours là", a déclaré la veuve de l'homme. Elle et son défunt mari étaient tous les deux dans la trentaine, menaient une vie confortable et avaient deux jeunes enfants, selon [La Libre](https://www.lalibre.be/belgique/societe/2023/03/28/sans- ces-conversations-avec-le-chatbot-eliza-mon-mari-serait-toujours-la-LVSLWPC5WRDX7J2RCHNWPDST24/).

Cependant, il y a environ deux ans, les premiers signes de troubles ont commencé à apparaître. L'homme est devenu très éco-anxieux et a trouvé refuge chez ELIZA, le nom donné à un chatbot qui utilise GPT-J, un modèle de langage d'intelligence artificielle open source développé par EleutherAI. Après six semaines d'échanges intensifs, il s'est suicidé.

La semaine dernière, la famille s'est entretenue avec Mathieu Michel, secrétaire d'État à la Digitalisation, chargé de la Simplification administrative, de la Vie privée et de la Réglementation des Bâtiments. Il a souligné que cette affaire met en évidence qu'il est "essentiel de définir clairement les responsabilités".

"Je suis particulièrement frappé par la tragédie de cette famille", a-t-il déclaré mardi, ajoutant que si les "possibilités de ChatGPT sont infinies, les dangers de son utilisation sont également une réalité qui doit être prise en compte". "Ce qui s'est passé est un précédent sérieux qui doit être pris très au sérieux."

Mesures urgentes pour éviter les drames

Pour éviter une telle tragédie dans un avenir immédiat, il a fait valoir qu'il est essentiel d'identifier la nature des responsabilités menant à ce genre d'événement.

"Bien sûr, nous n'avons pas encore appris à vivre avec les algorithmes, mais en aucun cas l'utilisation de n'importe quelle technologie ne doit conduire les éditeurs de contenu à se soustraire à leurs propres responsabilités", a-t-il noté.

OpenAI lui-même a admis que ChatGPT peut produire des réponses nuisibles et biaisées, ajoutant qu'il espère atténuer le problème en recueillant les commentaires des utilisateurs.

À long terme, Michel a noté qu'il est essentiel de sensibiliser à l'impact des algorithmes sur la vie des gens en "en permettant à chacun de comprendre la nature des contenus auxquels les gens sont confrontés en ligne". Ici, il a fait référence aux nouvelles technologies telles que les chatbots, mais aussi aux deep fakes - un type d'intelligence artificielle qui peut créer des images convaincantes, des canulars audio et vidéo - qui peuvent tester et déformer la perception des gens de la r�éalité.

Michel a ajouté que les citoyens doivent également être protégés de manière adéquate contre certaines applications de l'intelligence artificielle qui "présentent un risque important".

L'Union européenne cherche à réglementer l'utilisation de l'intelligence artificielle avec une loi sur l'IA, sur laquelle elle travaille depuis deux dernières années. Michel a mis en place un groupe de travail pour analyser le texte en cours de préparation par l'UE afin de proposer les ajustements nécessaires.