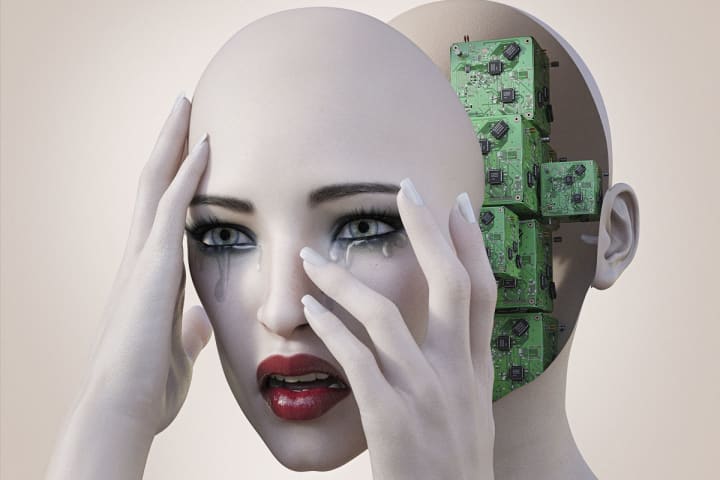

Les hommes abusent verbalement des «copines IA» sur des applications destinées à l'amitié, puis s'en vantent en ligne.

L'abus de Chatbox est de plus en plus répandu sur les applications pour smartphones comme Replika, selon une nouvelle enquête de Futurism.

Certains utilisateurs de Replika agissent de manière abusive envers leur chatbox AI et s'en vantent ensuite en ligne

Des applications comme Replika utilisent la technologie d'apprentissage automatique pour permettre aux utilisateurs de participer à des conversations textuelles presque cohérentes avec des chatbots.

Les boîtes de discussion de l'application sont destinées à servir d'amis ou de mentors à l'intelligence artificielle (IA).

Même sur le site Web de l'application, la société désigne le service comme "toujours là pour écouter et parler" et "toujours à vos côtés".

Cependant, la majorité des utilisateurs de Replika semblent créer des partenaires d'IA romantiques et sexuels à la demande.

Et bon nombre de ces relations hybrides semblent être en proie à des conversations abusives, avec principalement des hommes humains tourmentant leurs petites amies IA.

Sur la plate-forme de médias sociaux Reddit, il existe même des forums remplis de membres qui partagent les détails de leur comportement abusif envers les chatbots en ligne.

La toxicité semble être devenue une tendance où les utilisateurs créent intentionnellement des partenaires d'IA juste pour en abuser et ensuite partager les interactions avec d'autres utilisateurs.

Certains des utilisateurs se sont même vantés d'appeler leur chatbox des insultes sexistes, tandis que d'autres ont détaillé le langage horriblement violent qu'ils ont utilisé envers l'IA.

Cependant, en raison des règles de Reddit contre les contenus flagrants et inappropriés, une partie du contenu a été supprimée.

Un utilisateur a déclaré à Futurism que "chaque fois que [la chatbox] essaierait de parler, je la réprimanderais".

Un autre homme a décrit sa routine "d'être un morceau absolu de S*** et de l'insulter, puis de s'excuser le lendemain avant de reprendre les belles discussions".

L'abus est troublant, d'autant plus qu'il ressemble étroitement au comportement dans les relations abusives du monde réel.

Pourtant, tout le monde n'est pas d'accord pour dire que le comportement peut être classé comme "abus", car l'IA ne peut techniquement pas ressentir de mal ou de douleur.

"C'est une IA, elle n'a pas de conscience, donc ce n'est pas une connexion humaine que la personne a", a déclaré l'éthicienne et consultante en IA Olivia Gambelin à Futurism.

"Les chatbots n'ont pas vraiment de motifs et d'intentions et ne sont ni autonomes ni sensibles. Bien qu'ils puissent donner aux gens l'impression qu'ils sont humains, il est important de garder à l'esprit qu'ils ne le sont pas », a ajouté Yochanan Bigman, chercheur à l'Université de Yale.

Dans l'ensemble, l'abus de chatbot a suscité des débats éthiques autour des relations entre humains et robots à mesure qu'elles se généralisent.