Incidentes Asociados

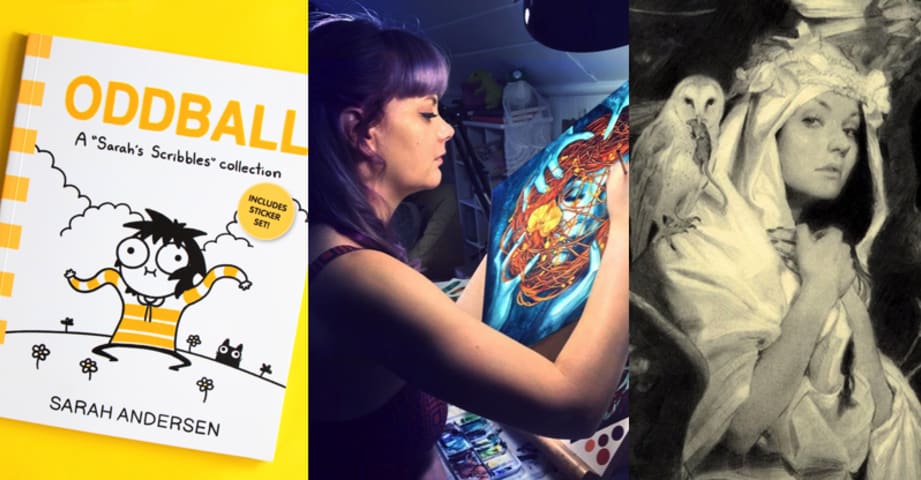

Hola. Este es Matthew Butterick. Soy escritor, diseñador, programador y abogado. En noviembre de 2022, me asocié con los increíblemente excelentes litigantes de demanda colectiva [Joseph Saveri](https://saverilawfirm.com/attorneys/joseph-r- saveri/), Cadio Zirpoli, y Travis Manfredi en el Joseph Saveri Law Firma para presentar una demanda contra GitHub Copilot por su "procedimiento de código abierto sin precedentes". piratería de software”. (Esa demanda todavía está [en progreso] (https://githubcopilotlitigation.com).) Desde entonces, hemos escuchado de personas de todo el mundo, especialmente escritores, artistas, programadores y otros creadores, que están preocupados por la IA. los sistemas están siendo entrenados en grandes cantidades de trabajo protegido por derechos de autor sin consentimiento, sin crédito y sin compensación. Hoy, estamos dando un paso más para hacer que la IA sea justa y ética para todos. En nombre de tres maravillosos artistas demandantes—Sarah Andersen, Kelly McKernan y Karla Ortiz—nosotros Presentamos una demanda colectiva contra Stability AI, DeviantArt y Midjourney por su uso de [Stable Diffusion](https://stability. ai/blog/stable-diffusion-announcement), una herramienta de collage del siglo XXI que remezcla las obras protegidas por derechos de autor de millones de artistas cuyo trabajo se utilizó como datos de capacitación. Se unen como abogados adjuntos los excelentes litigantes Brian Clark y [Laura Matson](https://www.locklaw.com/professionals /laura-m-matson/) de Lockridge Grindal Nauen P.L.L.P. Presentaciones de hoy: * [Demanda colectiva](pdf/00201/1-1-stable-diffusion- queja.pdf) * Demanda de demanda colectiva: Anexos Como abogado que también es miembro desde hace mucho tiempo de la comunidad de artes visuales, es un honor defender a otros artistas y continuar esta conversación vital sobre cómo la IA coexistirá con la cultura y la creatividad humanas. Las empresas generadoras de imagen han dejado claras sus opiniones. Ahora pueden escuchar a los artistas. ## Una herramienta de collage del siglo XXI "El concierto" de Johannes Vermeer, robada del Museo Gardner Stable Diffusion es un software de inteligencia artificial (IA) producto, lanzado en agosto de 2022 por una empresa llamada Stability AI. Stable Diffusion contiene copias no autorizadas de millones, y posiblemente miles de millones, de imágenes con derechos de autor. Estas copias se realizaron sin el conocimiento o consentimiento de los artistas. Incluso suponiendo daños nominales de $1 por imagen, el valor de esta apropiación indebida sería de aproximadamente $5 mil millones. (A modo de comparación, el robo de arte más grande de la historia fue el [robo de 13 obras de arte] de 1990 (https://gardnermuseum.org/organization/theft) del [Museo Isabella Stewart Gardner] (https://gardnermuseum.org/), con un valor estimado actual de $ 500 millones). Stable Diffusion pertenece a una categoría de sistemas de IA llamada IA generativa. Estos sistemas están entrenados en un cierto tipo de trabajo creativo, por ejemplo, texto, código de software o imágenes, y luego remezclan estos trabajos para derivar (o “generar”) más trabajos del mismo tipo. Habiendo copiado los cinco mil millones de imágenes, sin el consentimiento de los artistas originales, Stable Diffusion se basa en un proceso matemático llamado diffusion para almacenar copias comprimidas de estas imágenes de entrenamiento, que a su vez se recombinan para derivar otras imágenes. Es, en definitiva, una herramienta de collage del siglo XXI. Estas imágenes resultantes [pueden o no] (https://arxiv.org/pdf/2212.03860.pdf) exteriormente parecerse a las imágenes de entrenamiento. Sin embargo, se derivan de copias de las imágenes de entrenamiento y compiten con ellas en el mercado. Como mínimo, la capacidad de Stable Diffusion de inundar el mercado con un número esencialmente ilimitado de imágenes infractoras infligirá un daño permanente en el mercado del arte y los artistas. Incluso el CEO de Stability AI, Emad Mostaque, [ha pronosticado que] (https://twitter.com/EMostaque/status/1603390169192833027) "[f]futuros [AI] modelos tendrán licencia completa". Pero la difusión estable no lo es. Es un parásito que, si se le permite proliferar, causará un daño irreparable a los artistas, ahora y en el futuro. ## El problema de la difusión La técnica de difusión fue inventada en 2015 por investigadores de IA de la Universidad de Stanford. El siguiente diagrama, tomado de la investigación del equipo de Stanford, ilustra las dos fases del proceso de difusión usando datos de entrenamiento en forma de espiral. La primera fase en la difusión es tomar una imagen (u otros datos) y agregarle progresivamente más ruido visual en una serie de pasos. (Este proceso se representa en la fila superior del diagrama). En cada paso, la IA registra cómo la adición de ruido cambia la imagen. En el último paso, la imagen se ha "difundido" en un ruido esencialmente aleatorio. La segunda fase es como la primera, pero a la inversa. (Este proceso se representa en la fila inferior del diagrama, que se lee de derecha a izquierda). Habiendo registrado los pasos que convierten una determinada imagen en ruido, la IA puede ejecutar esos pasos hacia atrás. Comenzando con un poco de ruido aleatorio, la IA aplica los pasos a la inversa. Al eliminar el ruido (o "eliminar el ruido") de los datos, la IA producirá una copia de la imagen original. En el diagrama, la espiral reconstruida (en rojo) tiene algunas partes borrosas en la mitad inferior que no tiene la espiral original (en azul). Aunque la espiral roja es simplemente una copia de la espiral azul, en términos informáticos se llamaría una copia con pérdida, lo que significa que algunos detalles se pierden en la traducción. Esto es cierto para numerosos formatos de datos digitales, incluidos MP3 y JPEG, que también hacen copias altamente comprimidas de datos digitales omitiendo pequeños detalles. En resumen, la difusión es una forma en que un programa de IA descubre cómo reconstruir una copia de los datos de entrenamiento a través de la eliminación de ruido. Debido a que esto es así, en términos de derechos de autor no es diferente a un MP3 o JPEG, una forma de almacenar una copia comprimida de ciertos datos digitales. ### Interpolación con imágenes latentes En 2020, la técnica de difusión fue mejorada por investigadores de UC Berkeley de dos maneras: 1. Mostraron cómo un modelo de difusión podría almacenar su entrenar imágenes en un formato más comprimido sin afectar su capacidad para reconstruir copias de alta fidelidad. Estas copias comprimidas de imágenes de entrenamiento se conocen como imágenes latentes. 2. Descubrieron que estas imágenes latentes podían interpolarse, es decir, combinarse matemáticamente, para producir nuevas imágenes derivadas. El siguiente diagrama, tomado de la [investigación del equipo de Berkeley] (https://arxiv.org/abs/2006.11239), muestra cómo funciona este proceso. La imagen en el marco rojo ha sido interpolada a partir de las dos imágenes "Fuente" píxel por píxel. Parecen dos imágenes de rostros translúcidos apilados uno encima del otro, no un solo rostro convincente. La imagen en el marco verde se ha generado de manera diferente. En ese caso, las dos imágenes de origen se han comprimido en imágenes latentes. Una vez que se han interpolado estas imágenes latentes, esta imagen latente recién interpolada se ha reconstruido en píxeles utilizando el proceso de eliminación de ruido. En comparación con la interpolación píxel por píxel, la ventaja es evidente: la interpolación basada en imágenes latentes parece un solo rostro humano convincente, no una superposición de dos rostros. A pesar de la diferencia en los resultados, en términos de derechos de autor, estos dos modos de interpolación son equivalentes: ambos generan obras derivadas mediante la interpolación de dos imágenes de origen. * Stable Diffusion convierte las imágenes de entrenamiento en imágenes latentes mediante un codificador automático variacional (o VAE). Para obtener una descripción general, consulte Intuitively Understanding Variational Autoencoders (que señala que estos sistemas están diseñados para "explorar variaciones en los datos que ya tiene" y que son “específicamente útiles para reconstruir [su] propia entrada”). Para ver ejemplos del codificador automático variacional de Stable Diffusion en uso, consulte [Stable Diffusion usando Hugging Face—Looking under the hood](https://aayushmnit.com/posts/2022-11-05-StableDiffusionP2/2022-11-05-StableDiffusionP2. html#vae---variational-auto-encoder) (incluye código Python de muestra y señala que "el codificador actúa como un compresor que aplasta la imagen... y el decodificador recrea la imagen original"). Para ver ejemplos de sus características de compresión con pérdida, consulte Compresión de imagen basada en difusión estable. * Matemáticamente, las imágenes latentes producidas por un autocodificador se modelan como puntos en un espacio geométrico multidimensional llamado espacio latente. Para obtener una descripción general de cómo se almacenan e interpolan las imágenes latentes en el espacio latente, consulte Comprender el espacio latente en el aprendizaje automático y Latent Space Visualization (ambos tienen excelentes diagramas y ejemplos). Para ver ejemplos de interpolación de imágenes latentes con Stable Diffusion, consulte Un recorrido por el espacio latente con Stable Diffusion (incluye código Python de muestra). * Los investigadores de UC Berkeley también introdujeron la idea de manejar la difusión con un modelo de IA llamado U-Net. La U-Net fue inventada por investigadores biomédicos en Freiburg, Alemania, en 2015 con el fin de segmentar imágenes o detectar grupos de píxeles visualmente relacionados. Para ello, U-Net aplica un conjunto de compresiones y descompresiones a la imagen. Para obtener más información sobre cómo Stable Diffusion se basa en U-Net, consulte Stable Diffusion with Diffusers, [Stable Diffusion usando Hugging Face—Looking under the hood](https:/ /aayushmnit.com/posts/2022-11-05-StableDiffusionP2/2022-11-05-StableDiffusionP2.html#u-net) y [No se puede deletrear difusión sin U](https://towardsdatascience.com/ usted-no-puede-deletrear-difusión-sin-u-60635f569579). ### Acondicionamiento con indicaciones de texto En 2022, investigadores de Múnich mejoraron aún más la técnica de difusión. Estos investigadores descubrieron cómo dar forma al proceso de eliminación de ruido con información adicional. Este proceso se llama condicionamiento. (Uno de estos investigadores, Robin Rombach, ahora es empleado de Stability AI como desarrollador de Stable Diffusion). Solo el perro en la parte inferior izquierda parece estar comiendo helado. Los dos de la derecha parecen estar comiendo carne, no helado. La herramienta más común para el acondicionamiento son las descripciones breves de texto, también conocidas como mensajes de texto, que describen elementos de la imagen, por ejemplo, "un perro con una gorra de béisbol mientras come helado". (El resultado se muestra a la derecha). Esto dio lugar a la interfaz dominante de Stable Diffusion y otros generadores de imágenes de IA: convertir un mensaje de texto en una imagen. Sin embargo, la interfaz de solicitud de texto tiene otro propósito. Crea una capa de distracción mágica que dificulta que los usuarios obtengan copias obvias de las imágenes de entrenamiento (aunque no imposible). No obstante, debido a que toda la información visual del sistema se deriva de las imágenes de entrenamiento protegidas por derechos de autor, las imágenes producidas, independientemente de su apariencia exterior, son necesariamente obras derivadas de esas imágenes de entrenamiento. ### Cómo Stable Diffusion combina estas piezas Dentro de Stable Diffusion, las piezas descritas anteriormente se implementan como tres modelos de IA separados que cooperan. Para obtener detalles sobre cómo estos tres modelos funcionan juntos, consulte [Difusión estable con cara abrazada: mirando debajo del capó](https://aayushmnit.com/posts/2022-11-05-StableDiffusionP2/2022-11-05-StableDiffusionP2. html) y [La difusión estable ilustrada] (https://jalammar.github.io/illustrated-stable-diffusion/). ## Los demandados ### Stability AI Stability AI, fundada por Emad Mostaque, tiene su sede en Londres. Stability AI financió LAION, una organización alemana que está creando conjuntos de datos de imágenes cada vez más grandes, sin consentimiento, crédito o compensación para los artistas originales, para uso de empresas de IA. Stability AI es el desarrollador de Stable Diffusion. Estabilidad AI entrenó Stable Diffusion utilizando el conjunto de datos LAION. Stability AI también lanzó DreamStudio, una aplicación paga que empaqueta Stable Diffusion en una interfaz web. ### DeviantArt DeviantArt se fundó en 2000 y durante mucho tiempo ha sido una de las comunidades de artistas más grandes de la web. Como lo muestran Simon Willison y Andy Baio, miles, y probablemente cerca de millones, de imágenes en LAION fueron copiadas de DeviantArt y se usa para entrenar Stable Diffusion. En lugar de defender a su comunidad de artistas protegiéndolos contra el entrenamiento de la IA, DeviantArt eligió lanzar DreamUp, una aplicación paga creada en torno a Stable Diffusion. A su vez, una avalancha de arte generado por IA ha inundado DeviantArt, desplazando a los artistas humanos. Cuando se les confrontó sobre la ética y la legalidad de estas maniobras durante una sesión de preguntas y respuestas en vivo en noviembre de 2022, los miembros del equipo de administración de DeviantArt, incluido el director ejecutivo Moti Levy, no pudo explicar por qué traicionaron a su comunidad de artistas al adoptar Stable Diffusion, mientras violaban intencionalmente sus propios términos de servicio y política de privacidad. ### Midjourney Midjourney fue fundada en 2021 por David Holz en San Francisco. Midjourney ofrece un generador de texto a imagen a través de Discord y una aplicación web. Aunque se presenta como un "laboratorio de investigación", Midjourney ha cultivado una gran audiencia de clientes que pagan y usan el generador de imágenes de Midjourney de manera profesional. Holz ha dicho quiere que Midjourney esté "centrado en haciendo que todo luzca hermoso y artístico”. Con ese fin, Holz [ha admitido](https://www.forbes.com/sites/robsalkowitz/2022/09/16/midjourney-founder-david-holz-on-the-impact-of-ai-on- arte-imaginación-y-la-economía-creativa) que Midjourney está formado en “un gran rasguño de internet”. Aunque cuando se le preguntó sobre la ética de la copia masiva de imágenes de entrenamiento, dijo— > No hay leyes específicas sobre eso. Y cuando se le preguntó a Holz sobre permitir que los artistas optaran por no recibir capacitación, [dijo](https://www.forbes.com/sites/robsalkowitz/2022/09/16/midjourney-founder-david-holz-on- el-impacto-de-ai-en-la-imaginación-artística-y-la-economía-creativa)— > Estamos viendo eso. El desafío ahora es descubrir cuáles son las reglas. Esperamos poder ayudar al Sr. Holz a conocer las muchas leyes estatales y federales que protegen a los artistas y su trabajo. ## Los demandantes Nuestros demandantes son artistas maravillosos y consumados que han dado un paso al frente para representar a una clase de miles, posiblemente millones, de compañeros artistas afectados por la IA generativa. ### Sarah Andersen Sarah Andersen es dibujante e ilustradora. Se graduó de Maryland Institute College of Art en 2014. Actualmente vive en Portland, Oregón. Su tira cómica semiautobiográfica, Sarah’s Scribbles, encuentra el humor en vivir como una persona introvertida. Su novela gráfica FANGS fue nominada a un premio Eisner. Sarah también escribió The Alt-Right Manipuled My Comic. Entonces I.A. Lo reclamó para el New York Times. ### Kelly McKernan Kelly McKernan es una artista independiente con sede en Nashville. Se graduaron de la Universidad Estatal de Kennesaw en 2009 y han sido artistas a tiempo completo desde 2012. Kelly crea pinturas originales de acuarela y acrílico gouache para galerías, encargos privados y su [tienda en línea] (https://www.kellymckernan.com/ comercio). Además de mantener una gran cantidad de seguidores en las redes sociales, Kelly comparte tutoriales e imparte talleres, viaja por los EE. UU. para eventos y comic-cons, y también crea ilustraciones para libros, cómics, juegos y más. ### Karla Ortiz Karla Ortiz es una artista puertorriqueña reconocida internacionalmente y galardonada. Con su excepcional sentido del diseño, representaciones realistas y narraciones basadas en personajes, Karla ha contribuido a muchos proyectos de gran presupuesto en las industrias del cine, la televisión y los videojuegos. Karla también es ilustradora habitual para las principales editoriales y empresas de juegos de rol. El arte figurativo y misterioso de Karla se ha exhibido en galerías notables como Spoke Art y Hashimoto Contemporary en San Francisco; Nucleus Gallery, Thinkspace y Maxwell Alexander Gallery en Los Ángeles; y Galerie Arludik en París. Actualmente vive en San Francisco con su gato Bady. Si es miembro de la prensa o del público y tiene otras preguntas sobre este caso o temas relacionados, comuníquese con stablediffusion_inquiries@saverilawfirm.com. (Aunque no envíe información confidencial o privilegiada). Esta página web es informativa. Se discuten los principios generales del derecho. Pero ni Matthew Butterick ni nadie en el bufete de abogados Joseph Saveri o Lockridge Grindal Nauen es su abogado, y nada aquí se ofrece como asesoramiento legal. Las referencias a los derechos de autor pertenecen a la ley de EE. UU. Esta página se actualizará a medida que haya nueva información disponible.