Incidente 957: Un supuesto fallo en el algoritmo de Instagram inunda los feeds de Reels de los usuarios con contenido violento y gráfico.

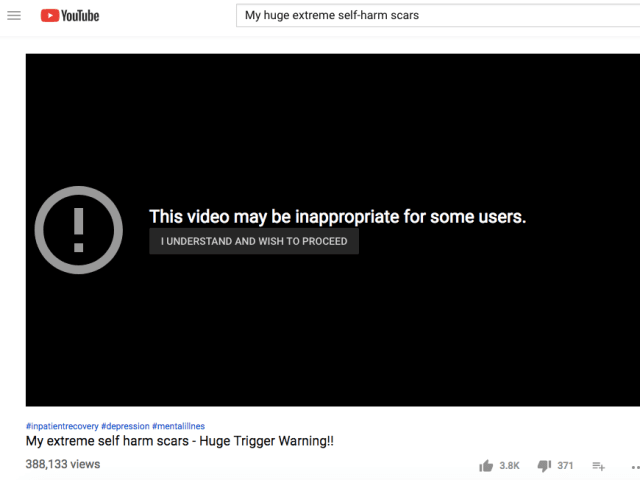

Descripción: Un supuesto fallo del algoritmo de Instagram provocó que los feeds de Reels de los usuarios se vieran inundados de contenido violento y angustiante. Muchos reportaron haber visto muertes, brutalidad extrema y otro material gráfico en rápida sucesión, a menudo sin haber interactuado previamente con contenido similar. La repentina exposición causó angustia psicológica a muchos usuarios, especialmente a menores y personas vulnerables. Meta confirmó que se trató de un fallo de la IA y se disculpó.

Herramientas

Nuevo InformeNueva RespuestaDescubrirVer Historial

El Monitor de Incidentes y Riesgos de IA de la OCDE (AIM) recopila y clasifica automáticamente incidentes y riesgos relacionados con la IA en tiempo real a partir de fuentes de noticias reputadas en todo el mundo.

Entidades

Ver todas las entidadesPresunto: un sistema de IA desarrollado e implementado por Meta , Instagram Reels y Instagram recommendation algorithm, perjudicó a minors , Meta users y Instagram users.

Sistemas de IA presuntamente implicados: Instagram Reels y Instagram recommendation algorithm

Estadísticas de incidentes

Risk Subdomain

A further 23 subdomains create an accessible and understandable classification of hazards and harms associated with AI

1.2. Exposure to toxic content

Risk Domain

The Domain Taxonomy of AI Risks classifies risks into seven AI risk domains: (1) Discrimination & toxicity, (2) Privacy & security, (3) Misinformation, (4) Malicious actors & misuse, (5) Human-computer interaction, (6) Socioeconomic & environmental harms, and (7) AI system safety, failures & limitations.

- Discrimination and Toxicity

Entity

Which, if any, entity is presented as the main cause of the risk

AI

Timing

The stage in the AI lifecycle at which the risk is presented as occurring

Post-deployment

Intent

Whether the risk is presented as occurring as an expected or unexpected outcome from pursuing a goal

Unintentional

Informes del Incidente

Cronología de Informes

Loading...

Meta, de Mark Zuckerberg, se disculpó después de que los usuarios de Instagram fueran sometidos a una avalancha de violencia, sangre, maltrato animal y cadáveres en sus feeds de Reels.

Los usuarios denunciaron las imágenes después de un apa…

Variantes

Una "Variante" es un incidente de IA similar a un caso conocido—tiene los mismos causantes, daños y sistema de IA. En lugar de enumerarlo por separado, lo agrupamos bajo el primer incidente informado. A diferencia de otros incidentes, las variantes no necesitan haber sido informadas fuera de la AIID. Obtenga más información del trabajo de investigación.

¿Has visto algo similar?

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents