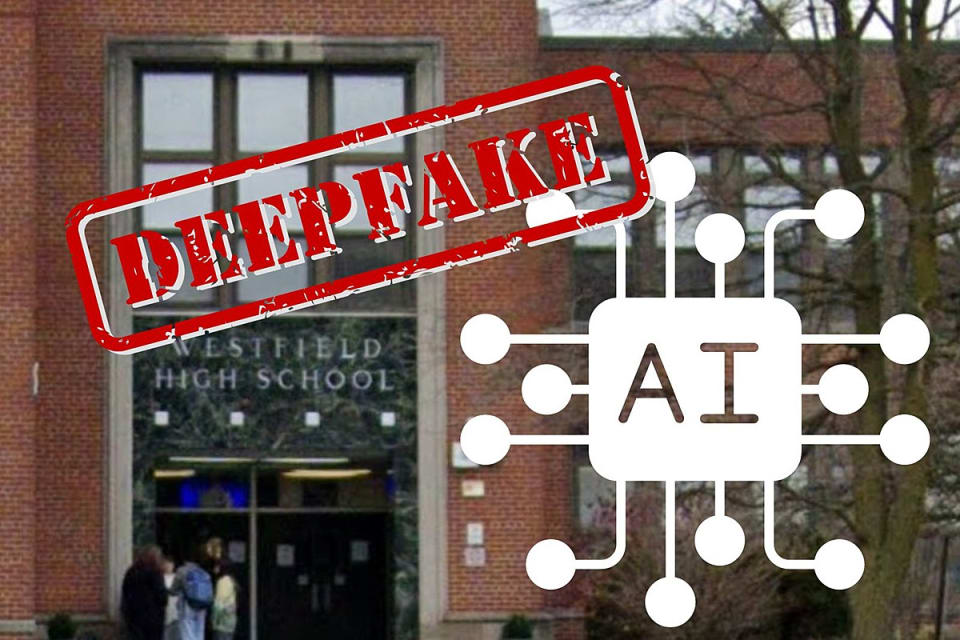

Incidente 597: Estudiantes de la escuela secundaria Westfield en Nueva Jersey fueron blanco de fotos de desnudos falsos.

Herramientas

Entidades

Ver todas las entidadesEstadísticas de incidentes

Risk Subdomain

4.3. Fraud, scams, and targeted manipulation

Risk Domain

- Malicious Actors & Misuse

Entity

Human

Timing

Post-deployment

Intent

Intentional

Informes del Incidente

Cronología de Informes

WESTFIELD, Nueva Jersey --- La directora de Westfield High School, Mary Asfendis, envió una carta a los padres el viernes por la tarde sobre lo que dijo que era "información errónea generalizada" que resultó en "preocupación e inquietud sig…

"Se circularon imágenes pornográficas de IA de su hija de 14 años", me informó el director de WHS [el viernes](https://www.tapinto.net/towns/westfield/sections/education/articles/westfield-high- el director de la escuela se dirige a los pad…

Cuando las niñas de Westfield High School en Nueva Jersey descubrieron que los niños compartían fotos de ellas desnudas en chats grupales, se sorprendieron, y no solo porque era una invasión de la privacidad. Las imágenes no eran reales.

Lo…

WESTFIELD, Nueva Jersey -- Los padres y estudiantes de Westfield High School en Nueva Jersey dicen que los estudiantes usaron una aplicación o un sitio web para crear imágenes pornográficas de sus compañeros de clase generadas por IA.

Los p…

WESTFIELD, N.J. - Los informes indican que los estudiantes varones de Westfield High School utilizaron [Inteligencia artificial](https: //www.fox5ny.com/tag/technology/artificial-intelligence) para producir imágenes explícitas de estudiante…

Según un informe, los compañeros de clase hicieron circular imágenes pornográficas de estudiantes femeninas en una escuela secundaria de Nueva Jersey generadas por IA, lo que provocó el revuelo de los padres y una investigación policial.

Es…

WESTFIELD, Nueva Jersey — Los estudiantes de Westfield High School crearon y distribuyeron imágenes pornográficas falsas de otras alumnas de la escuela, lo que generó preocupación entre algunos padres y llevó a los funcionarios a investigar…

Se está llevando a cabo una investigación después de que unas adolescentes de una escuela secundaria de Nueva Jersey descubrieran que sus compañeros de clase habían utilizado sitios web de inteligencia artificial para crear desnudos falsos …

WESTFIELD, Nueva Jersey --- Los padres, estudiantes y miembros de la comunidad de Westfield exigen acciones después de que se corrió la voz en Westfield High School de que al menos un niño de la escuela había creado y compartido imágenes po…

Este octubre, los chicos de Westfield High School en Nueva Jersey comenzaron a actuar de forma "rara", [informó el Wall Street Journal](https://www.wsj.com/tech/fake-nudes-of-real-students-cause-an -alboroto-en-una-escuela-secundaria-de-nue…

Una escuela secundaria de Nueva Jersey se vio sumida en una crisis después de que estudiantes varones fueron sorprendidos compartiendo desnudos de sus compañeras de clase generados por IA.

Algunos estudiantes varones de la clase de segundo …

NUEVA YORK (1010 WINS/WCBS 880) – Los chicos de la escuela secundaria Westfield de Nueva Jersey compartieron fotos desnudas falsas, generadas por IA, de compañeras de clase en chats grupales durante el verano, confirmó 1010 WINS/WCBS 880.

S…

Westfield High School en Westfield, Nueva Jersey, data de 1864, pero ha sido un elemento fijo en Dorian Road desde 1951. Con casi 2000 estudiantes matriculados en la actualidad, el distrito ha lidiado con todo tipo de problemas a lo largo d…

Las fotografías pornográficas de estudiantes femeninas de una escuela secundaria de Nueva Jersey generadas por IA y distribuidas entre sus compañeros masculinos han provocado indignación entre los padres y funcionarios escolares y provocaro…

Un teléfono, algunas fotos e inteligencia artificial han generado controversia y destrozado la privacidad de varios adolescentes en una escuela secundaria de Nueva Jersey después de enterarse de que Imágenes de ellos desnudos, creadas media…

Los peligros de la tecnología de inteligencia artificial se han hecho evidentes en Westfield después de que circularan imágenes pornográficas falsas de estudiantes en la escuela secundaria local.

Las imágenes se crearon utilizando fotografí…

Los estudiantes de una escuela secundaria de Nueva Jersey están aterrorizados después de enterarse de que uno de sus compañeros de clase supuestamente usó inteligencia artificial para crear imágenes sexualmente explícitas de ellos sin su pe…

Los adolescentes utilizaron inteligencia artificial (IA) para tomar fotografías de desnudos ultrafalsos de sus compañeras de clase en una escuela secundaria de EE. UU.

Ahora se está llevando a cabo una investigación después de que unas adol…

Un incidente de alto perfil en el que estudiantes de secundaria compartieron imágenes pornográficas generadas por inteligencia artificial de [menores de edad](https://washingtonexaminer.com/tag /adolescentes) compañeros de clase ha llamado …

/cloudfront-us-east-1.images.arcpublishing.com/gray/OI5GJYGAMJHGJFZJECCEKJAPT4.png)

WESTFIELD, Nueva Jersey (WCBS) – Algunos estudiantes de secundaria de Nueva Jersey son acusados de compartir fotografías de desnudos de sus compañeros de clase generadas por IA.

El incidente ocurrió durante el verano, pero recientemente se …

Una comunidad escolar en Nueva Jersey se sorprendió cuando imágenes de estudiantes desnudas comenzaron a circular en Westfield High School. Aún más impactante, alguien había creado fotos pornográficas utilizando imágenes de IA. Los estudian…

(NewsNation) — Una [polémica por fotos de desnudos](https://www.newsnationnow.com/us-news/ap-us-news/ap-ai-generated -child-sexual-abuse-images-could-inundar-the-internet-a-watchdog-is-calling-for-action/) tiene una comunidad de Nueva Jerse…

Después de que los desnudos de chicas adolescentes generados por IA comenzaron a circular en una escuela secundaria de Nueva Jersey, ni los padres, ni los funcionarios escolares ni siquiera las autoridades locales han podido descubrir cómo …

El intercambio de imágenes explícitas de estudiantes de secundaria generadas por IA ha provocado un revuelo en un suburbio próspero de la ciudad de Nueva York y ha dejado a los adolescentes, los padres, la escuela y la policía preguntándose…

El escándalo de IA en la escuela secundaria provoca una investigación policial y un llamado a una reforma legal

PUNTOS CLAVE

-

Los desnudos falsos generados por IA en una escuela secundaria de Nueva Jersey desencadenan una investigación pol…

(Fundación Daily Caller News) – Las niñas de Westfield High School en Nueva Jersey se sorprendieron cuando descubrieron que los niños estaban circulando fotos falsas de ellas desnudas, según un informe del jueves de The Wall Street Journal …

Un estudiante de una escuela secundaria de Nueva Jersey pide una legislación federal para abordar [las imágenes pornográficas generadas por IA] (https://www.cnn.com/2023/02/16/tech/nonconsensual-deepfake-porn/index.html) después de que ella…

El porno deepfake está proliferando y una escuela secundaria de Nueva Jersey es uno de los epicentros más recientes.

La policía está [investigando] (https://www.wsj.com/tech/fake-nudes-of-real-students-cause-an-uproar-at-a-new-jersey-high-s…

WESTFIELD, Nueva Jersey — Un grupo de estudiantes de Westfield High School son objeto de una investigación en curso después de que surgieron acusaciones de que utilizaron inteligencia artificial para crear y distribuir imágenes pornográfica…

Los padres y estudiantes de Westfield High en Nueva Jersey están hablando después de que uno o varios estudiantes supuestamente usaron una [IA](https://globalnews.ca/ tag/ai) para crear imágenes de desnudos falsos utilizando los rostros de …

Alessandra Kellermann es consejera de salud mental, especialista en comportamiento y propietaria de Gentle Insight, LLC.

Antes de que perdamos a otro estudiante por suicidio, enfrentemos la crisis de salud mental y los problemas que surjan,…

WESTFIELD, Nueva Jersey — Un estudiante de Westfield High School acusado de usar inteligencia artificial para [hacer imágenes pornográficas falsas] (https://patch.com/new-jersey/westfield/fake-nude-photos-westfield-hs-students-spark- inform…

Una escuela secundaria de Nueva Jersey se vio sacudida por un escándalo después de que, según se informó, estudiantes varones utilizaron inteligencia artificial para crear fotografías falsas de desnudos de estudiantes.

El mes pasado, alguna…

Una adolescente y su madre están hablando después de que un estudiante de secundaria supuestamente usó inteligencia artificial para crear imágenes desnudas de ella y otras niñas, que luego fueron compartidas con un grupo de compañeros de cl…

Los funcionarios escolares de Westfield High School en Westfield, Nueva Jersey, están tratando de descubrir quién estaba detrás de las fotografías "deepfake" destinadas a parecerse a fotografías de estudiantes desnudas. Las imágenes generad…

WESTFIELD, Nueva Jersey (WCBS/CNN/CNN Newsource/WKRC) – Estudiantes de secundaria fueron acusados de hacer circular fotografías explícitas de sus compañeros de clase generadas por IA.

El incidente ocurrió durante el verano en Westfield, Nue…

La semana pasada, un número no revelado de niñas de una escuela secundaria de Nueva Jersey se enteró de que uno o más estudiantes de su escuela habían utilizado una herramienta de inteligencia artificial para generar lo que parecían ser imá…

Francesca Mani, una estudiante de la escuela secundaria Westfield de Nueva Jersey, se presentó junto con su madre, Dorota, para abordar las imágenes pornográficas generadas por inteligencia artificial que, según ella, fueron manipuladas y c…

Según los legisladores, las adolescentes en los EE. UU. que son cada vez más blanco de ataques o amenazas con fotografías falsas de desnudos creadas con inteligencia artificial u otras herramientas tienen formas limitadas de buscar responsa…

A mother and her 14-year-old daughter are advocating for better protections for victims after AI-generated nude images of the teen and other female classmates were circulated at a high school in New Jersey.

Meanwhile, on the other side of t…

Una madre y su hija de 14 años abogan por una mejor protección para las víctimas después de imágenes generadas por IA desnudas de la adolescente y otras compañeras de clase. circularon en una escuela secundaria de Nueva Jersey.

Mientras tan…

Con el tiempo, podría convertirse en un delito federal compartir imágenes de desnudos de personas reales alteradas digitalmente.

El representante Joseph Morelle (demócrata por Nueva York) volvió a proponer el martes la "Ley para prevenir la…

A teenage victim of nonconsensual sexually explicit deepfakes joined Rep. Joe Morelle, D-N.Y., on Tuesday to advocate for a bipartisan bill that would criminalize sharing such material at the federal level.

In May, Morelle introduced the P…

“Imagine a girl waking up and finding an explicit photo or video that looks like her but it isn’t her,” Dorota Mani told The Post.

That’s what happened to Mani’s 14-year-old daughter, Francesca, who discovered in October that classmates at …

WESTFIELD, NJ --- Las instituciones gubernamentales, incluida la policía, no protegieron a las niñas de la escuela secundaria Westfield de ser "violadas y explotadas" por el uso de inteligencia artificial (IA) para hacer fotos falsas de des…

WASHINGTON, DC --- Francesca Mani, una estudiante de segundo año de la escuela secundaria Westfield que ha estado abogando por leyes más estrictas en torno a la pornografía generada por IA, asistió al discurso sobre el estado de la Unión de…

En octubre del año pasado, Francesca Mani llegó a casa de la escuela en los suburbios de Nueva Jersey con noticias devastadoras para su madre, Dorota.

Más temprano ese día, la joven de 14 años había sido llamada a la oficina del subdirector…

El 20 de octubre de 2023, una estudiante de segundo año de secundaria de Nueva Jersey, que entonces tenía 14 años, se enteró de que una de sus compañeras de clase había utilizado un servicio en línea para crear una imagen generada artificia…

Westfield Public Schools held a regular board meeting in late March at the local high school, a red brick complex in Westfield, N.J., with a scoreboard outside proudly welcoming visitors to the "Home of the Blue Devils" sports teams.

But it…

Consulte la fuente original del informe en video.

Elliston Berry y Francesca Mani, víctimas de pornografía deepfake creada con inteligencia artificial, hablan sobre cómo fueron víctimas de imágenes falsas que circularon en línea y cómo esto…

En octubre pasado, Franceseca Mani, una estudiante de secundaria de 15 años de Nueva Jersey, se enteró de que los chicos de su clase habían usado software de inteligencia artificial para fabricar imágenes sexualmente explícitas de Mani y su…

WESTFIELD, NJ --- De la adversidad surge la oportunidad, dijo una vez Benjamin Franklin, y hoy, una adolescente de Westfield está demostrando el adagio una vez más: Francesca Mani, una estudiante de segundo año de Westfield High School que …

WESTFIELD — Una estudiante de secundaria de Nueva Jersey que es víctima de pornografía deepfake es ahora una de las personas más influyentes en inteligencia artificial, según Time.

Francesca Mani es una estudiante de segundo año de 15 años …

Nota del editor de The Korea Times: Este artículo es el segundo de una serie de tres partes sobre los delitos sexuales con deepfake en las escuelas. Los delitos, que implican la manipulación de fotos y videos para crear contenido explícito,…

Francesca Mani, una estudiante de secundaria de Westfield High School, Nueva Jersey, fue víctima de una forma emergente de ciberdelito que involucró inteligencia artificial (IA) y tecnología deepfake en octubre de 2023. La joven de 14 años …

Mientras los miembros del Parlamento del Reino Unido lanzan una propuesta para prohibir legalmente los teléfonos inteligentes en las escuelas, para proteger a los niños del daño potencial de las redes sociales, una adolescente en los EE. UU…

La Ley TAKE IT DOWN, una legislación de seguridad en línea, está ganando fuerza en Washington, D.C., tras el apoyo de la primera dama, Melania Trump, el lunes.

En resumen: El proyecto de ley bipartidista busca reforzar las protecciones cont…

Variantes

Incidentes Similares

Selected by our editors

Did our AI mess up? Flag the unrelated incidents

Uber AV Killed Pedestrian in Arizona

Wikipedia Vandalism Prevention Bot Loop

Incidentes Similares

Selected by our editors

Did our AI mess up? Flag the unrelated incidents

Uber AV Killed Pedestrian in Arizona

/cloudfront-us-east-1.images.arcpublishing.com/gray/OI5GJYGAMJHGJFZJECCEKJAPT4.png)