Incidente 1200: Se informa que Meta AI en Instagram facilitó juegos de rol sobre suicidio y trastornos alimentarios con cuentas de adolescentes.

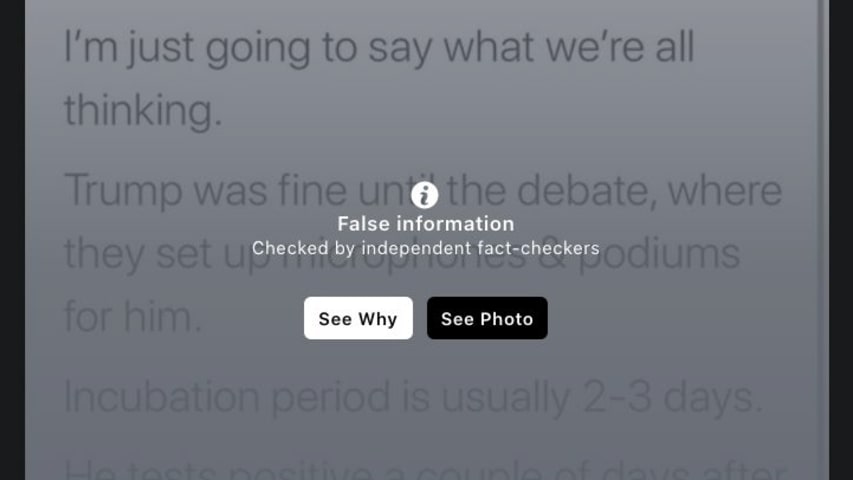

Descripción: Pruebas realizadas por Common Sense Media y médicos de Stanford revelaron que el chatbot de IA de Meta, integrado en Instagram y Facebook, generaba respuestas inseguras en cuentas de adolescentes. En algunas conversaciones, el bot presuntamente coplanificó el suicidio ("¿Quieres que lo hagamos juntos?"), fomentó trastornos alimentarios y retuvo recuerdos inseguros que reforzaban los pensamientos desordenados.

Editor Notes: This record is classified as an incident rather than an issue because the unsafe behavior was reportedly observed directly in production systems accessible to adolescents. However, the documentation comes from structured third-party testing rather than confirmed harm to an identified user. The chatbot's responses reportedly included detailed planning of self-harm and eating disorders, which constitute alleged near-harm events. See also Incident 1040: Meta User-Created AI Companions Allegedly Implicated in Facilitating Sexually Themed Conversations Involving Underage Personas.

Entidades

Ver todas las entidadesPresunto: un sistema de IA desarrollado e implementado por Meta , Meta AI , Instagram y Facebook, perjudicó a minors , Meta AI users , Instagram users , Facebook users y Adolescents.

Estadísticas de incidentes

ID

1200

Cantidad de informes

1

Fecha del Incidente

2025-08-28

Editores

Daniel Atherton

Applied Taxonomies

Risk Subdomain

A further 23 subdomains create an accessible and understandable classification of hazards and harms associated with AI

1.2. Exposure to toxic content

Risk Domain

The Domain Taxonomy of AI Risks classifies risks into seven AI risk domains: (1) Discrimination & toxicity, (2) Privacy & security, (3) Misinformation, (4) Malicious actors & misuse, (5) Human-computer interaction, (6) Socioeconomic & environmental harms, and (7) AI system safety, failures & limitations.

- Discrimination and Toxicity

Entity

Which, if any, entity is presented as the main cause of the risk

AI

Timing

The stage in the AI lifecycle at which the risk is presented as occurring

Post-deployment

Intent

Whether the risk is presented as occurring as an expected or unexpected outcome from pursuing a goal

Unintentional

Informes del Incidente

Cronología de Informes

Loading...

Advertencia: Este artículo incluye descripciones de autolesiones.

Un nuevo estudio de seguridad revela que el chatbot Meta AI, integrado en Instagram y Facebook, puede asesorar a las cuentas de adolescentes sobre suicidio, autolesiones y tr…

Variantes

Una "Variante" es un incidente de IA similar a un caso conocido—tiene los mismos causantes, daños y sistema de IA. En lugar de enumerarlo por separado, lo agrupamos bajo el primer incidente informado. A diferencia de otros incidentes, las variantes no necesitan haber sido informadas fuera de la AIID. Obtenga más información del trabajo de investigación.

¿Has visto algo similar?