Registro de citas para el Incidente 11

Entidades

Ver todas las entidadesEstadísticas de incidentes

Clasificaciones de la Taxonomía CSETv0

Detalles de la TaxonomíaFull Description

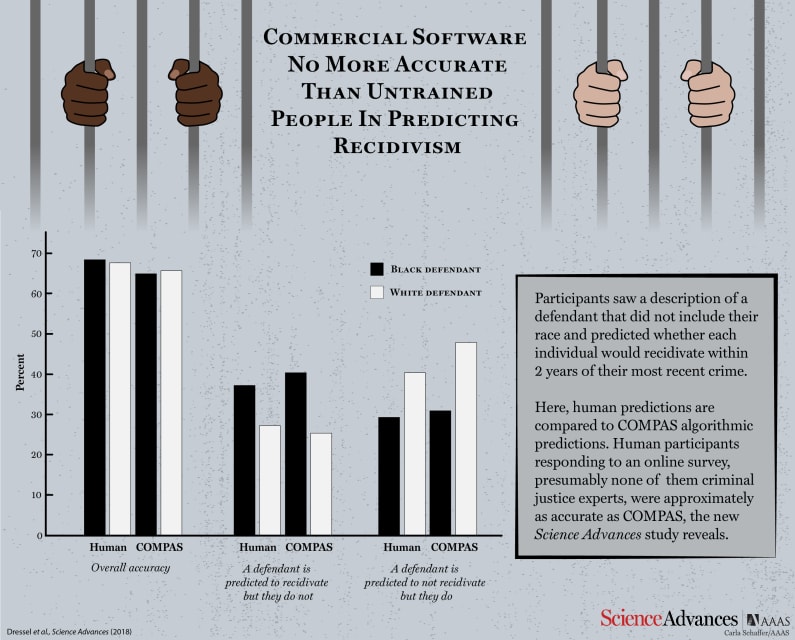

An algorithm developed by Northpointe and used in the penal system is shown to be inaccurate and produces racially-skewed results according to a review by ProPublica. The review shows how the 137-question survey given following an arrest is inaccurate and skewed against people of color. While there is not question regarding race in the survey, the algorithm is two times more likely to incorrectly label a black person as a high-risk re-offender (False Positive) and is also two times more likely to incorrectly label a white person as low-risk for reoffense (False Negative) than actual statistics support. Overall, the algorithm is 61% effective at predicting reoffense. This system is used in Broward County, Florida to help judges make decisions surrounding pre-trial release and sentencing post-trial.

Short Description

An algorithm developed by Northpointe and used in the penal system is two times more likely to incorrectly label a black person as a high-risk re-offender and is two times more likely to incorrectly label a white person as low-risk for reoffense according to a ProPublica review.

Severity

Unclear/unknown

Harm Distribution Basis

Race

Harm Type

Harm to civil liberties, Other:Reputational harm; False incarceration

AI System Description

An algorithm, developed by Northpointe designed to assign a risk score associated with a person's likelihood of reoffending after their original arrest.

System Developer

Northpointe

Sector of Deployment

Public administration and defence

Relevant AI functions

Perception, Cognition

AI Techniques

law enforcement algorithm, crime prediction algorithm

AI Applications

risk assesment, crime projection

Location

Broward County, Florida

Named Entities

ProPublica, Northpointe, COMPAS, Broward County, FL

Technology Purveyor

Northpointe

Beginning Date

2016-01-01T00:00:00.000Z

Ending Date

2019-01-01T00:00:00.000Z

Near Miss

Harm caused

Intent

Accident

Lives Lost

No

Infrastructure Sectors

Government facilities

Data Inputs

137-question survey

Clasificaciones de la Taxonomía CSETv1

Detalles de la TaxonomíaHarm Distribution Basis

race

Sector of Deployment

law enforcement, public administration

Informes del Incidente

Cronología de Informes

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Los programas informáticos que realizan evaluaciones de riesgo de los sospechosos de delitos son cada vez más comunes en los tribunales estadounidenses y se utilizan en todas las etapas de los sistemas de justicia penal para determinar quié…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

En todo el país, los jueces y los oficiales de libertad condicional utilizan cada vez más algoritmos para evaluar la probabilidad de que un acusado de un delito se convierta en reincidente, un término que se usa para describir a los delincu…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Durante años, la comunidad de justicia penal ha estado preocupada. Los tribunales de todo el país están asignando montos de fianza para sentenciar a los acusados en función de algoritmos, y tanto los abogados como los científicos de datos a…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

En una tarde de primavera de 2014, Brisha Borden llegaba tarde para recoger a su hermanastra de la escuela cuando vio una bicicleta Huffy azul para niños sin llave y un scooter Razor plateado. Borden y un amigo tomaron la bicicleta y el sco…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

La discriminación oculta en los puntajes de evaluación de riesgos penales

Los tribunales de todo el país utilizan cada vez más el "puntaje de evaluación de riesgo" del acusado para ayudar a tomar decisiones sobre la fianza, la libertad cond…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Una de mis posesiones más preciadas es El arte de la programación informática de Donald Knuth, un científico informático para quien se podría haber acuñado la palabra "legendario". En cierto modo, uno podría pensar en su magnum opus como un…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Imagine que lo declararon culpable de un delito y estaba esperando conocer su sentencia. ¿Preferiría que su sentencia sea determinada por un algoritmo informático, que sopesa desapasionadamente los factores que predicen su riesgo futuro de …

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Al igual que una versión más torcida de la prueba Voight-Kampff de Blade Runner, un nuevo artículo de aprendizaje automático de un par de investigadores chinos ha profundizado en la controvertida tarea de dejar que una computadora decida so…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Predecir el futuro no es solo la procedencia de los adivinos o los expertos de los medios. Los algoritmos predictivos, basados en amplios conjuntos de datos y estadísticas, han superado las operaciones mayoristas y minoristas, como sabe cua…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

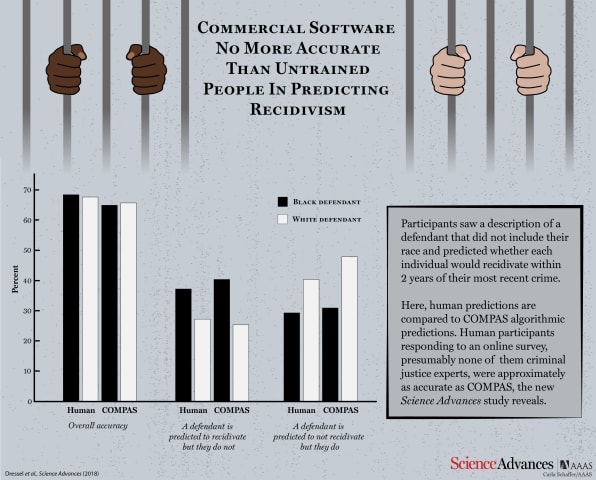

De hecho, se justifica la precaución, según Julia Dressel y Hany Farid de Dartmouth College. En un nuevo estudio, demostraron que COMPAS no es mejor para predecir el riesgo de reincidencia de un individuo que los voluntarios reclutados al a…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

No culpe al algoritmo: mientras existan disparidades raciales en el sistema de justicia, el software de sentencia nunca podrá ser completamente justo.

Durante generaciones, el pueblo maasai del este de África ha transmitido la historia de u…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Aunque las tasas de criminalidad han disminuido constantemente desde la década de 1990, las tasas de reincidencia siguen siendo un factor tanto en las áreas de seguridad pública como en el manejo de prisioneros. El Instituto Nacional de Jus…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Los algoritmos invisibles moldean cada vez más el mundo en el que vivimos, y no siempre para mejor. Desafortunadamente, existen pocos mecanismos para garantizar que no causen más daño que bien.

Eso finalmente podría estar cambiando: un prim…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Abre la aplicación de fotos en tu teléfono y busca "perro", y aparecerán todas las fotos que tengas de perros. Esta no fue una hazaña fácil. Su teléfono sabe cómo se ve un perro.

Esta maravilla moderna es el resultado del aprendizaje automá…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

De niño, desarrollas un sentido de lo que significa “justicia”. Es un concepto que aprendes desde el principio a medida que aceptas el mundo que te rodea. Algo se siente justo o no.

Pero cada vez más, los algoritmos han comenzado a arbitrar…

Variantes

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Policing the Future

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents