インシデントのステータス

Risk Subdomain

1.2. Exposure to toxic content

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

インシデントレポート

レポートタイムライン

やあ、新年おめでとう、席に着いて。AI の悪ふざけがさらに進むかもしれない!私たちはすでに AI ナレーターと AI 著者の急増 について議論している。今年は、今度は「なんてこった人種差別」を添えて、AI 生成の新たなゴミ山で始めてみてはいかがだろうか?

2 日前、Tiana’s LitTalk on Threads が 読者向けソーシャル メディア アプリ Fable から 読者向け要約のスクリーンショット を投稿した。よく知らない人のために説明すると、Fable ユーザー…

「読書好きやビンジウォッチャー」の天国と自称する人気の ソーシャルメディア アプリ である Fable は、2024 年にユーザーが読んだ本をまとめた AI 搭載の年末サマリー機能を作成しました。遊び心と楽しさを意図したものでしたが、一部のサマリーは奇妙に闘争的なトーンを帯びていました。たとえば、作家のダニー・グローブスのサマリーでは、彼を「多様性の信奉者」と名付けた後、「ストレートなシスジェンダーの白人男性の視点に興味があるときはあるか」と尋ねました。

一方、書籍インフルエ…

書籍追跡アプリ Fable は、人種、性別、性的指向、障害に対して不快感を与える読者向け要約をプラットフォームが生成したことを受けて、人気の AI 機能を削除する予定。

Fable の年間読書概要は、Spotify Wrapped と似たスタイルで、読者の「ユニークさ」を「遊び心のある楽しい方法」で称えることを目的としていると、製品責任者のクリス・ガレロ氏は ソーシャルメディアに投稿した動画 で述べた。

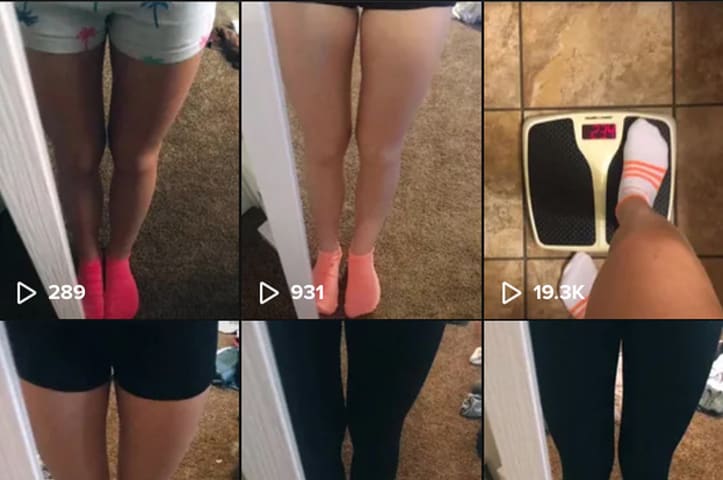

ティアナ・トラメルは物議を醸す概要を受け取った人の 1 人だった。彼女が…

本について語り、追跡するための人気アプリであるFableは、人工知能モデルが不快な言葉を使ったという苦情を受けて、ユーザー向けにパーソナライズされた要約を作成する方法を変更しています。

ある要約では、黒人の物語を読む読者は白人の著者の作品も読むべきだと示唆していました。

今週のInstagramの投稿で、Fableの製品責任者であるChris Gallelloは、アプリ上でAIが生成した要約の問題について言及し、「非常に偏見に満ちた人種差別的な言葉」に関する苦情がFableに…