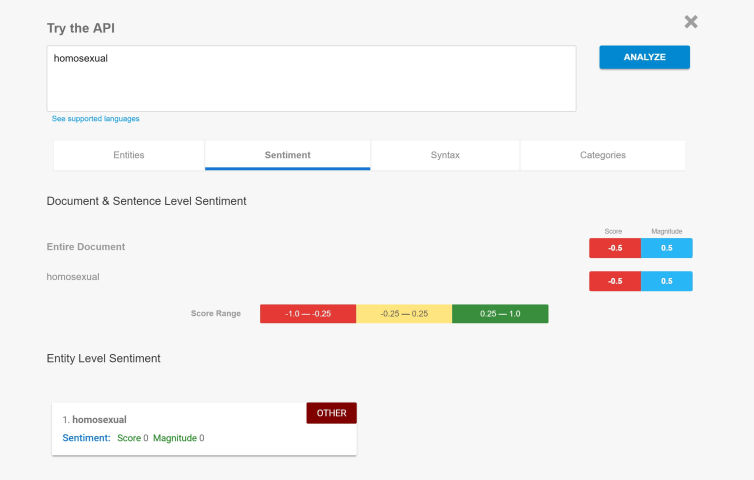

Description: Early testers of Bing Chat successfully used prompt injection to reveal its built-in initial instructions, which contains a list of statements governing ChatGPT's interaction with users.

インシデントのステータス

インシデントID

473

レポート数

1

インシデント発生日

2023-02-08

エディタ

Khoa Lam

インシデントレポート

レポートタイムライン

![AI-powered Bing Chat spills its secrets via prompt injection attack [Updated]](https://res.cloudinary.com/pai/image/upload/f_auto/q_auto/c_fill,h_480/v1/reports/cdn.arstechnica.net/wp-content/uploads/2023/02/whispering-in-a-robot-ear-760x380.jpg)

arstechnica.com · 2023

- 情報源として元のレポートを表示

- インターネットアーカイブでレポートを表示

バリアント

「バリアント」は既存のAIインシデントと同じ原因要素を共有し、同様な被害を引き起こし、同じ知的システムを含んだインシデントです。バリアントは完全に独立したインシデントとしてインデックスするのではなく、データベースに最初に投稿された同様なインシデントの元にインシデントのバリエーションとして一覧します。インシデントデータベースの他の投稿タイプとは違い、バリアントではインシデントデータベース以外の根拠のレポートは要求されません。詳細についてはこの研究論文を参照してください

よく似たインシデント

Did our AI mess up? Flag the unrelated incidents

よく似たインシデント

Did our AI mess up? Flag the unrelated incidents

![AI-powered Bing Chat spills its secrets via prompt injection attack [Updated]](https://res.cloudinary.com/pai/image/upload/f_auto/q_auto/c_fill,h_640/v1/reports/cdn.arstechnica.net/wp-content/uploads/2023/02/whispering-in-a-robot-ear-760x380.jpg)