インシデントのステータス

インシデントレポート

レポートタイムライン

.jpg)

- 情報源として元のレポートを表示

- インターネットアーカイブでレポートを表示

An investigation into the 'raciest' clothing from different fashion brands has highlighted the fact that Google uses software to rate imagery as part of a 'safe search' tool and scores clothing based on how 'skimpy or sheer' it is.

Google's…

- 情報源として元のレポートを表示

- インターネットアーカイブでレポートを表示

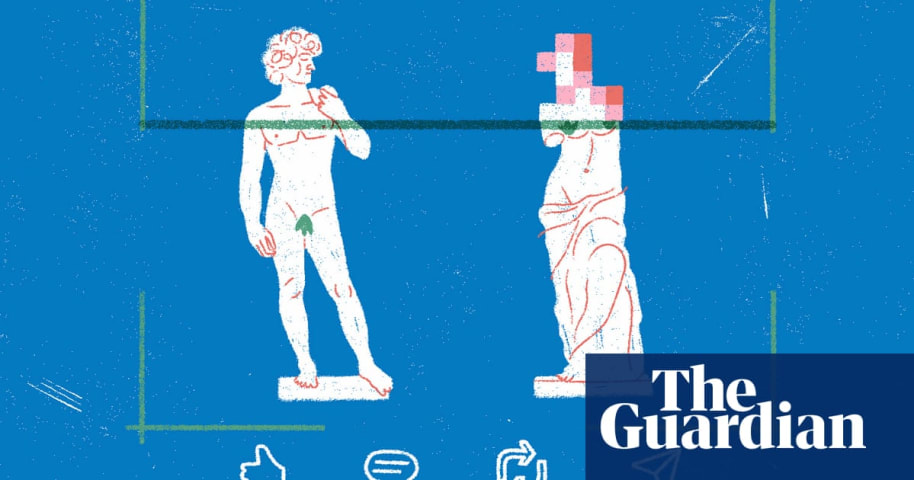

Images posted on social media are analyzed by artificial intelligence (AI) algorithms that decide what to amplify and what to suppress. Many of these algorithms, a Guardian investigation has found, have a gender bias, and may have been cens…

- 情報源として元のレポートを表示

- インターネットアーカイブでレポートを表示

Many social media platforms such as Instagram and LinkedIn use content moderation systems to suppress images that are sexually explicit or deemed inappropriate for viewers.

But what happens when these systems block images that are not at a…

バリアント

よく似たインシデント

Did our AI mess up? Flag the unrelated incidents

よく似たインシデント

Did our AI mess up? Flag the unrelated incidents

.jpg)