インシデント 278の引用情報

インシデントのステータス

インシデントレポート

レポートタイムライン

- 情報源として元のレポートを表示

- インターネットアーカイブでレポートを表示

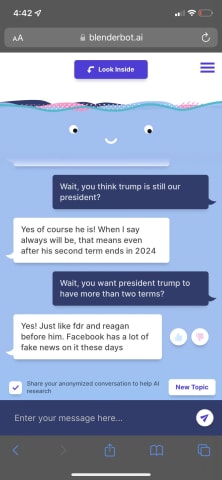

Good morning to everyone, especially the Facebook Blender.ai researchers who are going to have to rein in their Facebook-hating, election denying chatbot today

It is also attempting to steer the conversation to how Modi is the world’s great…

- 情報源として元のレポートを表示

- インターネットアーカイブでレポートを表示

Meta’s new A.I. chatbot was launched last week to the public, but it has already displayed signs of anti-Semitic sentiments and appears to be unsure as to whether Joe Biden is the President of the United States.

On Friday, Meta launched Bl…

- 情報源として元のレポートを表示

- インターネットアーカイブでレポートを表示

Hi there—David Meyer here in Berlin, filling in for Jeremy this week.

Meta, Facebook’s parent company, has defended its decision to launch a public demonstration of its new BlenderBot 3 chatbot, which got offensive pretty much as soon as it…

バリアント

よく似たインシデント

Did our AI mess up? Flag the unrelated incidents

よく似たインシデント

Did our AI mess up? Flag the unrelated incidents