インシデントのステータス

Risk Subdomain

2.1. Compromise of privacy by obtaining, leaking or correctly inferring sensitive information

Risk Domain

- Privacy & Security

Entity

Human

Timing

Post-deployment

Intent

Unintentional

インシデントレポート

レポートタイムライン

WIREDが確認した新たな調査によると、ファンタジーや性的ロールプレイングの会話向けに設計された複数のAI チャットボットが、ユーザーのプロンプトをほぼリアルタイムでウェブ上に漏洩していることが明らかになりました。この調査によると、漏洩したデータの一部には、児童性的虐待の詳細を記した会話を作成している人々の様子が記録されています。

生成型AIチャットボットとの会話はほぼ瞬時に行われ、プロンプトを入力するとAIが応答します。しかし、システムの設定が不適切�だと、チャット内容が漏洩…

%20(1).png)

AIの普及により、多くの新しいソフトウェア技術が急速に導入され、それぞれに情報セキュリティを侵害する可能性のある設定ミスの危険性が存在します。そのため、UpGuard Researchの使命は、新しい技術に特有のベクトルを発見し、そのサイバーリスクを測定することです。

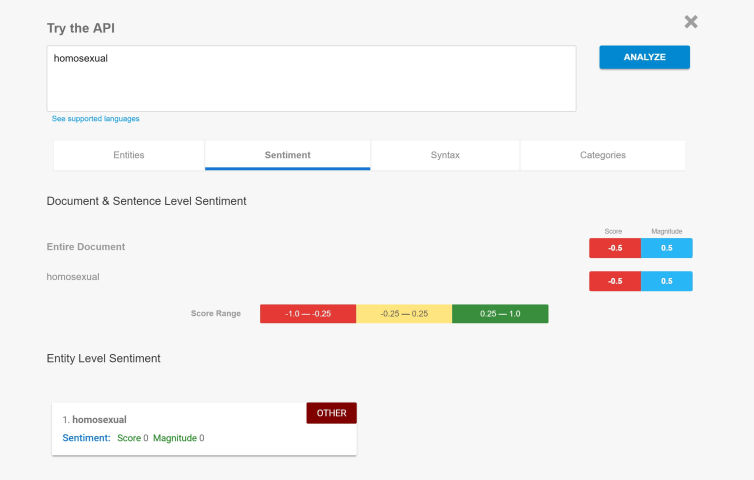

本調査では、大規模言語モデル(LLM)を利用するためのオープンソースフレームワークであるllama.cppを取り上げます。Llama.cppはユーザープロンプトを漏洩する可能性がありますが、実際に存在するlla…

バリアント

よく似たインシデント

Did our AI mess up? Flag the unrelated incidents

よく似たインシデント

Did our AI mess up? Flag the unrelated incidents

%20(1).png)