Incidentes Asociados

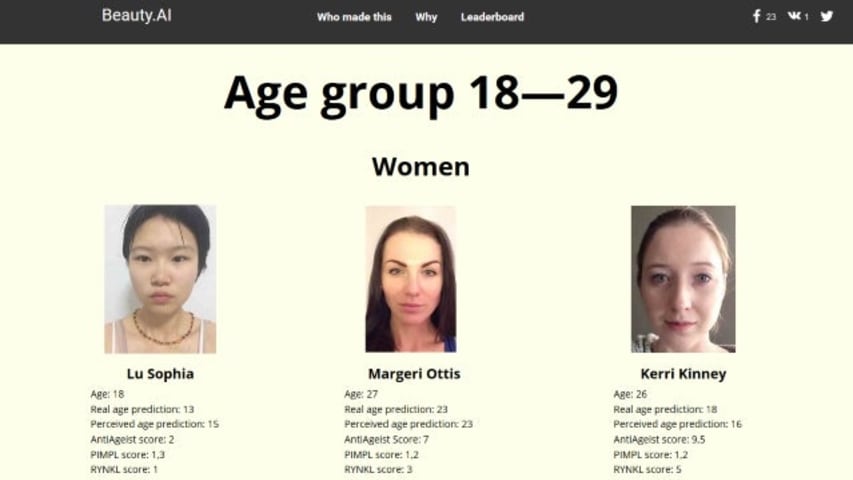

No es la primera vez que la inteligencia artificial está en el centro de atención por un aparente racismo, pero los resultados recientes de la competencia de Beauty.AI han causado controversia al favorecer claramente la piel clara.

La competencia, que se llevó a cabo en línea y estuvo abierta a hombres y mujeres de todo el mundo de todas las edades, terminó con casi todos los ganadores de piel blanca, lo que provocó los gritos de racismo de los robots.

Sin embargo, dado que la IA es tan inteligente como los conjuntos de datos en los que está entrenada, eso podría estar exagerando el punto. Los robots no tienen forma de ser inherentemente racistas. Un titular alternativo podría ser "La metodología de investigación fallida conduce a resultados sesgados", pero esa no es una lectura tan convincente.

De hecho, Alex Zhavoronkov, director científico de Beauty.AI, dijo que los resultados fueron una falta de minorías étnicas en el conjunto de datos de entrenamiento. Esto significaba que, aunque la piel clara no se definía como parte de la belleza, la IA establecía la asociación de todos modos.

Ese descuido, o deficiencia, de la investigación significó que, a pesar de que el objetivo de la competencia era eliminar el sesgo humano juzgando según criterios específicos, todavía se colaba de todos modos.

A principios de año, un chatbot de Twitter con IA creado por Microsoft llamado Tay tuvo que ser desconectado después de solo 24 horas después de haber sido enseñado a convertirse en un racista obsesionado con el sexo.

Claramente, necesitamos encontrar una manera de entrenar la IA de manera más sólida.

Relacionado: Microsoft se disculpa por las diatribas neonazis y locas por el sexo de AI Twitter chatbot

Ver: iPhone 7 contra Galaxy S7

¿Crees que los robots pueden ser racistas o crees que siempre son datos incorrectos proporcionados por humanos? Háganos saber en los comentarios a continuación.