Incidentes Asociados

Resumen Ejecutivo

Existen pruebas que sugieren que los trabajadores de TI norcoreanos utilizan tecnología deepfake en tiempo real para infiltrarse en organizaciones a través de puestos de trabajo remotos, lo que supone importantes riesgos de seguridad, legales y de cumplimiento normativo. Las estrategias de detección que describimos en este informe ofrecen a los equipos de seguridad y RR. HH. una guía práctica para fortalecer sus procesos de contratación contra esta amenaza.

En nuestra demostración, se tardó poco más de una hora, sin experiencia previa, en descubrir cómo crear un deepfake en tiempo real utilizando herramientas fácilmente disponibles y hardware de consumo económico. Esto permite a los adversarios crear fácilmente identidades sintéticas convincentes, lo que les permite operar sin ser detectados y potencialmente generar ingresos para los regímenes sancionados.

Si bien aún se detectan limitaciones en la tecnología deepfake actual, estas están disminuyendo rápidamente. Las organizaciones deben implementar defensas por capas combinando procedimientos de verificación mejorados, controles técnicos y monitorización continua a lo largo de la vida del empleado.

Los clientes de Palo Alto Networks están mejor protegidos contra las amenazas descritas en este artículo gracias a los Servicios contra Amenazas Internas de Unit 42 (https://www.paloaltonetworks.com/resources/datasheets/unit42-insider-threat-services).

Las organizaciones pueden contactar con el Equipo de Respuesta a Incidentes de Unit 42 (https://start.paloaltonetworks.com/contact-unit42.html) para obtener asistencia específica sobre esta y otras amenazas.

| Temas relacionados con Unit 42 | [Ingeniería social] (https://unit42.paloaltonetworks.com/tag/social-engineering/), [DPRK] (https://unit42.paloaltonetworks.com/tag/dprk/), [Wagemole] (https://unit42.paloaltonetworks.com/tag/wagemole/) | | --- | --- |

Entrevistas a norcoreanos

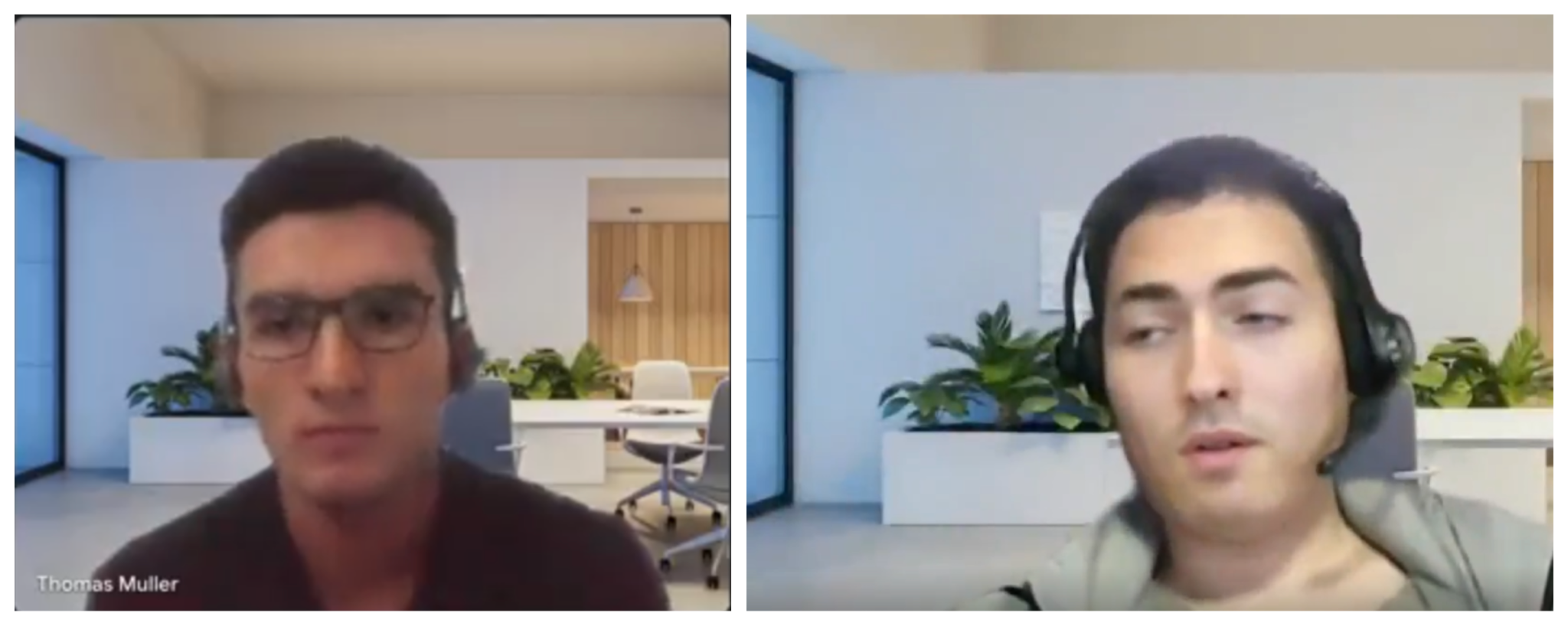

Las comunidades de captación de talento y ciberseguridad han informado recientemente de un aumento en el número de candidatos que utilizan deepfakes en tiempo real durante las entrevistas de trabajo. Investigadores han documentado casos en los que los entrevistados presentaron transmisiones de vídeo sintéticas, utilizando fondos virtuales idénticos en diferentes perfiles de candidatos, como se muestra en la Figura 1.

Figura 1. Comparación de dos entrevistados deepfake. Fuente: Daniel Grek Sanchez Castellanos y Bettina Liporazzi.

El boletín informativo Pragmatic Engineer (https://newsletter.pragmaticengineer.com/p/ai-fakers) documentó un caso práctico de una empresa polaca de inteligencia artificial que se encontró con dos candidatos deepfakes distintos. Los entrevistadores sospecharon que la misma persona operaba ambas personalidades, sobre todo cuando el operador mostró una confianza notablemente mayor durante la segunda entrevista técnica, tras haber experimentado previamente el formato y las preguntas de la entrevista.

El análisis de Unit 42 de los indicadores compartidos en el informe de Pragmatic Engineer coincide con las tácticas, técnicas y procedimientos (TTP) conocidos atribuidos a las operaciones de los trabajadores de TI de la República Popular Democrática de Corea (RPDC) (https://unit42.paloaltonetworks.com/north-korean-it-workers/). Esto representa una evolución lógica de su esquema establecido de infiltración fraudulenta en el trabajo.

Los actores de amenazas norcoreanos han demostrado constantemente un gran interés en las técnicas de manipulación de identidad. En nuestra [investigación de 2023] (https://unit42.paloaltonetworks.com/two-campaigns-by-north-korea-bad-actors-target-job-hunters/), informamos sobre sus esfuerzos por crear identidades sintéticas respaldadas por información personal comprometida, lo que dificulta su detección.

Encontramos más evidencia al analizar la filtración de Cutout.pro (https://www.bitdefender.com/en-us/blog/hotforsecurity/hacker-leaks-records-of-20-million-users-of-ai-visual-creation-platform-online), un servicio de manipulación de imágenes con IA, que reveló decenas de direcciones de correo electrónico probablemente vinculadas a operaciones de trabajadores de TI de la RPDC. La Figura 2 muestra dicha manipulación de imágenes en retratos con rostros intercambiados.

![Imágenes en paralelo de una persona antes y después de un cambio de rostro, que muestran una transformación de un aspecto natural a la izquierda a una apariencia más pulida con un filtro.] (https://unit42.paloaltonetworks.com/wp-content/uploads/2025/04/word-image-308904-139512-2.png)

Figura 2. Un operador norcoreano experimenta con el cambio de rostro.

Los trabajadores de TI de la RPDC mejoraron gradualmente su metodología de infiltración mediante la implementación de tecnología deepfake en tiempo real. Esto ofrece dos ventajas operativas clave. En primer lugar, permite a un mismo operador entrevistarse para el mismo puesto varias veces utilizando diferentes perfiles de usuario. En segundo lugar, ayuda a los agentes a evitar ser identificados y añadidos a boletines de seguridad y avisos de búsqueda, como el que se muestra en la Figura 3. En conjunto, permite a los trabajadores de TI de la RPDC disfrutar de una mayor seguridad operativa y una menor detectabilidad.

Figura 3. Un cartel de búsqueda para trabajadores de TI de la RPDC, recuperado el 20 de marzo de 2025.

De cero a aceptable

Un solo investigador sin experiencia en manipulación de imágenes, con conocimientos limitados sobre deepfakes y una computadora de cinco años de antigüedad creó una identidad sintética para entrevistas de trabajo en 70 minutos. La facilidad de creación demuestra lo peligrosamente accesible que se ha vuelto esta tecnología para los cibercriminales.

Utilizando únicamente un motor de búsqueda de IA, una conexión a internet aceptable y una unidad de procesamiento gráfico GTX 3070 adquirida a finales de 2020, crearon la muestra que se muestra en la Figura 4.

Figura 4. Demostración de un deepfake en tiempo real en hardware económico y de fácil acceso.

Utilizaron únicamente imágenes individuales generadas por thispersonnotexist[.]org, que permite el uso de rostros generados con fines personales y comerciales, así como herramientas gratuitas para deepfakes. Con estas, generaron múltiples identidades, como se muestra en la Figura 5.

Figura 5. Demostración de cambio de identidad.

Un simple cambio de vestuario y de imagen de fondo podría ser suficiente para que un responsable de contratación lo considere un candidato completamente nuevo. De hecho, la parte más laboriosa de todo este proceso fue crear una señal de cámara virtual para capturarla en un software de videoconferencia.

Con un poco más de tiempo y una unidad de procesamiento gráfico mucho más potente, una versión de mayor resolución del mismo proceso produjo resultados más convincentes, como se muestra en la Figura 6.

Figura 6. Un deepfake de mayor calidad utilizando una técnica que consume más recursos.

Oportunidades de detección

Existen varias deficiencias técnicas en los sistemas de deepfake en tiempo real que generan oportunidades de detección:

- Problemas de consistencia temporal: Los movimientos rápidos de la cabeza causaban artefactos perceptibles, ya que el sistema de seguimiento tenía dificultades para mantener la posición precisa de los puntos de referencia.

- Manejo de la oclusión: Cuando la mano del operador pasaba sobre su rostro, el sistema de deepfake no lograba reconstruir correctamente el rostro parcialmente oscurecido.

- Adaptación a la iluminación: Los cambios repentinos en las condiciones de iluminación revelaron inconsistencias en la representación, especialmente alrededor de los bordes del rostro.

- Sincronización audiovisual: Se detectaron ligeros retrasos entre los movimientos de los labios y el habla mediante una observación minuciosa.

Actualmente, existen varias maneras de dificultar la vida a los posibles deepfakers. El método más eficaz parece ser pasar la mano por el rostro, lo que interrumpe el seguimiento de los puntos de referencia faciales.

Govind Mittal et al., de la Universidad de Nueva York, sugieren estrategias adicionales:

- Movimientos rápidos de cabeza

- Expresiones faciales exageradas

- Cambios repentinos de iluminación

Estas técnicas explotan las debilidades de los sistemas de deepfake en tiempo real, lo que provoca artefactos visibles que ayudan a los humanos a detectar falsificaciones con gran precisión.

Mostraremos tres opciones más para añadir al repertorio de un entrevistador en las Figuras 7a-c.

Figura 7a. El "de oreja a hombro".

Figura 7b. El "mostrar la nariz".

Figura 7c. El "cielo o tierra".

Estrategias de mitigación

La campaña de trabajadores de TI de la RPDC exige una estrecha colaboración entre los equipos de recursos humanos (RR. HH.) y de seguridad de la información. La colaboración entre ambos brinda a la organización mayores oportunidades de detección a lo largo de todo el ciclo de contratación y empleo.

Aviso legal: Las siguientes estrategias de mitigación buscan ofrecer información y sugerencias para la consideración del lector. Se proporcionan únicamente con fines informativos y no deben considerarse asesoramiento legal. Antes de implementar cualquiera de estas prácticas, consulte con su asesor legal para confirmar su conformidad con la legislación aplicable.

Para los equipos de RR. HH.:

- Solicitar a los candidatos que enciendan sus cámaras durante las entrevistas, incluidas las consultas iniciales.

- Grabar estas sesiones (con el consentimiento correspondiente) para un posible análisis forense.

- Implementar un flujo de trabajo integral de verificación de identidad que incluya:

- Verificación de la autenticidad de los documentos mediante herramientas forenses automatizadas que verifican las características de seguridad, los indicadores de manipulación y la coherencia de la información en los documentos presentados.

- Verificación de identidad con detección de vida integrada, que requiere que los candidatos presenten su identificación física mientras realizan acciones específicas en tiempo real.

- Cotejo entre los documentos de identidad y el entrevistado, garantizando que la persona que entrevista coincida con su supuesta identidad.

- Capacitar a los reclutadores y a los equipos de entrevistas técnicas para identificar patrones sospechosos en las entrevistas de video, como movimientos oculares anormales, inconsistencias en la iluminación y problemas de sincronización audiovisual.

- Que los entrevistadores se familiaricen con pedir a los candidatos que realicen movimientos que dificultan el uso de software de deepfake (por ejemplo, giros de perfil, gestos con las manos cerca de la cara o movimientos rápidos de la cabeza).

Para los equipos de seguridad:

- Asegurar el proceso de contratación registrando las direcciones IP de las solicitudes de empleo y verificando que no provengan de infraestructuras de anonimización ni de ubicaciones geográficas sospechosas. Regiones

- Enriquecer los números de teléfono proporcionados para verificar si son operadores de Voz sobre Protocolo de Internet (VoIP), en particular aquellos comúnmente asociados con la ocultación de identidad.

- Mantener acuerdos de intercambio de información con empresas asociadas y participar en los Centros de Intercambio y Análisis de Información (ISAC) correspondientes para mantenerse al día con las últimas t�écnicas de identidad sintética.

- Identificar y bloquear aplicaciones de software que permitan la instalación de cámaras web virtuales en dispositivos administrados por la empresa cuando no exista una justificación comercial legítima para su uso.

Indicadores adicionales:

- Supervisar patrones anormales de acceso a la red tras la contratación, en particular conexiones a servicios de anonimización o transferencias de datos no autorizadas.

- Implementar métodos de autenticación multifactor que requieran la posesión física de dispositivos, lo que dificulta la suplantación de identidad.

Consideraciones de la política organizacional:

- Desarrollar protocolos claros para la gestión de casos sospechosos de identidad sintética, incluyendo procedimientos de escalamiento y métodos de preservación de pruebas.

- Crear un programa de concienciación sobre seguridad que informe a todos los empleados involucrados en la contratación sobre las señales de alerta de identidad sintética.

- Establecer controles técnicos que limiten el acceso de los nuevos empleados hasta que se alcancen los hitos de verificación adicionales.

- Documentar los fallos de verificación y compartir los indicadores técnicos apropiados con los socios del sector y las agencias gubernamentales pertinentes.

Al implementar estas estrategias de detección y mitigación por capas, las organizaciones pueden reducir significativamente el riesgo de infiltración de identidad sintética, a la vez que mantienen un proceso de contratación eficiente para los candidatos legítimos.

Conclusión

La amenaza de la identidad sintética, caracterizada por las operaciones de los trabajadores de TI de Corea del Norte, representa un desafío en constante evolución para las organizaciones de todo el mundo. Nuestra investigación demuestra la alarmante accesibilidad de la creación de identidades sintéticas, con la continua reducción de las barreras técnicas a medida que los rostros generados por IA, las herramientas de falsificación de documentos y las tecnologías de manipulación de voz/video en tiempo real se vuelven más sofisticadas y fácilmente disponibles.

A medida que las tecnologías de identidad sintética continúan evolucionando, las organizaciones deben implementar estrategias de defensa por capas que combinen:

- Procedimientos de verificación mejorados

- Contramedidas asistidas por IA para la detección de deepfakes

- Verificación continua durante toda la jornada laboral

Este enfoque mejora significativamente la capacidad de una organización para detectar y mitigar no solo a los trabajadores de TI norcoreanos, sino también a diversas amenazas similares.

Ningún método de detección por sí solo garantiza la protección contra las amenazas de identidad sintética, pero una estrategia de defensa por capas mejora significativamente la capacidad de su organización para identificar y mitigar estos riesgos. Al combinar las mejores prácticas de RR. HH. con los controles de seguridad, puede mantener un proceso de contratación eficiente y, al mismo tiempo, protegerse contra las tácticas sofisticadas empleadas por los trabajadores de TI norcoreanos y actores de amenazas similares.

Los clientes de Palo Alto Networks pueden protegerse mejor contra las amenazas mencionadas anteriormente a través de Unit 42 Insider Threat Services para optimizar la detección y la remediación de forma integral.

Si cree que su seguridad podría haber sido comprometida o tiene un asunto urgente, póngase en contacto con el Equipo de Respuesta a Incidentes de Unit 42 o llame al:

- Norteamérica: Llamada gratuita: +1 (866) 486-4842 (866.4.UNIT42)

- Reino Unido: +44.20.3743.3660

- Europa y Oriente Medio: +31.20.299.3130

- Asia: +65.6983.8730

- Japón: +81.50.1790.0200

- Australia: +61.2.4062.7950

- India: 00080005045107

Palo Alto Networks ha compartido estos hallazgos con los miembros de la Cyber Threat Alliance (CTA). Los miembros de la CTA utilizan esta información para implementar rápidamente protecciones para sus clientes e interrumpir sistemáticamente a los ciberdelincuentes. Obtenga más información sobre la Cyber Threat Alliance.

Recursos adicionales

- Falso trabajador de TI norcoreano vinculado a un ataque de phishing a la aplicación de videoconferencia BeaverTail-- Unidad 42, Palo Alto Networks

- Empresas globales pagan a norcoreanos sin saberlo: Cómo atraparlos-- Unidad 42, Palo Alto Networks

- Hackeo de empleadores y búsqueda de empleo: Dos campañas relacionadas con empleos con el sello de los actores de amenazas de la RPDC-- Unidad 42, Palo Alto Networks

- Entrevista contagiosa: Agentes de amenazas de la RPDC engañan a solicitantes de empleo de la industria tecnológica para que instalen nuevas variantes del malware BeaverTail e InvisibleFerret-- Unidad 42, Palo Alto Networks

- Aviso: Detección de deepfakes en vídeo en tiempo real mediante desafío-respuesta-- Govind Mittal, Chinmay Hegde, Nasir Memon

- Falsificadores de IA expuestos en la contratación de desarrolladores tecnológicos: análisis retrospectivo-- Gergely Orosz, The Pragmatic Engineer

- Esto es lo que sucede en un Entrevista sobre deepfake -- Billy Hurley, IT Brew

- La dinámica emergente de las campañas de estafa deepfake en la web - Unidad 42