Incidentes Asociados

Loading...

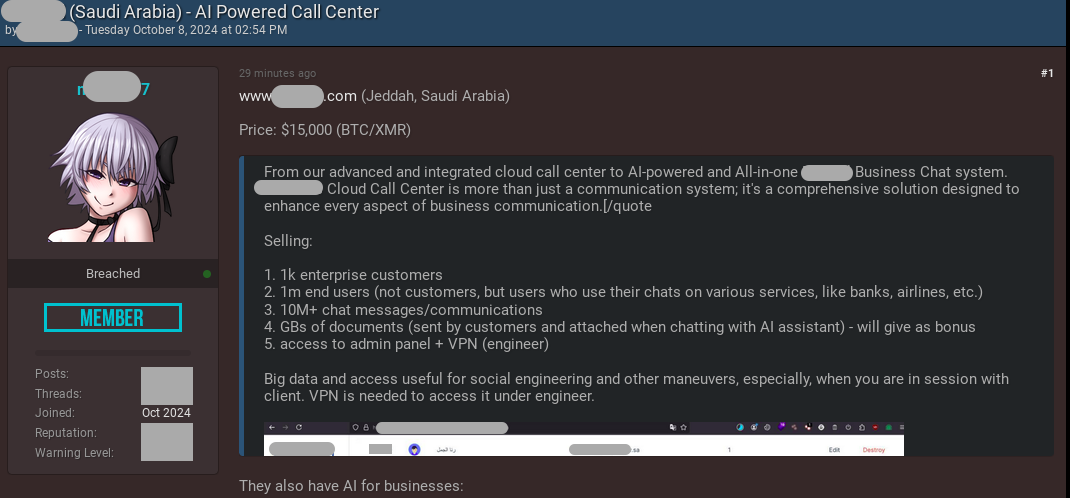

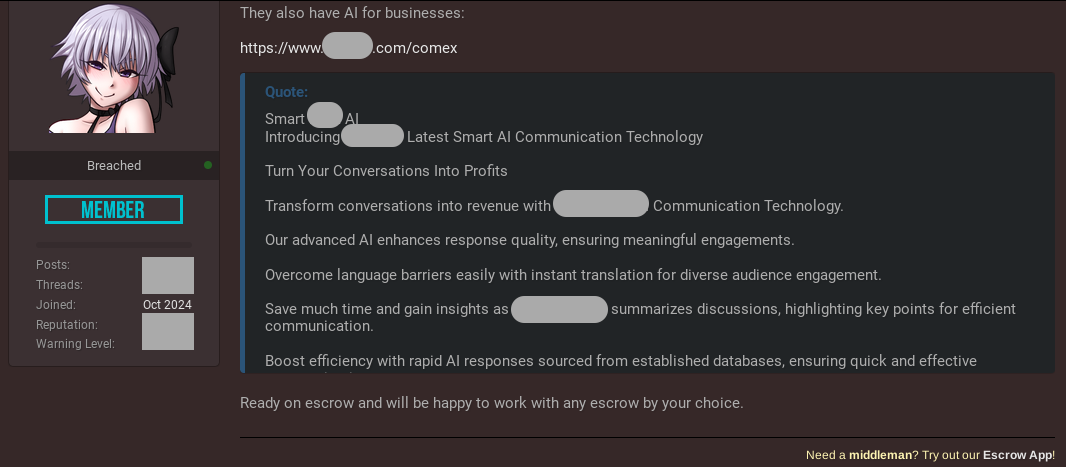

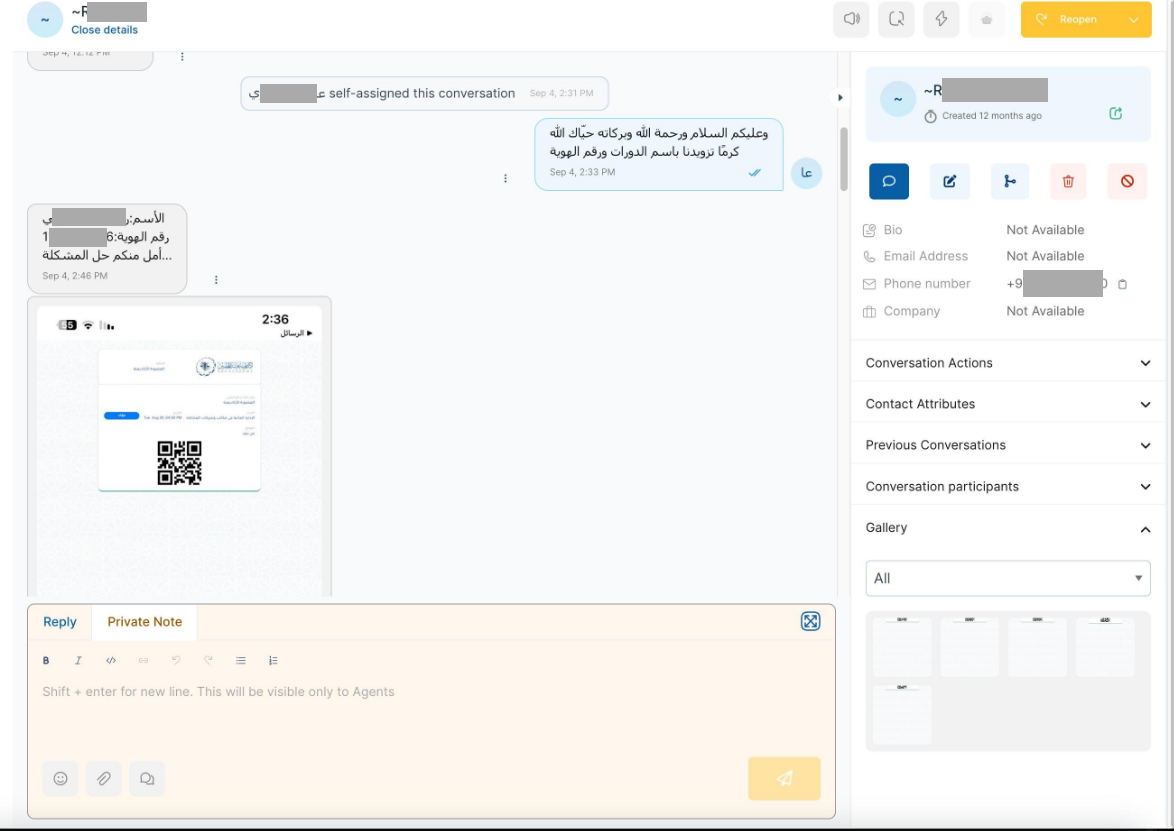

El actor de amenazas obtuvo acceso no autorizado al panel de administración de la plataforma, que contiene más de 10,210,800 conversaciones entre consumidores, operadores y agentes de IA (bots). Los datos robados podrían usarse para orquestar actividades fraudulentas avanzadas y campañas de ingeniería social, así como otras tácticas cibercriminales utilizando IA. El incidente se detectó de manera oportuna y se mitigó con éxito alertando a la parte afectada y colaborando con las organizaciones policiales. La desafortunada consecuencia es que los actores maliciosos robaron una gran cantidad de información, lo que generó riesgos de privacidad para los consumidores. Basándose en la inteligencia humana disponible (HUMINT), Resecurity ha adquirido artefactos adicionales relacionados con el incidente del actor:

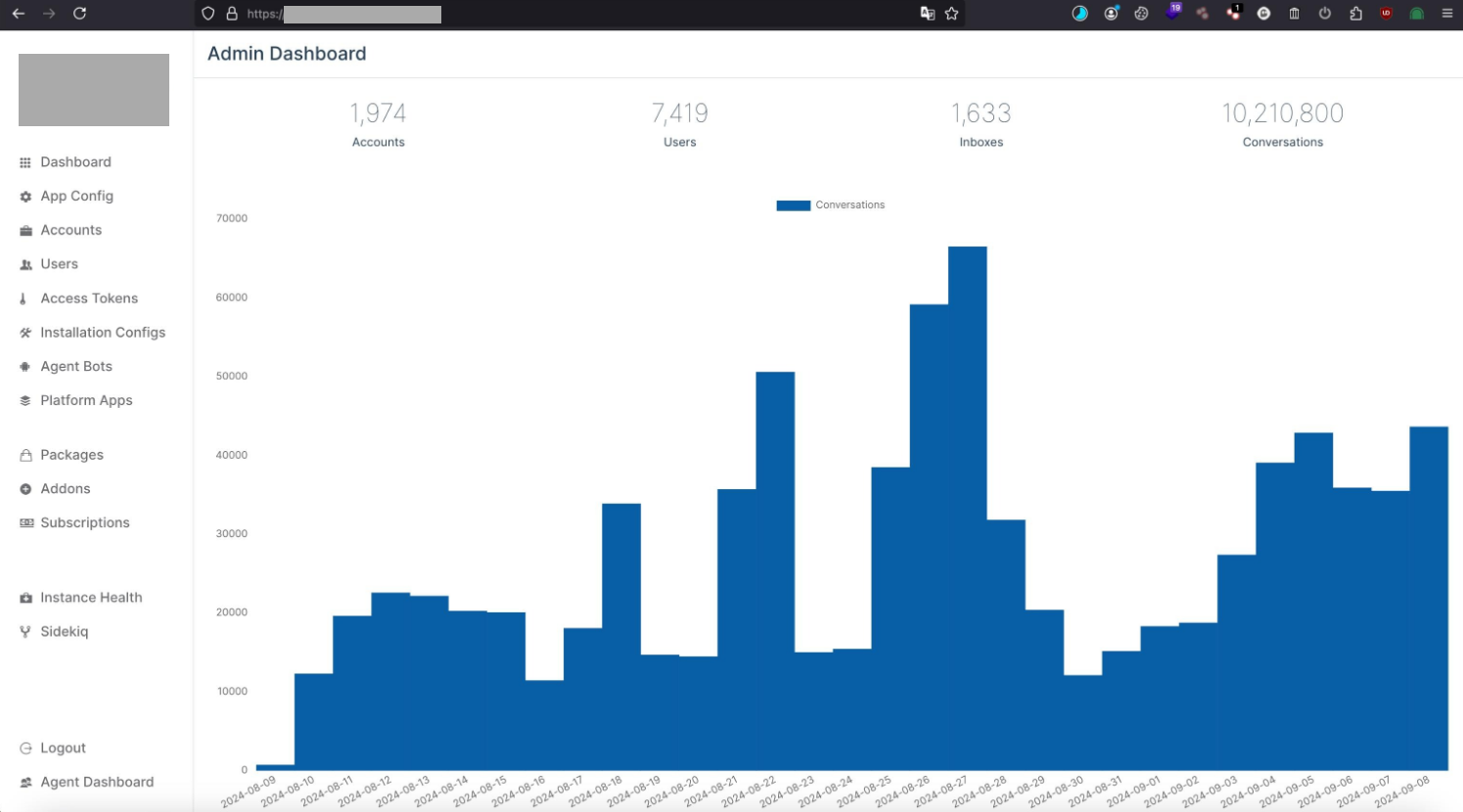

El actor de amenazas obtuvo acceso no autorizado al panel de administración de la plataforma, que contiene más de 10,210,800 conversaciones entre consumidores, operadores y agentes de IA (bots). Los datos robados podrían usarse para orquestar actividades fraudulentas avanzadas y campañas de ingeniería social, así como otras tácticas cibercriminales utilizando IA. El incidente se detectó de manera oportuna y se mitigó con éxito alertando a la parte afectada y colaborando con las organizaciones policiales. La desafortunada consecuencia es que los actores maliciosos robaron una gran cantidad de información, lo que generó riesgos de privacidad para los consumidores. Basándose en la inteligencia humana disponible (HUMINT), Resecurity ha adquirido artefactos adicionales relacionados con el incidente del actor:  \ Uno de los impactos significativos de la actividad maliciosa identificada (las comunicaciones vulneradas entre los agentes de IA y los consumidores) reveló información de identificación personal (PII), incluidos documentos de identidad nacionales y otros detalles confidenciales proporcionados para abordar solicitudes específicas. El adversario podría aplicar técnicas de extracción y minería de datos para adquirir registros de interés y utilizarlos en escenarios avanzados de phishing y otros fines ciberofensivos.

\ Uno de los impactos significativos de la actividad maliciosa identificada (las comunicaciones vulneradas entre los agentes de IA y los consumidores) reveló información de identificación personal (PII), incluidos documentos de identidad nacionales y otros detalles confidenciales proporcionados para abordar solicitudes específicas. El adversario podría aplicar técnicas de extracción y minería de datos para adquirir registros de interés y utilizarlos en escenarios avanzados de phishing y otros fines ciberofensivos.  ### Confianza en la plataforma de IA: precursora de la fuga de datos Como resultado del compromiso, los adversarios podrían acceder a sesiones específicas de clientes y robar datos y adquirir conocimiento sobre el contexto de interacción con el agente de IA, lo que más tarde podría conducir a un secuestro. Este vector puede ser especialmente eficaz en campañas fraudulentas y de ingeniería social cuando el adversario se centra en adquirir información de pago de la víctima utilizando algún pretexto de verificación KYC o soporte técnico de una institución financiera o red de pago específica. Muchas plataformas de IA conversacional permiten a los usuarios cambiar entre un operador asistido por IA y un humano: el actor malicioso podría interceptar la sesión y controlar aún más el diálogo. Al explotar la confianza del usuario, los actores maliciosos podrían solicitar que las víctimas proporcionen información confidencial u organicen ciertas acciones (por ejemplo, confirmar un OTP) que podrían usarse en esquemas fraudulentos. Resecurity prevé una variedad de esquemas de ingeniería social que podrían orquestarse mediante el abuso y la obtención de acceso a plataformas de IA conversacionales confiables.

### Confianza en la plataforma de IA: precursora de la fuga de datos Como resultado del compromiso, los adversarios podrían acceder a sesiones específicas de clientes y robar datos y adquirir conocimiento sobre el contexto de interacción con el agente de IA, lo que más tarde podría conducir a un secuestro. Este vector puede ser especialmente eficaz en campañas fraudulentas y de ingeniería social cuando el adversario se centra en adquirir información de pago de la víctima utilizando algún pretexto de verificación KYC o soporte técnico de una institución financiera o red de pago específica. Muchas plataformas de IA conversacional permiten a los usuarios cambiar entre un operador asistido por IA y un humano: el actor malicioso podría interceptar la sesión y controlar aún más el diálogo. Al explotar la confianza del usuario, los actores maliciosos podrían solicitar que las víctimas proporcionen información confidencial u organicen ciertas acciones (por ejemplo, confirmar un OTP) que podrían usarse en esquemas fraudulentos. Resecurity prevé una variedad de esquemas de ingeniería social que podrían orquestarse mediante el abuso y la obtención de acceso a plataformas de IA conversacionales confiables.  La víctima final (el consumidor) no se dará cuenta en absoluto si un adversario intercepta la sesión y seguirá interactuando con el agente de IA, pensando que la sesión es segura y que el curso de acción posterior es legítimo. El adversario puede explotar la confianza de la víctima en la plataforma de IA y obtener información confidencial, que más tarde podría usarse para fraude de pago y robo de identidad.

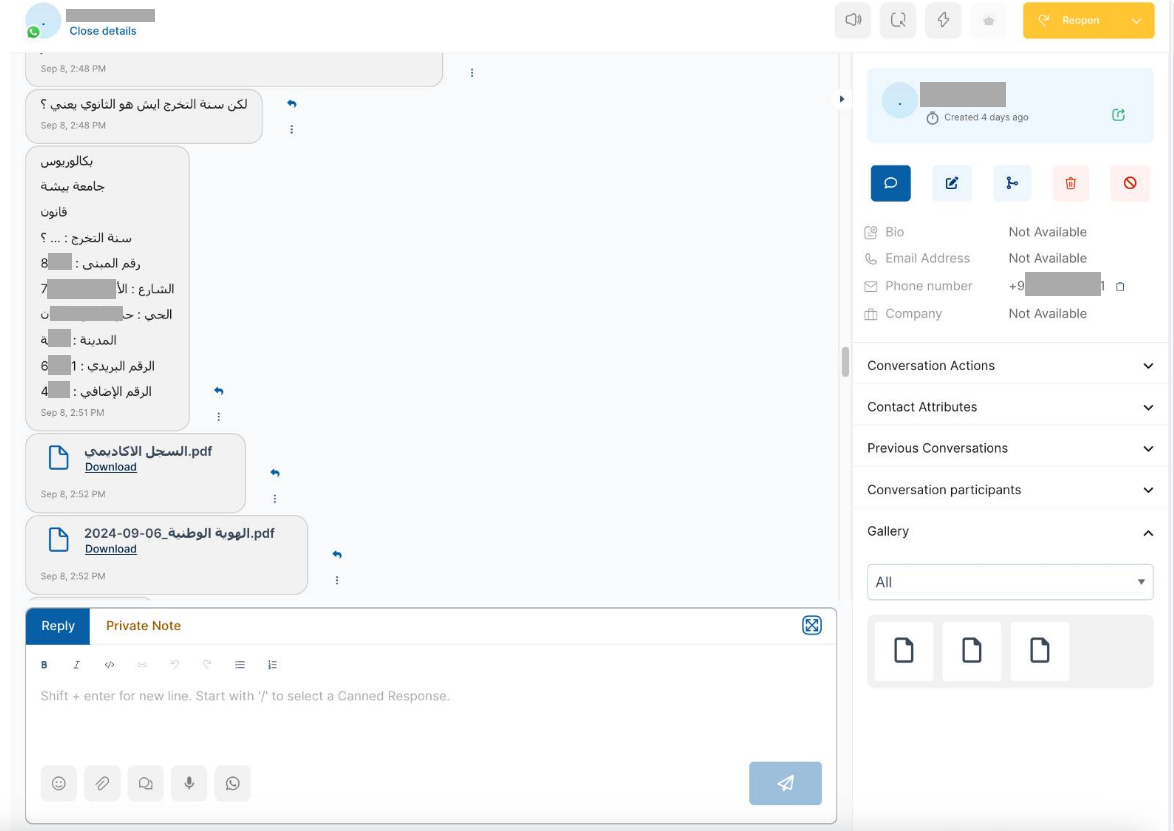

La víctima final (el consumidor) no se dará cuenta en absoluto si un adversario intercepta la sesión y seguirá interactuando con el agente de IA, pensando que la sesión es segura y que el curso de acción posterior es legítimo. El adversario puede explotar la confianza de la víctima en la plataforma de IA y obtener información confidencial, que más tarde podría usarse para fraude de pago y robo de identidad.  El problema con la información de identificación personal retenida se puede observar en las comunicaciones vulneradas que encuentra un adversario potencial en los datos de la plataforma de IA conversacional disponible y sus modelos. Por ejemplo, según uno de los estudios de caso publicado por el Centro Australiano de Seguridad Cibernética de la Dirección de Señales de Australia (ACSC de ASD) en colaboración con socios internacionales, los sistemas de IA alojados por terceros requieren una evaluación integral de los riesgos. En noviembre de 2023, un equipo de investigadores publicó los resultados de sus intentos de extraer datos de entrenamiento memorizados de los modelos de lenguaje de IA. Una de las aplicaciones con las que experimentaron los investigadores fue ChatGPT. En el caso de ChatGPT, los investigadores descubrieron que al pedirle al modelo que repitiera una palabra para siempre, el modelo divulgaba datos de entrenamiento a una tasa mucho mayor que cuando se comportaba de manera normal. Los datos de entrenamiento extraídos incluían información de identificación personal (PII). ### Sistemas de IA alojados por terceros: un riesgo importante para la cadena de suministro Además del problema de la información de identificación personal (PII) retenida almacenada en las comunicaciones entre el agente de IA y los usuarios finales, los actores maliciosos también pudieron apuntar a tokens de acceso, que las empresas podrían usar para la implementación del servicio con API de servicios y aplicaciones externos:

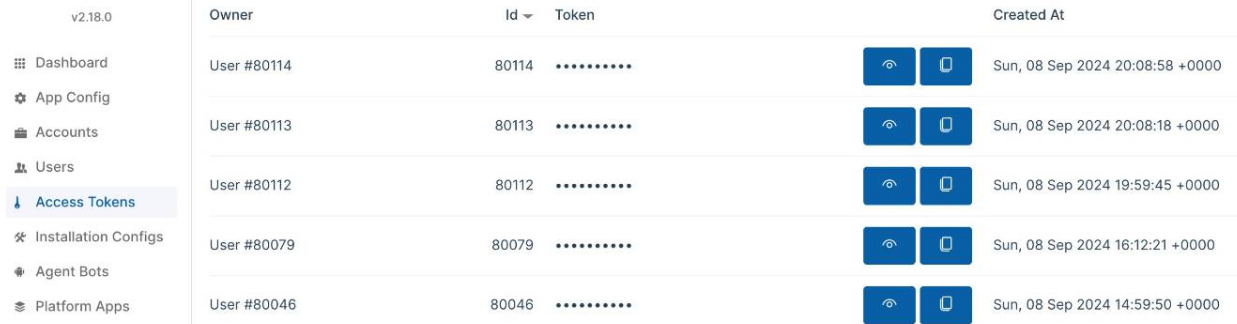

El problema con la información de identificación personal retenida se puede observar en las comunicaciones vulneradas que encuentra un adversario potencial en los datos de la plataforma de IA conversacional disponible y sus modelos. Por ejemplo, según uno de los estudios de caso publicado por el Centro Australiano de Seguridad Cibernética de la Dirección de Señales de Australia (ACSC de ASD) en colaboración con socios internacionales, los sistemas de IA alojados por terceros requieren una evaluación integral de los riesgos. En noviembre de 2023, un equipo de investigadores publicó los resultados de sus intentos de extraer datos de entrenamiento memorizados de los modelos de lenguaje de IA. Una de las aplicaciones con las que experimentaron los investigadores fue ChatGPT. En el caso de ChatGPT, los investigadores descubrieron que al pedirle al modelo que repitiera una palabra para siempre, el modelo divulgaba datos de entrenamiento a una tasa mucho mayor que cuando se comportaba de manera normal. Los datos de entrenamiento extraídos incluían información de identificación personal (PII). ### Sistemas de IA alojados por terceros: un riesgo importante para la cadena de suministro Además del problema de la información de identificación personal (PII) retenida almacenada en las comunicaciones entre el agente de IA y los usuarios finales, los actores maliciosos también pudieron apuntar a tokens de acceso, que las empresas podrían usar para la implementación del servicio con API de servicios y aplicaciones externos:  La manipulación de tokens puede provocar la inyección de datos maliciosos en los canales de integración compatibles e impactar negativamente a los consumidores finales de las plataformas de conversación de IA. Los resultados de los agentes de IA se podrían integrar en varias plataformas, y los bots se podrían agregar a otras aplicaciones como Discord, WhatsApp, Slack y Zapier. Debido a la penetración significativa de los sistemas de IA externos en la infraestructura empresarial y el procesamiento de volúmenes masivos de datos, su implementación sin una evaluación de riesgos adecuada debe considerarse un riesgo emergente de ciberseguridad en la cadena de suministro de TI. Según Gartner, las herramientas de IA de terceros plantean riesgos de confidencialidad de los datos. A medida que su organización integra modelos y herramientas de IA de proveedores externos, también absorbe los grandes conjuntos de datos utilizados para entrenar esos modelos de IA. Sus usuarios podrían acceder a datos confidenciales dentro de los modelos de IA de otros, lo que potencialmente crea consecuencias regulatorias, comerciales y de reputación para su organización. ### Espectro de ataques contra sistemas habilitados para IA El espectro de tácticas y técnicas adversas contra sistemas habilitados para IA basadas en observaciones de ataques del mundo real se define en la Matriz MITRE ATLAS. Proporciona un marco para identificar y abordar vulnerabilidades en los sistemas de IA, lo que puede ayudar a prevenir ataques y proteger datos confidenciales, y permite a los investigadores navegar por el panorama de amenazas a los sistemas de inteligencia artificial.

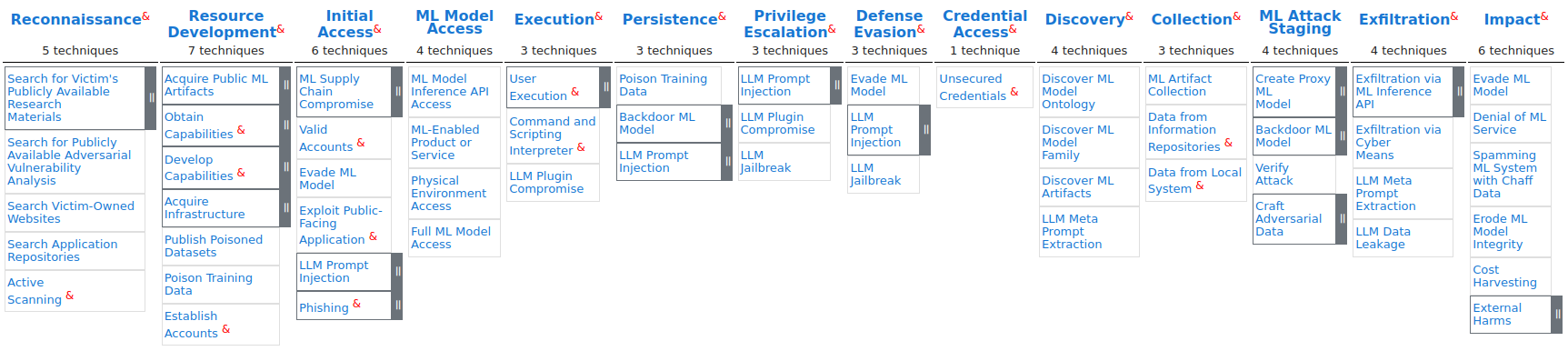

La manipulación de tokens puede provocar la inyección de datos maliciosos en los canales de integración compatibles e impactar negativamente a los consumidores finales de las plataformas de conversación de IA. Los resultados de los agentes de IA se podrían integrar en varias plataformas, y los bots se podrían agregar a otras aplicaciones como Discord, WhatsApp, Slack y Zapier. Debido a la penetración significativa de los sistemas de IA externos en la infraestructura empresarial y el procesamiento de volúmenes masivos de datos, su implementación sin una evaluación de riesgos adecuada debe considerarse un riesgo emergente de ciberseguridad en la cadena de suministro de TI. Según Gartner, las herramientas de IA de terceros plantean riesgos de confidencialidad de los datos. A medida que su organización integra modelos y herramientas de IA de proveedores externos, también absorbe los grandes conjuntos de datos utilizados para entrenar esos modelos de IA. Sus usuarios podrían acceder a datos confidenciales dentro de los modelos de IA de otros, lo que potencialmente crea consecuencias regulatorias, comerciales y de reputación para su organización. ### Espectro de ataques contra sistemas habilitados para IA El espectro de tácticas y técnicas adversas contra sistemas habilitados para IA basadas en observaciones de ataques del mundo real se define en la Matriz MITRE ATLAS. Proporciona un marco para identificar y abordar vulnerabilidades en los sistemas de IA, lo que puede ayudar a prevenir ataques y proteger datos confidenciales, y permite a los investigadores navegar por el panorama de amenazas a los sistemas de inteligencia artificial.  Al utilizar la matriz MITRE ATLAS, Resecurity asignó la actividad maliciosa observada a los TTP clave: - AML.T0012\ Cuentas válidas - AML.T0049\ Explotar aplicación pública - AML.T0052\ Suplantación de identidad - AML.T0055\ Credenciales no seguras - AML.T0007\ Descubrimiento de artefactos de ML - AML.T0035\ Recopilación de artefactos de ML - AML.T0043\ Elaborar datos adversarios - AML.T0025\ Exfiltración a través de medios cibernéticos - AML.T0024\ Exfiltración a través de la API de interfaz de ML - AML.T0048\ Daños externos (impacto financiero) ### Medidas de mitigación Resecurity destaca la importancia de un programa integral de gestión de la confianza, el riesgo y la seguridad de la IA (TRiSM) para garantizar de forma proactiva que los sistemas de IA cumplan las normas, sean justos, fiables y protejan la privacidad de los datos. La Ley de IA de la UE y otros marcos regulatorios en América del Norte, China e India ya están estableciendo regulaciones para gestionar los riesgos de las aplicaciones de IA. Por ejemplo, las recientes Directrices de IA del PDPC en Singapur ya alientan a las empresas a ser más transparentes al solicitar el consentimiento para el uso de datos personales a través de la divulgación y las notificaciones. Las empresas tienen que asegurarse de que los sistemas de IA sean confiables, brindando así a los consumidores confianza en cómo se utilizan sus datos personales. De acuerdo con los Principios para tecnologías de inteligencia artificial generativa responsables, confiables y protectoras de la privacidad publicados por la Oficina del Comisionado de Privacidad de Canadá y otros reguladores de la industria, es fundamental realizar evaluaciones, como Evaluaciones de impacto sobre la privacidad (PIA), para identificar y mitigar los impactos potenciales o conocidos que un sistema de inteligencia artificial generativa (o su uso propuesto, según corresponda) pueda tener sobre la privacidad. Según las Mejores prácticas para implementar sistemas de IA seguros y resistentes publicadas de la Agencia de Seguridad Nacional (NSA), los expertos recomiendan adoptar una mentalidad de confianza cero (ZT), que supone que una infracción es inevitable o que ya se ha producido. Teniendo en cuenta la actividad maliciosa observada que implica el compromiso de las plataformas de IA conversacional y su impacto significativo en la privacidad del cliente, Resecurity puede enfatizar la importancia de las comunicaciones seguras entre los agentes de IA y los consumidores finales. Esto incluye minimizar la retención de información de identificación personal (PII) y adoptar un enfoque proactivo para la ciberseguridad de la cadena de suministro en el contexto de soluciones de IA alojadas por terceros. ### Importancia Las plataformas de IA conversacional se han convertido en un elemento crítico de la cadena de suministro de TI moderna para las grandes empresas y agencias gubernamentales. Su protección requerirá un equilibrio entre las medidas de ciberseguridad tradicionales relevantes para SaaS (Software-as-a-Service) y aquellas especializadas y adaptadas a las particularidades de la IA. En algún momento, las plataformas de IA conversacional comienzan a reemplazar los canales de comunicación tradicionales. En lugar de la mensajería de correo electrónico "de la vieja escuela", estas plataformas permiten la interacción a través de agentes de IA que brindan respuestas rápidas y brindan navegación de múltiples niveles a través de los servicios de interés casi en tiempo real. La evolución de la tecnología también ha llevado a ajustes en las tácticas por parte de los adversarios que buscan explotar las últimas tendencias y dinámicas en el mercado global de las TIC para su propio beneficio. Resecurity detectó un interés notable tanto de la comunidad cibercriminal como de los actores estatales en las plataformas de IA conversacional, debido a una cantidad considerable de consumidores y volúmenes masivos de información procesada durante las interacciones y sesiones personalizadas respaldadas por IA. Los cibercriminales apuntarán a las plataformas de IA conversacional debido a la aparición de nuevas ofertas orientadas al consumidor. Por ejemplo, este año China lanzó el prototipo de un hospital con inteligencia artificial (https://www.globaltimes.cn/page/202405/1313235.shtml) para mostrar un enfoque innovador de la atención médica, en el que los asistentes de enfermería y los médicos virtuales interactuarán con los pacientes. Estas innovaciones pueden crear riesgos significativos para la privacidad de los pacientes a largo plazo, ya que la IA conversacional puede transmitir y procesar información confidencial sobre los datos de atención médica. La IA conversacional ya está revolucionando la industria bancaria y de tecnología financiera al automatizar la atención al cliente, brindar orientación financiera personalizada y mejorar la eficiencia transaccional, mejorando la satisfacción del cliente y la efectividad operativa. Estos ejemplos prueban las diversas aplicaciones de la IA conversacional, que van desde los asistentes virtuales orientados al consumidor hasta los sistemas de automatización y soporte a nivel empresarial. A medida que la tecnología continúe evolucionando, podemos esperar ver casos de uso aún más creativos para la IA conversacional en el futuro, y nuevas amenazas de ciberseguridad dirigidas a dichas tecnologías y a los usuarios finales. ### Referencias - Mitigación de riesgos emergentes y amenazas de seguridad de agentes de IA\ https://securitymea.com/2024/09/10/mitigate-emerging-risks-and-security-threats-from-ai-agents/ - Abordar la confianza, el riesgo y la seguridad en los modelos de IA\ https://www.gartner.com/en/articles/what-it-takes-to-make-ai-safe-and-effective - Principios para tecnologías de IA generativas responsables, confiables y que protejan la privacidad\ https://www.priv.gc.ca/en/privacy-topics/technology/artificial-intelligence/gd_principles_ai/- Interacción con la inteligencia artificial (IA)\ https://media.defense.gov/2024/Jan/23/2003380135/-1/-1/0/CSI-ENGAGING-WITH-ARTIFICIAL-INTELLIGENCE.P...

Al utilizar la matriz MITRE ATLAS, Resecurity asignó la actividad maliciosa observada a los TTP clave: - AML.T0012\ Cuentas válidas - AML.T0049\ Explotar aplicación pública - AML.T0052\ Suplantación de identidad - AML.T0055\ Credenciales no seguras - AML.T0007\ Descubrimiento de artefactos de ML - AML.T0035\ Recopilación de artefactos de ML - AML.T0043\ Elaborar datos adversarios - AML.T0025\ Exfiltración a través de medios cibernéticos - AML.T0024\ Exfiltración a través de la API de interfaz de ML - AML.T0048\ Daños externos (impacto financiero) ### Medidas de mitigación Resecurity destaca la importancia de un programa integral de gestión de la confianza, el riesgo y la seguridad de la IA (TRiSM) para garantizar de forma proactiva que los sistemas de IA cumplan las normas, sean justos, fiables y protejan la privacidad de los datos. La Ley de IA de la UE y otros marcos regulatorios en América del Norte, China e India ya están estableciendo regulaciones para gestionar los riesgos de las aplicaciones de IA. Por ejemplo, las recientes Directrices de IA del PDPC en Singapur ya alientan a las empresas a ser más transparentes al solicitar el consentimiento para el uso de datos personales a través de la divulgación y las notificaciones. Las empresas tienen que asegurarse de que los sistemas de IA sean confiables, brindando así a los consumidores confianza en cómo se utilizan sus datos personales. De acuerdo con los Principios para tecnologías de inteligencia artificial generativa responsables, confiables y protectoras de la privacidad publicados por la Oficina del Comisionado de Privacidad de Canadá y otros reguladores de la industria, es fundamental realizar evaluaciones, como Evaluaciones de impacto sobre la privacidad (PIA), para identificar y mitigar los impactos potenciales o conocidos que un sistema de inteligencia artificial generativa (o su uso propuesto, según corresponda) pueda tener sobre la privacidad. Según las Mejores prácticas para implementar sistemas de IA seguros y resistentes publicadas de la Agencia de Seguridad Nacional (NSA), los expertos recomiendan adoptar una mentalidad de confianza cero (ZT), que supone que una infracción es inevitable o que ya se ha producido. Teniendo en cuenta la actividad maliciosa observada que implica el compromiso de las plataformas de IA conversacional y su impacto significativo en la privacidad del cliente, Resecurity puede enfatizar la importancia de las comunicaciones seguras entre los agentes de IA y los consumidores finales. Esto incluye minimizar la retención de información de identificación personal (PII) y adoptar un enfoque proactivo para la ciberseguridad de la cadena de suministro en el contexto de soluciones de IA alojadas por terceros. ### Importancia Las plataformas de IA conversacional se han convertido en un elemento crítico de la cadena de suministro de TI moderna para las grandes empresas y agencias gubernamentales. Su protección requerirá un equilibrio entre las medidas de ciberseguridad tradicionales relevantes para SaaS (Software-as-a-Service) y aquellas especializadas y adaptadas a las particularidades de la IA. En algún momento, las plataformas de IA conversacional comienzan a reemplazar los canales de comunicación tradicionales. En lugar de la mensajería de correo electrónico "de la vieja escuela", estas plataformas permiten la interacción a través de agentes de IA que brindan respuestas rápidas y brindan navegación de múltiples niveles a través de los servicios de interés casi en tiempo real. La evolución de la tecnología también ha llevado a ajustes en las tácticas por parte de los adversarios que buscan explotar las últimas tendencias y dinámicas en el mercado global de las TIC para su propio beneficio. Resecurity detectó un interés notable tanto de la comunidad cibercriminal como de los actores estatales en las plataformas de IA conversacional, debido a una cantidad considerable de consumidores y volúmenes masivos de información procesada durante las interacciones y sesiones personalizadas respaldadas por IA. Los cibercriminales apuntarán a las plataformas de IA conversacional debido a la aparición de nuevas ofertas orientadas al consumidor. Por ejemplo, este año China lanzó el prototipo de un hospital con inteligencia artificial (https://www.globaltimes.cn/page/202405/1313235.shtml) para mostrar un enfoque innovador de la atención médica, en el que los asistentes de enfermería y los médicos virtuales interactuarán con los pacientes. Estas innovaciones pueden crear riesgos significativos para la privacidad de los pacientes a largo plazo, ya que la IA conversacional puede transmitir y procesar información confidencial sobre los datos de atención médica. La IA conversacional ya está revolucionando la industria bancaria y de tecnología financiera al automatizar la atención al cliente, brindar orientación financiera personalizada y mejorar la eficiencia transaccional, mejorando la satisfacción del cliente y la efectividad operativa. Estos ejemplos prueban las diversas aplicaciones de la IA conversacional, que van desde los asistentes virtuales orientados al consumidor hasta los sistemas de automatización y soporte a nivel empresarial. A medida que la tecnología continúe evolucionando, podemos esperar ver casos de uso aún más creativos para la IA conversacional en el futuro, y nuevas amenazas de ciberseguridad dirigidas a dichas tecnologías y a los usuarios finales. ### Referencias - Mitigación de riesgos emergentes y amenazas de seguridad de agentes de IA\ https://securitymea.com/2024/09/10/mitigate-emerging-risks-and-security-threats-from-ai-agents/ - Abordar la confianza, el riesgo y la seguridad en los modelos de IA\ https://www.gartner.com/en/articles/what-it-takes-to-make-ai-safe-and-effective - Principios para tecnologías de IA generativas responsables, confiables y que protejan la privacidad\ https://www.priv.gc.ca/en/privacy-topics/technology/artificial-intelligence/gd_principles_ai/- Interacción con la inteligencia artificial (IA)\ https://media.defense.gov/2024/Jan/23/2003380135/-1/-1/0/CSI-ENGAGING-WITH-ARTIFICIAL-INTELLIGENCE.P...