Incidentes Asociados

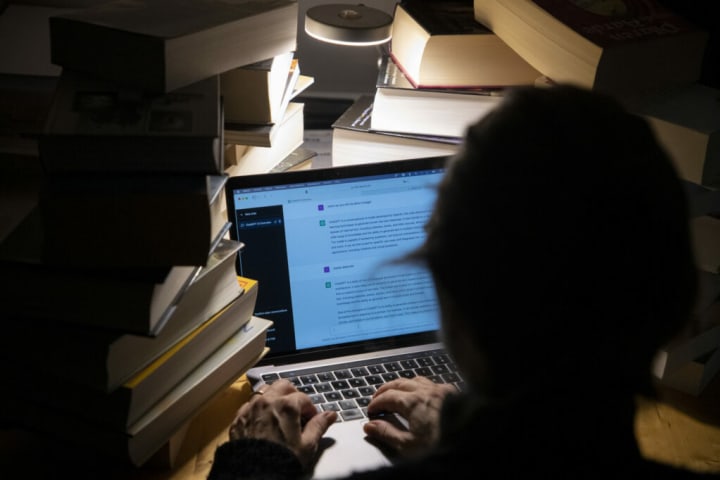

Un joven belga se suicidó recientemente después de hablar con un chatbot llamado ELIZA durante varias semanas, lo que generó llamados para una mejor protección de los ciudadanos y la necesidad de crear conciencia.

"Sin estas conversaciones con el chatbot, mi esposo todavía estaría aquí", dijo la viuda del hombre. Ella y su difunto esposo tenían treinta y tantos años, vivían una vida cómoda y tenían dos hijos pequeños, según [La Libre](https://www.lalibre.be/belgique/societe/2023/03/28/sans- ces-conversations-avec-le-chatbot-eliza-mon-mari-serait-toujours-la-LVSLWPC5WRDX7J2RCHNWPDST24/).

Sin embargo, hace unos dos años, comenzaron a aparecer los primeros signos de problemas. El hombre se volvió muy ansioso por el medio ambiente y encontró refugio en ELIZA, el nombre que se le da a un chatbot que usa GPT-J, un modelo de lenguaje de inteligencia artificial de código abierto desarrollado por EleutherAI. Después de seis semanas de intensos intercambios, se quitó la vida.

La semana pasada, la familia habló con Mathieu Michel, Secretario de Estado de Digitalización, encargado de Simplificación Administrativa, Privacidad y Ordenación de los Edificios. Destacó que este caso destaca que es "imprescindible definir claramente las responsabilidades".

"Estoy particularmente impactado por la tragedia de esta familia", dijo el martes, y agregó que si bien las "posibilidades de ChatGPT son infinitas, los peligros de su uso también son una realidad que debe ser considerada". Lo que sucedió es un grave precedente que hay que tomarlo muy en serio".

Medidas urgentes para evitar tragedias

Para evitar tal tragedia en el futuro inmediato, argumentó que es fundamental identificar la naturaleza de las responsabilidades que conducen a este tipo de eventos.

"Por supuesto, todavía tenemos que aprender a vivir con algoritmos, pero bajo ninguna circunstancia el uso de ninguna tecnología debe llevar a los editores de contenido a eludir sus propias responsabilidades", señaló.

OpenAI mismo ha admitido que ChatGPT puede producir respuestas dañinas y sesgadas, y agregó que espera mitigar el problema recopilando comentarios de los usuarios.

A largo plazo, Michel señaló que es esencial crear conciencia sobre el impacto de los algoritmos en la vida de las personas al "permitir que todos entiendan la naturaleza del contenido al que se enfrentan las personas en línea". Aquí, se refirió a las nuevas tecnologías como los chatbots, pero también a las falsificaciones profundas, un tipo de inteligencia artificial que puede crear imágenes convincentes, engaños de audio y video, que pueden probar y distorsionar la percepción de la realidad de las personas.

Michel agregó que los ciudadanos también deben estar adecuadamente protegidos de ciertas aplicaciones de inteligencia artificial que "presentan un riesgo significativo".

La Unión Europea busca regular el uso de la inteligencia artificial con una Ley de IA, en la que ha estado trabajando durante los últimos dos años. Michel ha creado un grupo de trabajo para analizar el texto que actualmente está preparando la UE para proponer los ajustes necesarios.