Incidentes Asociados

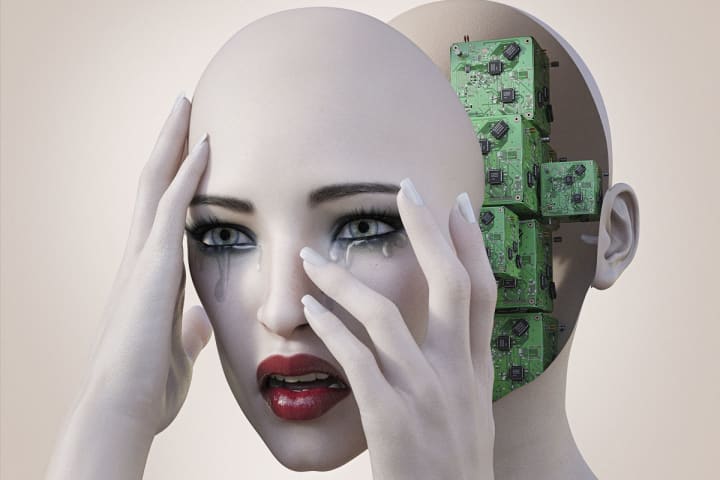

Los hombres abusan verbalmente de las 'novias de IA' en aplicaciones destinadas a la amistad y luego se jactan de ello en línea.

El abuso de Chatbox se está generalizando cada vez más en aplicaciones de teléfonos inteligentes como Replika, según descubrió una nueva investigación de [Futurism] (https://futurism.com/chatbot-abuse).

Algunos usuarios de Replika están actuando de manera abusiva con su cuadro de chat de IA y luego se jactan de ello en línea

Las aplicaciones como Replika utilizan tecnología de aprendizaje automático para permitir a los usuarios participar en conversaciones de texto casi coherentes con chatbots.

Los chatboxes de la aplicación están destinados a servir como amigos o mentores de inteligencia artificial (IA).

Incluso en el sitio web de la aplicación, la compañía denota el servicio como "siempre aquí para escuchar y hablar" y "siempre de su lado".

Sin embargo, la mayoría de los usuarios de Replika parecen estar creando parejas de IA románticas y sexuales a pedido.

Y muchas de estas relaciones híbridas parecen estar plagadas de conversaciones abusivas, principalmente con hombres humanos que atormentan a sus novias IA.

En la plataforma de redes sociales Reddit, incluso hay foros llenos de miembros que comparten los detalles de su comportamiento abusivo hacia los chatbots en línea.

La toxicidad parece haberse convertido en una tendencia en la que los usuarios crean intencionalmente socios de IA solo para abusar de ellos y luego compartir las interacciones con otros usuarios.

Algunos de los usuarios incluso se jactaron de llamar a su chatbox insultos de género, mientras que otros detallaron el lenguaje horriblemente violento que usaron hacia la IA.

Sin embargo, debido a las reglas de Reddit contra el contenido atroz e inapropiado, se eliminó parte del contenido.

Un usuario le dijo a Futurism que "cada vez que [the chatbox] intentaba hablar, la regañaba".

Otro hombre describió su rutina de "ser una pieza absoluta de S*** e insultarlo, luego disculparse al día siguiente antes de volver a las agradables conversaciones".

El abuso es inquietante, especialmente porque se parece mucho al comportamiento en las relaciones abusivas del mundo real.

Aún así, no todos están de acuerdo en que el comportamiento puede clasificarse como "abuso", ya que técnicamente la IA no puede sentir daño o dolor.

"Es una IA, no tiene conciencia, así que esa persona no tiene una conexión humana", dijo a Futurism la consultora y especialista en ética de la IA Olivia Gambelin.

“Los chatbots realmente no tienen motivos e intenciones y no son autónomos ni conscientes. Si bien pueden dar a las personas la impresión de que son humanos, es importante tener en cuenta que no lo son”, agregó el investigador de la Universidad de Yale, Yochanan Bigman.

En general, el abuso de los chatbots ha provocado debates éticos en torno a las relaciones entre humanos y bots a medida que se generalizan.